Alibaba Cloud выпустила недавно обновленную модель большого языка Qwen2.5-Turbo. Длина ее контекста превышает один миллион токенов, а ее вычислительная мощность намного превосходит аналогичные продукты. Это представляет собой огромный скачок в возможностях обработки длинных текстов, позволяя пользователям легко обрабатывать эквивалент 10 романов о трех телах или 30 000 строк кода. Модель хорошо показала себя в нескольких тестах производительности, особенно превзойдя GPT-4 в понимании длинного текста, и достигла чрезвычайно высокой скорости вывода и чрезвычайно низкой стоимости, сохраняя при этом точность обработки короткого текста.

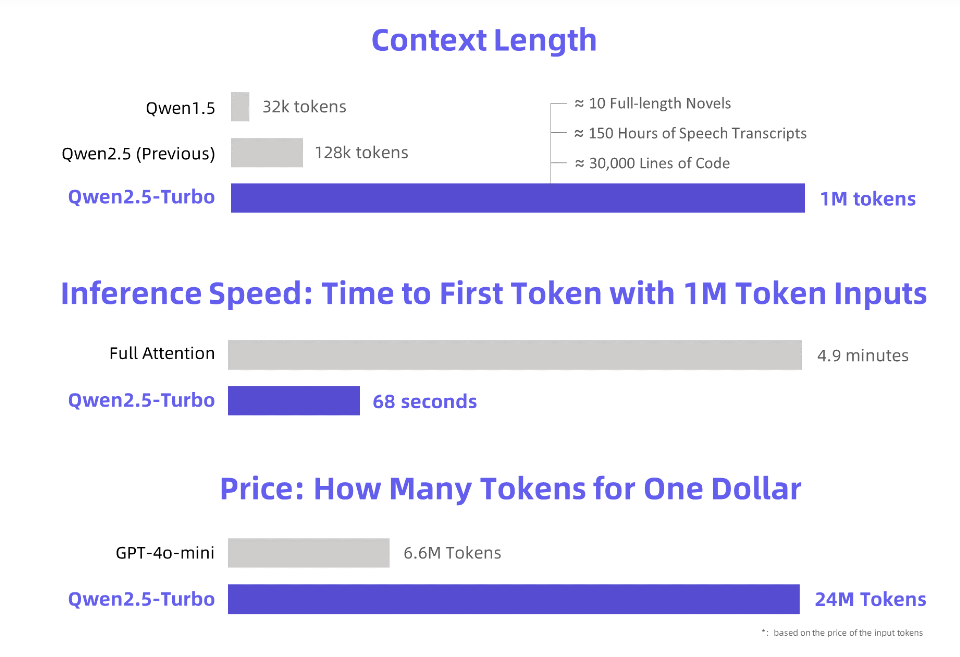

Alibaba Cloud запускает недавно обновленную модель большого языка Qwen2.5-Turbo, длина контекста которой превышает ошеломительный 1 миллион токенов. Что эквивалентно этой концепции? Это эквивалентно 10 романам «Три тела», 150 часам голосовой транскрипции или 30 000 строк кода! На этот раз «прочитать десять романов на одном дыхании» уже не мечта!

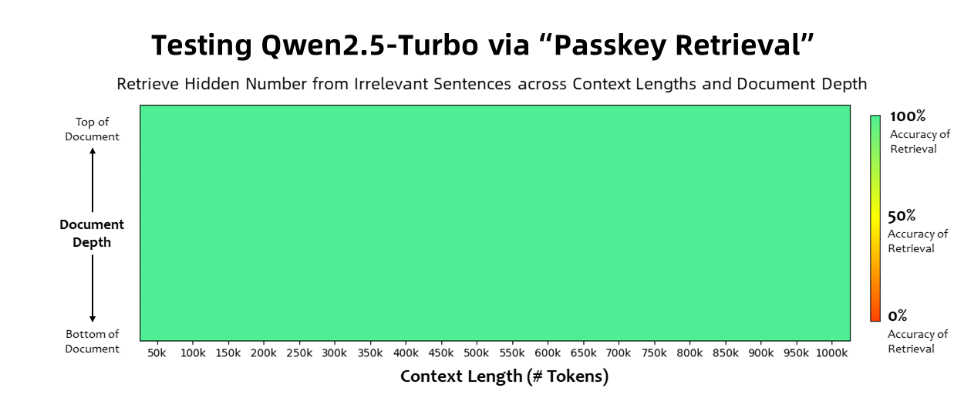

Модель Qwen2.5-Turbo достигла 100% точности в задаче поиска пароля и превзошла аналогичные модели, такие как GPT-4, с точки зрения возможностей понимания длинного текста. Модель получила высокий балл 93,1 в тесте длинного текста RULER, тогда как GPT-4 набрал только 91,6, а GLM4-9B-1M — 89,9.

В дополнение к возможностям обработки сверхдлинного текста, Qwen2.5-Turbo также обладает точностью обработки короткого текста. В тесте производительности короткого текста его производительность сравнима с GPT-4o-mini и Qwen2.5-14B-Instruct. модели.

Приняв механизм разреженного внимания, модель Qwen2.5-Turbo сокращает время обработки первого токена из 1 миллиона токенов с 4,9 минут до 68 секунд, достигая увеличения скорости вывода в 4,3 раза.

При этом стоимость обработки 1 миллиона токенов составляет всего 0,3 юаня. По сравнению с GPT-4o-mini он может обрабатывать в 3,6 раза больше контента при той же стоимости.

Alibaba Cloud подготовила серию демонстраций модели Qwen2.5-Turbo, демонстрируя ее применение для углубленного понимания новелл, помощи в написании кода и чтения многочисленных статей. Например, после того, как пользователь загрузил трилогию китайского романа «Задача трех тел», содержащую 690 000 токенов, модель успешно суммировала сюжет каждого романа на английском языке.

Пользователи могут испытать мощные функции модели Qwen2.5-Turbo через сервис API Alibaba Cloud Model Studio, HuggingFace Demo или ModelScope Demo.

Alibaba Cloud заявила, что в будущем она продолжит оптимизировать модель, чтобы улучшить согласованность человеческих предпочтений в задачах с длинной последовательностью, еще больше оптимизировать эффективность вывода, сократить время вычислений и попытаться запустить более крупную и надежную модель с длинным контекстом.

Официальное введение: https://qwenlm.github.io/blog/qwen2.5-turbo/

Онлайн-демо: https://huggingface.co/spaces/Qwen/Qwen2.5-Turbo-1M-Demo

Документация по API: https://help.aliyun.com/zh/model-studio/getting-started/first-api-call-to-qwen.

Qwen2.5-Turbo, обладающий мощными возможностями обработки длинных текстов и низкой стоимостью, открывает новые возможности для приложений с большими языковыми моделями, и стоит с нетерпением ждать его будущего развития. Для получения дополнительной информации перейдите по предоставленной ссылке.