Снижение стоимости обучения больших моделей — актуальная тема исследований в области искусственного интеллекта. В недавнем исследовании, опубликованном командой Tencent Hunyuan, подробно обсуждаются правила масштабирования обучения низкоразрядному квантованию с плавающей запятой, что дает новые идеи для эффективного обучения больших моделей. Посредством большого количества экспериментов в этом исследовании было проанализировано влияние таких факторов, как размер модели, объем обучающих данных и точность количественного определения, на эффект обучения, и, наконец, были разработаны правила того, как эффективно распределять ресурсы обучения с различной точностью для получения лучшие результаты. Это исследование имеет не только важное теоретическое значение, но и дает ценные рекомендации для практического применения больших моделей.

Сегодня, с быстрым развитием модели большого языка (LLM), стоимость обучения модели и вывода все чаще становится в центре внимания исследований и приложений. Недавно команда Tencent Hunyuan опубликовала важное исследование, в котором глубоко изучены «Законы масштабирования» обучения низкоразрядному квантованию с плавающей запятой, то есть закон масштабирования обучения количественному измерению с плавающей запятой. Целью этого исследования является изучение того, как значительно сократить затраты на вычисления и хранение без потери производительности за счет снижения точности модели.

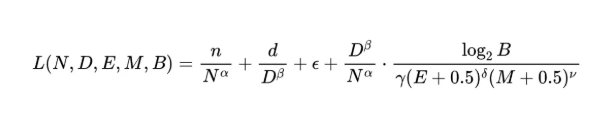

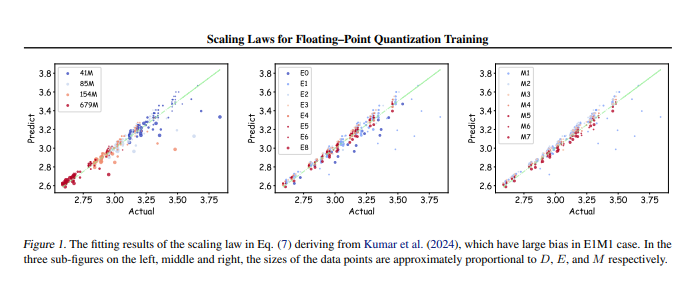

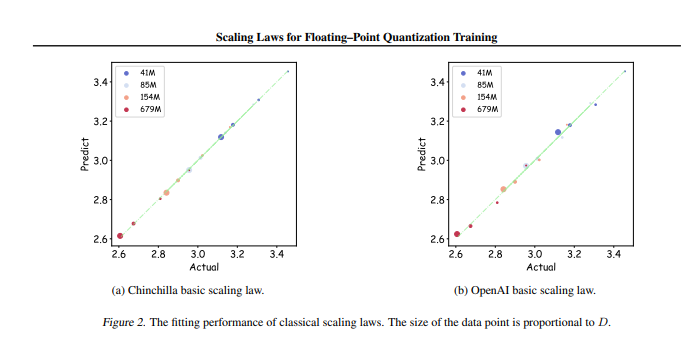

Исследовательская группа провела до 366 наборов обучения количественному анализу с плавающей запятой с различными размерами параметров и точностью и систематически анализировала различные факторы, влияющие на эффект обучения, включая размер модели (N), объем обучающих данных (D), экспоненциальный бит ( E), биты мантиссы (M) и степень детализации квантования (B). Благодаря этим экспериментам исследователи получили единый набор законов масштабирования, который показал, как эффективно настраивать обучающие данные и параметры модели с различной точностью для получения наилучшего эффекта обучения.

Самое важное то, что исследования показывают, что при произвольном обучении количественному анализу с плавающей запятой низкой точности существует «эффект ограничения», то есть при определенном объеме данных производительность модели достигнет оптимальной и превысит такой объем данных может привести к снижению производительности. Кроме того, исследование также показало, что теоретически лучшая экономичная точность обучения количественному определению с плавающей запятой должна составлять от 4 до 8 бит, что имеет важное руководящее значение для разработки эффективного LLM.

Это исследование не только заполняет пробел в области обучения количественному анализу чисел с плавающей запятой, но также предоставляет справочную информацию для будущих производителей оборудования, которая поможет им оптимизировать возможности вычислений с плавающей запятой при различной точности. В конечном счете, это исследование дает четкое направление для практики обучения на больших моделях, гарантируя, что эффективный эффект обучения может быть достигнут даже при ограниченных ресурсах.

Адрес статьи: https://arxiv.org/pdf/2501.02423

Короче говоря, это исследование команды Tencent Hunyuan предлагает эффективное решение для снижения затрат на обучение больших моделей. Обнаруженные правила масштабирования и оптимальный диапазон точности окажут глубокое влияние на разработку и применение больших моделей в будущем. Эта работа указывает направление для высокопроизводительного и недорогого обучения больших моделей, которое заслуживает внимания и углубленного исследования.