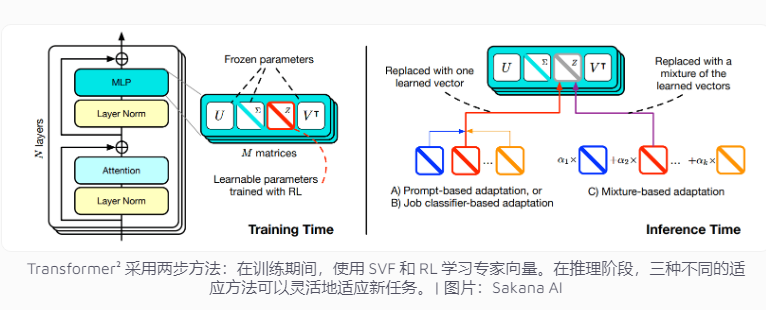

Японская компания Sakana AI недавно выпустила Transformer², инновационную технологию, предназначенную для улучшения адаптивности задач языковой модели. В отличие от традиционных систем искусственного интеллекта, которым необходимо обрабатывать несколько задач одновременно, Transformer² использует двухэтапное обучение, используя экспертные векторы и технологию точной настройки по единственному значению (SVF), что позволяет ему эффективно адаптироваться к новым задачам без переобучения всей сети, что значительно улучшает Это значительно снижает потребление ресурсов и повышает гибкость и точность модели. Эта технология фокусируется на конкретных задачах, таких как математические операции, программирование и логические рассуждения, путем изучения экспертных векторов, которые контролируют важность сетевых соединений, и сочетает в себе обучение с подкреплением для дальнейшей оптимизации производительности модели.

Современные системы искусственного интеллекта обычно должны решать несколько задач за одно обучение. Однако они склонны сталкиваться с неожиданными проблемами при решении новых задач, что приводит к ограниченной адаптивности модели. Концепция проектирования Transformer² направлена на решение этой проблемы с использованием технологии экспертного вектора и точной настройки сингулярного значения (SVF), благодаря чему модель может гибко справляться с новыми задачами без переобучения всей сети.

Традиционные методы обучения требуют корректировки весов всей нейронной сети, что не только затратно, но и может привести к тому, что модель «забудет» ранее полученные знания. Напротив, методы SVF позволяют избежать этих проблем за счет изучения экспертных векторов, которые контролируют важность каждого сетевого соединения. Экспертные векторы помогают модели сосредоточиться на конкретных задачах, таких как математические операции, программирование и логические рассуждения, путем корректировки весовой матрицы сетевых соединений.

Такой подход существенно сокращает количество параметров, необходимых для адаптации модели к новым задачам. Например, метод LoRA требует 6,82 миллиона параметров, а SVF — всего 160 000 параметров. Это не только снижает потребление памяти и вычислительной мощности, но и не позволяет модели забыть другие знания, сосредоточившись на определенной задаче. Самое главное, что эти экспертные векторы могут эффективно работать вместе, улучшая адаптируемость модели к различным задачам.

Для дальнейшего улучшения адаптивности Transformer² вводит обучение с подкреплением. В процессе обучения модель постоянно оптимизирует экспертные векторы, предлагая решения задач и получая обратную связь, тем самым улучшая производительность при выполнении новых задач. Команда разработала три стратегии для использования этих экспертных знаний: адаптивные подсказки, классификаторы задач и адаптация с небольшим количеством шагов. В частности, адаптивная стратегия с несколькими выстрелами еще больше повышает гибкость и точность модели за счет анализа примеров новых задач и корректировки экспертных векторов.

Transformer² превосходит традиционный метод LoRA по нескольким критериям. На математических задачах его производительность выросла на 16%, а требуемые параметры существенно сократились. При решении новой задачи точность Transformer² оказалась на 4% выше, чем у исходной модели, а LoRA не смогла достичь ожидаемых результатов.

Transformer² не только решает сложные математические задачи, но также сочетает в себе возможности программирования и логического рассуждения для обеспечения междоменного обмена знаниями. Например, команда обнаружила, что модели меньшего размера также могут повысить производительность за счет использования знаний более крупных моделей путем передачи экспертных векторов, что обеспечивает новые возможности для обмена знаниями между моделями.

Хотя Transformer² добился значительного прогресса в адаптивности задач, он все еще сталкивается с некоторыми ограничениями. В настоящее время экспертные векторы, обученные с использованием SVF, могут полагаться только на существующие возможности предварительно обученной модели и не могут добавлять совершенно новые навыки. Настоящее непрерывное обучение означает, что модель может самостоятельно освоить новые навыки. Для достижения этой цели все равно требуется время. Как масштабировать эту технику на больших моделях с более чем 70 миллиардами параметров остается открытым вопросом.

В целом Transformer² демонстрирует большой потенциал в области непрерывного обучения, а его эффективное использование ресурсов и значительное улучшение производительности открывают новое направление для разработки будущих языковых моделей. Однако технология все еще нуждается в постоянном совершенствовании, чтобы преодолеть существующие ограничения и достичь истинных целей непрерывного обучения.