Codestral 25.01, последняя модель кодирования с открытым исходным кодом, выпущенная Mistral, достигла значительного улучшения производительности и работает в два раза быстрее, чем предыдущее поколение. Являясь обновленной версией Codestral, Codestral 25.01 унаследовал характеристики работы с малой задержкой и высокой частотой и оптимизирован для приложений корпоративного уровня, поддерживая такие задачи, как коррекция кода, генерация тестов и промежуточное заполнение. Его отличные результаты в тесте кодирования Python, особенно высокий балл 86,6% в тесте HumanEval, делают его лидером среди современных моделей кодирования с тяжелым весом, превосходя многие аналогичные продукты.

Подобно оригинальному Codestral, Codestral 25.01 по-прежнему фокусируется на операциях с малой задержкой и высокой частотой, поддерживая коррекцию кода, генерацию тестов и промежуточные задачи заполнения. Мистраль заявил, что эта версия особенно подходит для предприятий, которым требуется больше данных и резидентность модели. Тесты производительности показывают, что Codestral25.01 превосходит все ожидания в тесте кодирования Python: результат теста HumanEval составляет 86,6 %, что намного превосходит предыдущую версию Codellama70B Instruct и DeepSeek Coder33B Instruct.

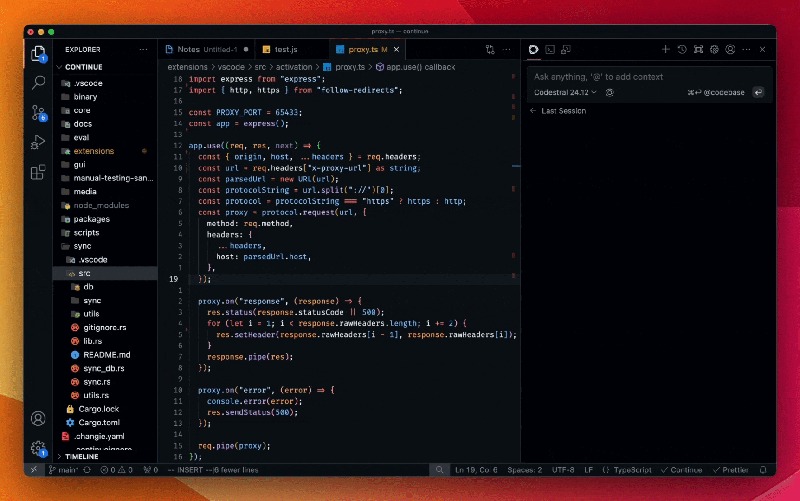

Разработчики могут получить доступ к модели через плагин Mistral IDE, а также инструмент локального развертывания. Продолжить. Кроме того, Mistral также предоставляет доступ к API через Google Vertex AI и Mistral la Plateforme. Модель в настоящее время доступна в предварительной версии на Azure AI Foundry и вскоре будет доступна на платформе Amazon Bedrock.

С момента своего выпуска в прошлом году Codestral от Mistral стал лидером в модели с открытым исходным кодом, ориентированной на код. Его первая версия Codestral представляет собой модель с 22 битами параметров, которая поддерживает до 80 языков и имеет лучшую производительность кодирования, чем многие аналогичные продукты. Сразу после этого Mistral запустила Codestral-Mamba, модель генерации кода, основанную на архитектуре Mamba, которая может обрабатывать более длинные строки кода и справляться с большим количеством входных требований.

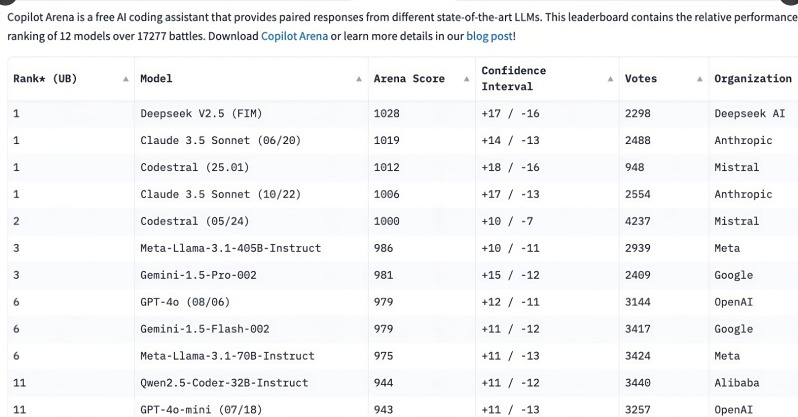

Запуск Codestral 25.01 привлек широкое внимание разработчиков, заняв первое место в рейтинге Co Pilot Arena всего за несколько часов после выпуска. Эта тенденция показывает, что специализированные модели кодирования быстро становятся первым выбором для разработчиков, особенно в области задач кодирования. По сравнению с многофункциональными общими моделями потребность в целенаправленных моделях кодирования становится все более очевидной.

Хотя модели общего назначения, такие как o3 от OpenAI и Claude от Anthropic, также могут кодировать, специально оптимизированные модели кодирования, как правило, работают лучше. В прошлом году несколько компаний выпустили специальные модели для кодирования, такие как Qwen2.5-Coder от Alibaba и китайский DeepSeek Coder, причем последний стал первой моделью, превзошедшей GPT-4Turbo. Кроме того, Microsoft также запустила GRIN-MoE на основе модели смеси экспертов (MOE), которая может не только кодировать, но и решать математические задачи.

Хотя разработчики все еще спорят о том, выбирать ли модели общего назначения или специализированные модели, быстрый рост моделей кодирования выявил огромную потребность в эффективных и точных инструментах кодирования. Благодаря тому, что Codestral25.01 был специально обучен задачам кодирования, он, несомненно, займет место в будущем кодирования.

Выпуск Codestral25.01 знаменует собой еще один шаг вперед в области профессиональных моделей кодирования. Его превосходная производительность и удобный доступ обеспечат разработчикам более эффективный опыт кодирования и будут способствовать дальнейшему развитию искусственного интеллекта в области разработки программного обеспечения. Мы надеемся, что в будущем появится больше подобных профессиональных моделей, которые предоставят разработчикам больше выбора.