Sakana AI запускает инновационный трансформатор модели адаптивной языка, который использует уникальный двухэтапный механизм динамической корректировки веса, который динамически учится и адаптируется к новым задачам в процессе вывода без дорогостоящей точной настройки. Это знаменует собой большой прорыв в технологии модели крупной языковой модели (LLM) и, как ожидается, изменит способ применения LLM, чтобы сделать ее более эффективным, персонализированным и практичным. По сравнению с традиционными методами тонкой настройки, трансформатор Mextively корректирует ключевые компоненты весов модели с помощью методов отдельного разложения значений (SVD) и отдельных значений точной настройки (SVF) для оптимизации производительности в режиме реального времени, избегая трудоемкого переподготовки. Результаты теста показывают, что Transformer² превосходит модель LORA в нескольких задачах, с меньшим количеством параметров, а также демонстрирует сильные возможности передачи знаний.

Основное инновация трансформатора заключается в его уникальном двухэтапном механизме динамической корректировки веса. Во -первых, он анализирует входящие пользователи запросы и понимает требования задач; Избирательно регулируя ключевые компоненты веса модели, Transformer² обеспечивает оптимизацию производительности в реальном времени без трудоемкого переподготовки. Это резко контрастирует с традиционным методом тонкой настройки, который требует сохранения статических параметров после обучения или использования таких методов, как адаптация с низким уровнем ранга (LORA) для изменения лишь небольшого количества параметров.

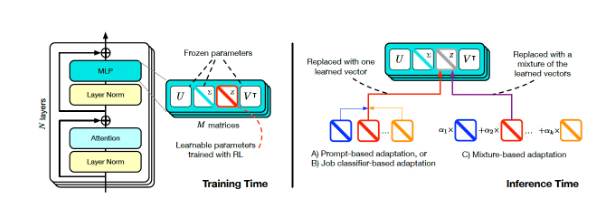

Обучение и вывод Transformer Square (источник: arxiv)

Для достижения динамической корректировки исследователи приняли метод тонкой настройки в единственном значении (SVF). Во время обучения SVF изучает набор представлений о навыках, называемых z-векторами из компонентов SVD модели. При расчете Transformer² определяет необходимые навыки, анализируя подсказки, а затем настройку соответствующих Z-векторов для достижения ответа, адаптированного к каждой подсказке.

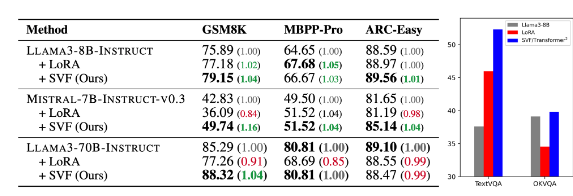

Результаты теста показывают, что Transformer² превосходит модель LORA в различных задачах, таких как математика, кодирование, рассуждения, визуальный вопрос и ответ, и имеет меньше параметров. Более замечательным является то, что модель также обладает возможностью передачи знаний, то есть z-векторы, изученные из одной модели, могут быть применены к другой, что демонстрирует потенциал для широко распространенного применения.

Сравнение трансформатора-квадрата (SVF в таблице) с базовой моделью и Lora (источник: arxiv)

Sakana AI выпустила код обучения для компонента Transformer² на своей странице GitHub, открывая дверь для других исследователей и разработчиков.

Поскольку предприятия продолжают изучать применение LLM, технология настройки вывода постепенно становится основной тенденцией. Transformer², наряду с другими технологиями, такими как Titans Google, меняет способ использования LLM, что позволяет пользователям динамически настраивать модели к своим конкретным потребностям без переподготовки. Этот технологический прогресс сделает LLM более полезным и практичным в более широком диапазоне областей.

Исследователи в Sakana AI заявили, что Transformer² представляет собой мост между статическим искусственным интеллектом и жизненным интеллектом, закладывая основу для эффективных, персонализированных и полностью интегрированных инструментов ИИ.

Выпуск Transformer² с открытым исходным кодом будет значительно способствовать разработке и применению технологий LLM и обеспечит новое направление для создания более эффективных и персонализированных систем искусственного интеллекта. Его способность динамически учиться и адаптироваться к новым задачам делает его огромным потенциалом применения в различных областях и стоит с нетерпением ждать будущего развития.