Алленский институт искусственного интеллекта (AI2) недавно выпустил новую крупномасштабную языковую модель Olmoe, редкую гибридную модель эксперта (MOE) с 7 миллиардами параметров, но в каждой входной марке используется только 1 миллиард параметров, что значительно уменьшает количество выводов затраты и требования к памяти. OLMOE имеет две версии: универсальная версия OLMOE-1B-7B и инструкция с тонкой настройкой OLMOE-1B-7B-Instruct, которая работает не меньше, чем другие крупные модели в контрольных показателях, и даже превосходит некоторые более крупные модели. AI2 подчеркивает полный открытый источник OLMOE, который особенно ценен в области моделей MOE и предоставляет ценные ресурсы для академических исследований.

Olmoe принимает редкую архитектуру гибридного эксперта (MOE) с 7 миллиардами параметров, но только 1 миллиард параметров используется для входной метки. Он поставляется в двух версиях: более общий olmoe-1b-7b и настройка Olmoe-1B-7b-7b-2B.

В отличие от большинства других гибридных экспертных моделей, которые являются закрытым исходным кодом, AI2 подчеркивает, что OLMOE полностью открыт. В статье они упомянули, что «большинство моделей MOE являются закрытым исходным кодом: хотя некоторые раскрывают веса модели, существует чрезвычайно ограниченная информация о их обучающих данных, коде или рецептах».

Исследователь AI2 Натан Ламберт сказал в социальных сетях, что OLMOE поможет с разработкой политики, что может обеспечить отправную точку для запуска кластера H100 в академических кругах. Он также упомянул, что выпуск модели OLMOE является частью цели AI2 по разработке моделей с открытым исходным кодом и сопоставимой ее производительности с замкнутыми моделями.

С точки зрения построения моделей, AI2 решил использовать 64 небольших экспертов для тонкого маршрутизации и активировать только восемь из них во время выполнения. Эксперименты показывают, что OLMOE сравнимо с другими моделями в производительности, но значительно снижается по стоимости вывода и хранения памяти. Olmoe также опирается на модель с открытым исходным кодом OLMO1.7-7B перед AI2, поддерживая 4096 Tagged Context Windes. Данные по обучению OLMOE поступают из нескольких источников, в том числе Common Crawl, Dolma CC, Wikipedia и т. Д.

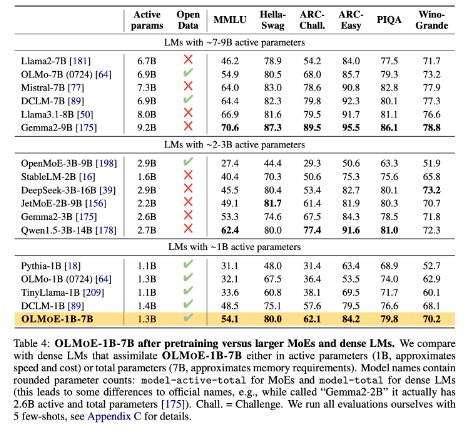

В эталоне OLMOE-1B-7B превосходят многие существующие модели по сравнению с моделями с аналогичными параметрами и даже превосходят более крупные модели, такие как Llama2-13B-Chat и DeepSeekmoe-16B.

Одной из целей AI2 является предоставление исследователям более полно с открытым исходным исходным искусством, включая гибридные экспертные архитектуры. Хотя многие разработчики используют архитектуру MOE, AI2 считает, что большинство других моделей искусственного интеллекта далеки от открытия.

HuggingFace: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

Вход бумаги: https://arxiv.org/abs/2409.02060

Ключевые моменты:

- Новая модель с открытым исходным кодом Olmoe, выпущенная AI2, конкурентоспособна с точки зрения производительности и стоимости.

- Olmoe принимает редкую гибридную экспертную архитектуру, которая может эффективно снизить затраты на вывод и требования к памяти.

- AI2 стремится предоставить полностью с открытым исходным ИИ модель, которая способствует академическим исследованиям и разработкам.

Короче говоря, выпуск OLMOE с открытым исходным кодом является основным прогрессом в области крупномасштабных языковых моделей. Движение AI2 отражает его твердую приверженность развитию ИИ с открытым исходным кодом и стоит ожидать более похожих вкладов в будущем.