В последние годы стоимость обучения крупных языковых моделей оставалась высокой, что стало важным фактором, ограничивающим развитие ИИ. Как снизить затраты на обучение и повысить эффективность стало центром внимания отрасли. Исследователи из Гарварда и Стэнфордского университета приняли другой подход и начали с точной точности обучения модели, чтобы исследовать экономический метод обучения. Они обнаружили, что, снижая точность модели, объем вычислений может быть эффективно снижен и даже повышенной производительность модели в некоторых случаях. Это исследование предоставляет новые идеи для оптимизации обучения языковой модели, а также указывают направление для будущей разработки ИИ.

В области искусственного интеллекта, тем больше масштаб, тем сильнее способность. Чтобы продолжить более мощную языковую модель, крупные технологические компании безумно укладывают параметры модели и данные обучения, но они обнаруживают, что стоимость также возросла. Разве нет экономически эффективного и эффективного способа обучения языковых моделей?

Исследователи из Гарварда и Стэнфордского университета недавно опубликовали статью, в которой они обнаружили, что точность обучения модели похожа на скрытый ключ, который разблокирует «пароль затрат» языковой подготовки.

Что такое точность модели? Традиционные модели глубокого обучения обычно обучаются с использованием 32-разрядных номеров с плавающей запятой (FP32), но в последние годы, с разработкой аппаратного обеспечения, используйте более низкие численные типы, такие как 16-битные номера плавания (FP16) или 8-битный Обучение целых числам (Int8) стало возможным.

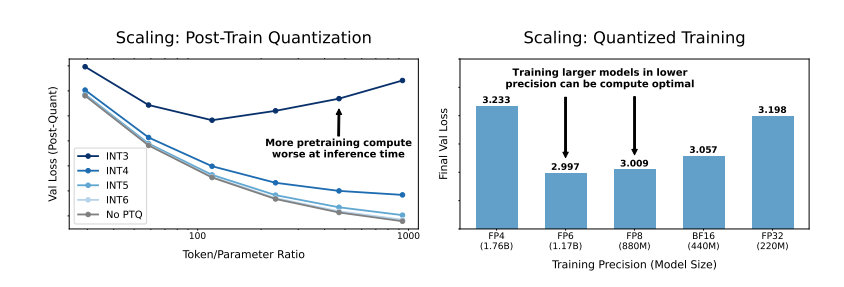

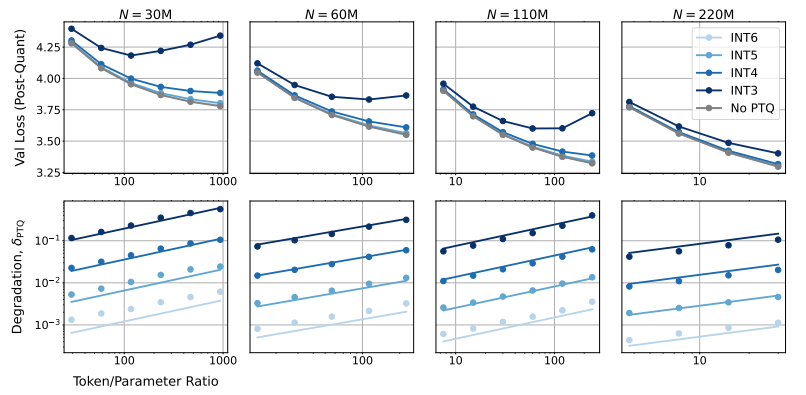

Итак, какое влияние снизит точность модели на производительность модели? Благодаря большому количеству экспериментов исследователи проанализировали изменения затрат и эффективности обучения и вывода модели при различной точности и предложили новый набор правил масштабирования «точного восприятия».

Они обнаружили, что обучение с более низкой точностью может эффективно снизить «количество эффективных параметров» модели, тем самым уменьшая объем вычислений, необходимых для обучения. Это означает, что при одном и том же вычислительном бюджете мы можем обучать более крупные модели или в том же масштабе, использование более низкой точности может сэкономить много вычислительных ресурсов.

Еще более удивительно, что исследователи также обнаружили, что в некоторых случаях обучение с более низкой точностью может на самом деле улучшить производительность модели! Фаза, модель будет более устойчивой к снижению точности квантования, тем самым демонстрируя лучшую производительность на этапе вывода.

Итак, какую точность мы должны выбрать для обучения модели?

Традиционная 16-битная точная тренировка может быть не лучшим выбором. Их исследования показывают, что 7-8-битная точность может быть более экономически эффективным вариантом.

Это не мудрый шаг, чтобы пройти ультра-низкую точность (например, 4-битный) обучение. Поскольку при чрезвычайно низкой точности количество эффективных параметров модели резко упадет, чтобы поддерживать производительность, нам необходимо значительно увеличить размер модели, что приведет к более высоким затратам на вычисление.

Оптимальная точность обучения может варьироваться для моделей разных размеров. Для моделей, которые требуют большого количества «перегрузки», таких как серия Llama-3 и GEMMA-2, обучение с более высокой точностью может быть более рентабельным.

Это исследование дает нам совершенно новую перспективу, чтобы понять и оптимизировать обучение языковой модели. Это говорит нам о том, что выбор точности не является статичным, но должен быть обменен вниз, основываясь на конкретном размере модели, объеме данных и сценариях применения.

Конечно, это исследование также имеет некоторые ограничения. Например, модель, которую они используют, относительно мала по размеру, и экспериментальные результаты могут не быть непосредственно обобщенными для более крупных моделей. Кроме того, они сосредоточились только на функции потерь модели и не оценивали производительность модели на нижестоящих задачах.

Тем не менее, это исследование имеет большое значение. Он выявляет сложную связь между точностью модели и производительностью модели и затратами на обучение, а также дает нам ценную информацию о разработке и обучении более сильных и более экономичных языковых моделей в будущем.

Бумага: https://arxiv.org/pdf/2411.04330

Короче говоря, это исследование предоставляет новые идеи и методы для снижения затрат на обучение крупных языковых моделей и обеспечивает важную справочную ценность для будущего развития области искусственного интеллекта. Хотя в исследовании существуют некоторые ограничения, правило масштабирования «точности», которое оно предлагает, и углубленное обсуждение взаимосвязи между точностью модели и стоимостью и эффективностью имеют важное теоретическое и практическое руководящее значение.