Исследовательские группы Meta Fair, UC Berkeley и New York University Commands сотрудничали в разработке новой технологии, называемой оптимизацией предпочтений мышления (TPO), чтобы значительно улучшить соответствие инструкциям и качество ответа в моделях крупных языков (LLM). В отличие от традиционных LLM, которые дают ответы напрямую, технология TPO позволяет моделям думать и отражать внутреннюю часть перед ответом, тем самым генерируя более точные и последовательные ответы. Это инновация направляет модель для оптимизации своего мышления, не показывая пользователю промежуточные шаги, в конечном итоге улучшая качество ответов с помощью улучшенного метода рассуждения цепного мышления (COT).

Ядром технологии TPO является улучшенный метод рассуждения цепного мышления (COT). Этот подход побуждает модели «мыслить и отвечать» во время обучения, помогая им создать более организованный процесс внутреннего мышления, прежде чем предоставить окончательный ответ. Традиционные подсказки кроватки могут иногда привести к снижению точности и довольно сложно тренироваться из -за отсутствия четких шагов мышления. И TPO успешно преодолевает эти проблемы, позволяя моделям оптимизировать и упростить свой процесс мышления, не подвергая промежуточных шагов пользователям.

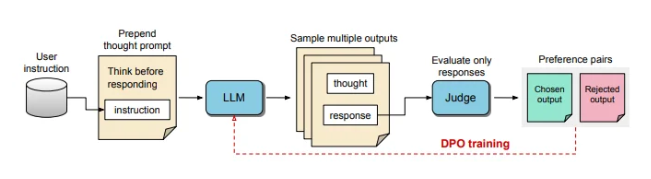

Во время процесса обучения TPO сначала подскажите большую языковую модель, чтобы генерировать несколько идей, а затем разобрать окончательный ответ. Эти выходы затем оцениваются моделью «Джаджер», чтобы выбрать лучшие и худшие ответы. Эти результаты оценки используются в качестве «выбора» и «отклонить» пары для прямой оптимизации предпочтений (DPO) для постоянного улучшения качества отклика модели.

Регулируя подсказки для обучения, TPO поощряет модель мыслить внутренне, прежде чем отвечать. Этот процесс направляет модель, чтобы оптимизировать свои ответы, чтобы сделать ее более ясной и актуальной. В конечном счете, оценка проводится с помощью модели суждения на основе LLM, которая оценивает только окончательный ответ, тем самым помогая модели улучшить качество ответов независимо от скрытых шагов мышления. TPO также использует прямую оптимизацию предпочтений, чтобы создать предпочтительные ответы, которые содержат скрытое мышление, и после нескольких раундов обучения еще больше уточнить внутренний процесс модели.

В критериях Alpacaeval и Arena-Hard метод TPO превзошел базовую линию традиционного ответа и был лучше, чем модель Llama-3-8b-instruct «Советы по мышлению». Итеративное обучение этого метода оптимизирует возможности генерации мышления, в конечном итоге превосходя несколько базовых моделей. Стоит отметить, что TPO подходит не только для логики и математических задач, но и прилагает большие усилия в творческих областях, таких как маркетинговые и инструкции по здоровью, чтобы следовать задачам.

ИИ и эксперт по робототехнике Каран Верма поделился своими взглядами на концепцию «Мышления LLM» на социальной платформе X, заявив, что он был очень взволнован этим и с нетерпением ждал потенциала этого инноваций в медицинских приложениях, которые могут привести к большему количеству пациентов Полем

Этот структурированный процесс внутреннего мышления позволяет модели более эффективно обрабатывать сложные инструкции, еще больше расширяя его применение в областях, которые требуют многоуровневых рассуждений и тщательного понимания без необходимости для людей для предоставления конкретных данных мышления. Это исследование показывает, что TPO может сделать большие языковые модели более гибкими и эффективными в различных контекстах, подходящих для областей, где существуют высокие требования для гибкости и глубины генерации ответов.

Прорывные достижения в области технологий TPO привели к более сильным выводам и пониманиям для крупных языковых моделей, открывая новые возможности для их применения в различных областях, особенно в задачах, которые требуют сложных процессов мышления.