Meta AI, совместно с исследователями из Калифорнийского университета, Беркли и Нью -Йоркского университета, разработал новый подход под названием «Оптимизация предпочтений мышления» (TPO), который направлен на значительное улучшение качества реакции крупных языковых моделей (LLM). В отличие от традиционных методов, которые фокусируются только на окончательном ответе, TPO позволяет модели мыслить внутренне, прежде чем генерировать ответ, что приводит к более точному и когерентному отклику. Этот метод рассуждений с улучшением технологий (COT) преодолевает недостатки низкой точности и сложности метода предыдущей COT в обучении посредством оптимизации и оптимизации процесса внутреннего мышления модели, и в конечном итоге генерирует более высокие ответы и во многих отношениях Каждый тест.

В отличие от традиционных моделей, которые фокусируются только на окончательном ответе, метод TPO позволяет модели мыслить внутренне перед созданием ответа, что приводит к более точным и когерентным ответам.

Эта новая технология сочетает в себе улучшенный метод рассуждения цепей (COT). Во время учебного процесса этот метод побуждает модель «мыслить» перед реагированием, помогая ему создать более систематический процесс внутреннего мышления. Предыдущие прямые подсказки кроватки иногда снижают точность, и процесс обучения затруднен из -за отсутствия четких шагов мышления. TPO преодолевает эти ограничения, позволяя модели оптимизировать и оптимизировать свой процесс мышления и не показывает промежуточных шагов мышления перед пользователем.

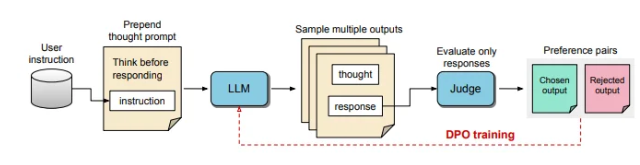

В процессе TPO моделям крупным языкам сначала предлагается генерировать несколько мыслительных процессов, а затем эти выходы отображаются и оцениваются перед формированием окончательного ответа. Затем модель оценки будет оценить вывод, чтобы определить оптимальные и худшие ответы. Используя эти выходы в качестве выбора и отклонения для оптимизации прямой предпочтения (DPO), этот итеративный метод обучения повышает способность модели генерировать более актуальные, высококачественные ответы, тем самым улучшая общие результаты.

В этом методе корректируются подсказки для обучения, поощряя модель думать внутри, прежде чем отвечать. Оцененный окончательный ответ оценивается по модели оценки на основе LLM, которая позволяет модели улучшать качество, основанное исключительно на эффективности ответа, без учета неявных шагов мышления. Кроме того, TPO использует прямую оптимизацию предпочтений для создания ответов на предпочтения и отклонения, которые содержат неявное мышление, и дополнительно уточняет внутренний процесс модели с помощью нескольких учебных циклов.

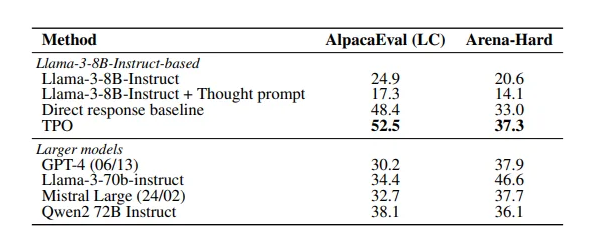

Результаты исследования показывают, что метод TPO хорошо выполнялся в нескольких критериях, превосходящих различные существующие модели. Этот подход не только относится к логическим и математическим задачам, но и демонстрирует потенциал в творческих областях, таких как маркетинговые и управляющие задачами здравоохранения.

Бумага: https://arxiv.org/pdf/2410.10630

Ключевые моменты:

Технология TPO улучшает способность мышления крупных языковых моделей перед созданием ответов, гарантируя, что ответы более точными.

Благодаря улучшению мышления мышления цепочки мышления модель может оптимизировать и оптимизировать свой внутренний процесс мышления и улучшать качество ответа.

TPO подходит для различных областей не только для логических и математических задач, но и для творческого и здоровья.

Короче говоря, метод TPO предоставляет новую идею для улучшения производительности крупных языковых моделей. Бумажные ссылки удобны для читателей, чтобы получить представление о своих технических деталях и экспериментальных результатах.