Последние процессоры серии AMD AMD APU показывают значительные преимущества в приложениях модели AI Big Language Model (LLM) и превосходят серию Intel Lunar Lake. Предназначенная для мобильных платформ, серия процессоров предназначена для обеспечения более высокой производительности и более низкой задержки для удовлетворения растущего спроса на рабочие нагрузки искусственного интеллекта. AMD подчеркивает выдающуюся производительность процессоров Ryzen AI при обработке задач LLM и запускает инструменты LM Studio для упрощения использования крупных языковых моделей и более низких порогов пользователей.

Недавно AMD выпустила свою последнюю серию Strix Point Apu, подчеркивая выдающуюся производительность этой серии в приложениях AI Big Language Model (LLM), что намного превышает процессоры серии Lunar Lake's Intel. С ростом спроса на рабочие нагрузки искусственного интеллекта конкуренция за оборудование становится все более жесткой. Чтобы справиться с рынком, AMD запустила процессоры искусственного интеллекта, разработанные для мобильных платформ, предназначенных для более высокой производительности и более низкой задержки.

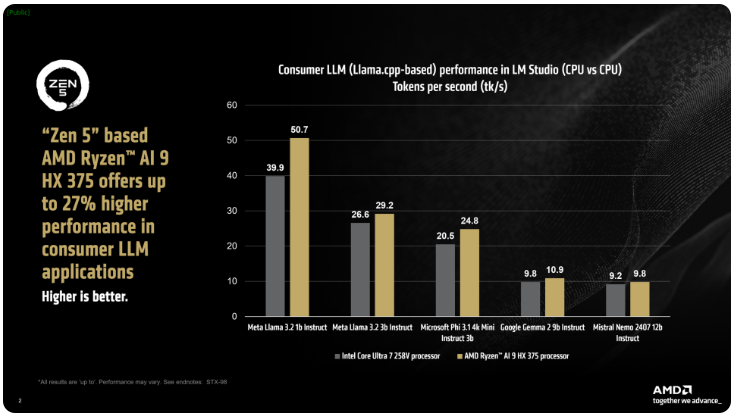

AMD сказал, что процессоры Ryzen AI300 серии IX Point могут значительно увеличить количество токенов, обрабатываемых в секунду при обработке задач AI LLM, а Ryzen AI9375 имеет 27% улучшение производительности по сравнению с Core Ultra258V Intel. В то время как Core Ultra7V не является самой быстрой моделью в семействе L Lake, его ядро и количество нитей близко к более высоким процессорам Lunar Lake, демонстрируя конкурентоспособность продуктов AMD в этой области.

Инструмент AMD LM Studio-это приложение, ориентированное на потребителя, основанное на рамках Llama.cpp, предназначенной для упрощения использования моделей крупных языков. Эта структура оптимизирует производительность x86CPU, и, хотя она не требует GPU для запуска LLM, использование графических процессоров может еще больше ускорить скорость обработки. Согласно тестам, Ryzen AI9HX375 может достичь в 35 раза меньше задержки в модели Meta Llama3.21b, а токены 50,7 в секунду.

Мало того, APU Strix Point также оснащен мощной интегрированной графической картой Radeon, основанной на RDNA3.5, которая разгружает задачи в IGPU через API Ulkan, что еще больше улучшает производительность LLM. Используя технологию «Изменения графической памяти» (VGM), процессор Ryzen AI300 может оптимизировать распределение памяти, повысить энергоэффективность и в конечном итоге достичь повышения производительности до 60%.

В сравнительных тестах AMD использовал те же настройки на платформе Intel AI Playground и обнаружил, что Ryzen AI9HX375 был на 87% быстрее на Microsoft PHI3.1, чем основная модель Ultra7258V и на 13% быстрее в модели MISTRAL7B. Тем не менее, результаты будут еще более интересными по сравнению с флагманским ядром Ultra9288V в диапазоне Лунного озера. В настоящее время AMD сосредоточен на том, чтобы сделать использование больших языковых моделей более популярными через LM Studio, стремясь сделать более нетехническим пользователям начать работу.

Ключевые моменты:

AMD Strix Point APUS повышает производительность на 27% по сравнению с Intel Lunar Lake в приложениях AI LLM.

Ryzen AI9HX375 выполняет в 3,5 раза меньше задержки в модели Meta Llama3.2.

Инструмент LM Studio предназначен для облегчения использования моделей крупных языков и подходящих для нетехнических пользователей.

Короче говоря, сильная производительность серии AMD Strix Point APU в области приложений AI LLM и простых в использовании инструментов Studio Studio указывают на активную компоновку и конкурентоспособность AMD на рынке аппаратных обеспечений ИИ, что принесло потребителям более удобные и эффективный опыт ИИ.