Rakuten Group выпустила свою первую японскую модель большого языка (LLM) Rakuten AI2.0 и малой языковой модели (SLM) Rakuten AI2.0Mini, стремясь содействовать развитию искусственного интеллекта в Японии. Rakuten AI2.0 принимает архитектуру гибридного эксперта (MOE) и имеет восемь экспертных моделей с 7 миллиардами параметров. Rakuten AI2.0Mini-это компактная модель с 1,5 миллиардами параметров, предназначенных для развертывания устройств Edge, с учетом экономической эффективности и легкостью применения. Обе модели являются открытым исходным кодом и обеспечивают точную настройку и оптимизированные предпочтения версии для поддержки различных задач генерации текста.

Rakuten Group объявила о запуске своей первой японской модели на большом языке (LLM) и модели Small Language (SLM), названной Rakuten AI2.0 и Rakuten AI2.0 Mini.

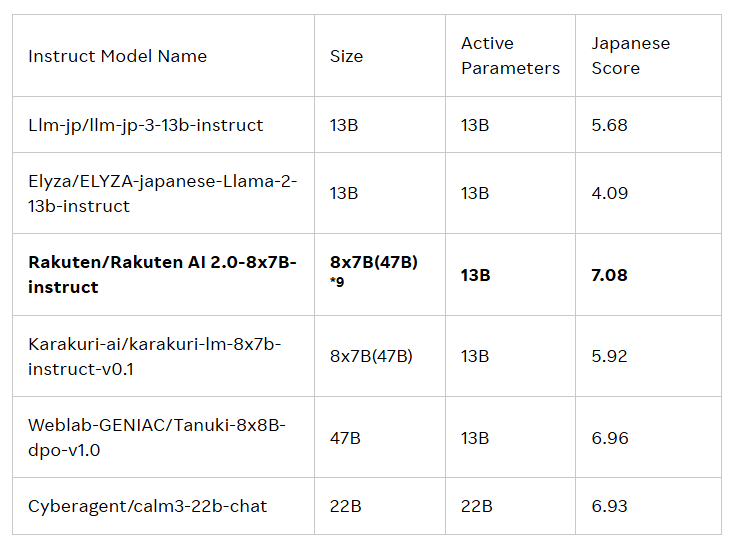

Выпуск этих двух моделей предназначен для развития развития искусственного интеллекта (ИИ) в Японии. Rakuten AI2.0 основан на архитектуре Hybrid Expert (MOE) и представляет собой модель 8x7b, состоящую из восьми моделей с 7 миллиардами параметров, каждый из которых служит экспертом. Всякий раз, когда обрабатывается входной токен, система отправит его двум наиболее соответствующим экспертам, и маршрутизатор отвечает за его выбор. Эти эксперты и маршрутизаторы постоянно тренируются вместе с большим количеством высококачественных двуязычных данных японских и английских.

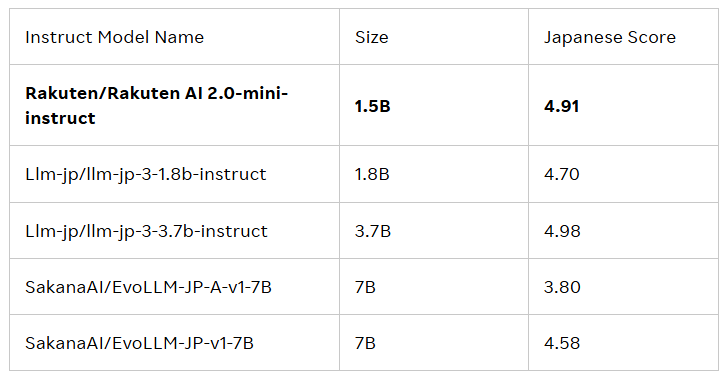

Rakuten AI2.0Mini-это новая плотная модель с объемом параметров 1,5 миллиарда, предназначенная для экономически эффективного развертывания устройств с преимуществом Edge и подходящего для конкретных сценариев применения. Он также обучается смешанным данным в Японии и Великобритании с целью предоставления удобного решения. Обе модели были точно настроены и предпочтительны, и выпустили основные модели и модели инструкций для поддержки предприятий и специалистов в разработке приложений искусственного интеллекта.

Все модели находятся в соответствии с лицензионным соглашением Apache2.0, которое пользователи могут получить в официальной библиотеке обнимающего лица Rakuten Group. Кроме того, эти модели также могут служить основой для других моделей, которые способствуют дальнейшей разработке и применению.

Cai Ting, главный ИИ и сотрудник данных в Rakuten Group, сказал: «Я очень горжусь тем, как наша команда объединяет данные, инженерию и науку для запуска Rakuten AI2.0. Предприятия принимают интеллектуальные решения, ускоряют реализацию стоимости и открывают новые возможности. . "

Официальный блог: https://global.rakuten.com/corp/news/press/2025/0212_02.html

Ключевые моменты:

Rakuten Group запускает свою первую японскую модель большого языка (LLM) и малый языковой модель (SLM) под названием Rakuten AI2.0 и Rakuten AI2.0 Mini.

Rakuten AI2.0 основан на гибридной экспертной архитектуре и имеет восемь экспертных моделей с 7 миллиардами параметров, приверженных эффективной обработке японских и английских двуязычных данных.

Все модели доступны в официальной библиотеке Rakuten, которые обнимаются, подходят для различных задач генерации текста и служат основой для других моделей.

Короче говоря, запуск Rakuten AI2.0 и Rakuten AI2.0Mini отмечают еще один важный прогресс в Японии в области крупных языковых моделей. к его будущему применению и воздействию.