В последние годы, благодаря быстрому разработке моделей крупных языков, модели улучшения выводов также вызвали обширные дискуссии об их показателях галлюцинации, одновременно улучшая возможности обработки сложных задач. Команда машинного обучения Vectara недавно провела углубленное исследование моделей серии Deepseek, выявив значительные различия в модели, способствующей выводу с точки зрения уровня галлюцинации.

Недавно команда машинного обучения Vectara провела глубокие галлюцинационные тесты на двух моделях серии DeepSeek серии V3. Это говорит о том, что DeepSeek-R1 производит более неточный или не согласованный с исходной информацией в процессе увеличения рассуждений. Этот результат запускает широкое обсуждение уровня галлюцинации большой языковой модели с выводом (LLM).

Примечания источника изображения: изображение генерируется ИИ, а изображение авторизованное поставщик услуг Midjourney

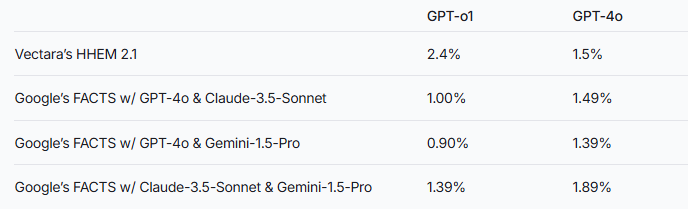

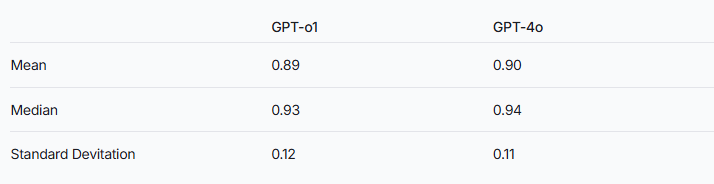

Исследовательская группа отметила, что модели увеличения вывода могут быть более подвержены галлюцинациям, чем обычные крупные языковые модели. Это явление особенно очевидно в сравнении серии DeepSeek с другими моделями улучшения вывода. Принимая серию GPT в качестве примера, разница в частоте галлюцинации между GPT-O1 с усилением рассуждений и нормальной версией GPT-4O также проверяет это предположение.

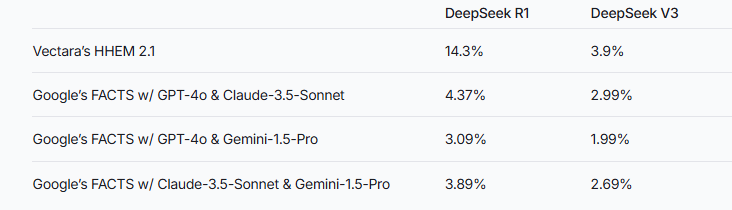

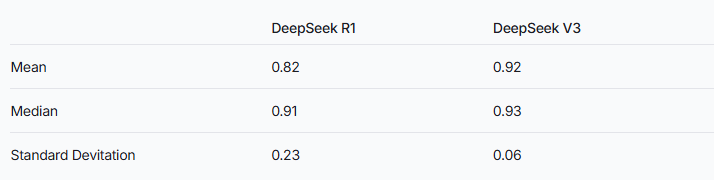

Чтобы оценить производительность этих двух моделей, исследователи использовали модель Vectara HHEM и метод фактов Google для вынесения суждений. В качестве специализированного инструмента обнаружения галлюцинации HHEM демонстрирует более высокую чувствительность при захвате увеличения частоты галлюцинации DeepSeek-R1, в то время как модель фактов работает относительно плохо в этом отношении. Это напоминает нам, что HHEM может быть более эффективным, чем LLM в качестве стандарта.

Стоит отметить, что DeepSeek-R1, несмотря на превосходные результаты в рассуждениях, сопровождается более высоким уровнем галлюцинации. Это может быть связано с сложной логикой, необходимой для обработки моделей улучшения вывода. По мере увеличения сложности рассуждений модели на точность генерируемого контента может быть затронута вместо этого. Исследовательская группа также подчеркнула, что если DeepSeek может больше сосредоточиться на сокращении галлюцинаций на этапе обучения, может быть возможно достичь хорошего баланса между способностями рассуждения и точностью.

В то время как модели с выводом, как правило, демонстрируют более высокие галлюцинации, это не означает, что они не имеют преимущества в других отношениях. Для серии DeepSeek все еще необходимо решить галлюцинации в последующих исследованиях и оптимизации, чтобы улучшить общую производительность модели.

Ссылка: https://www.vectara.com/blog/deepseek-r1-hallucinates-more-tan-deepseek-v3

Благодаря непрерывной эволюции моделей крупных языков, как снизить показатели галлюцинации при одновременном улучшении возможностей рассуждений станет важным направлением для будущих исследований. Результаты испытаний серии DeepSeek дают нам ценную ссылку на то, чтобы продвигать отрасль для дальнейшей оптимизации производительности модели.