Благодаря быстрому развитию технологий искусственного интеллекта языковые модели становятся все более и более широко используемыми в нескольких областях. Тем не менее, новое исследование OpenAI показало, что эти модели далеко не ожидали, когда отвечают на фактические вопросы, что вызвало переосмысление способности ИИ приобретать знания.

Недавнее исследование, проведенное Openai, показывает, что, несмотря на быстрое развитие технологий искусственного интеллекта, нынешние наиболее продвинутые языковые модели имеют гораздо более низкие показатели успеха при ответе на фактические вопросы.

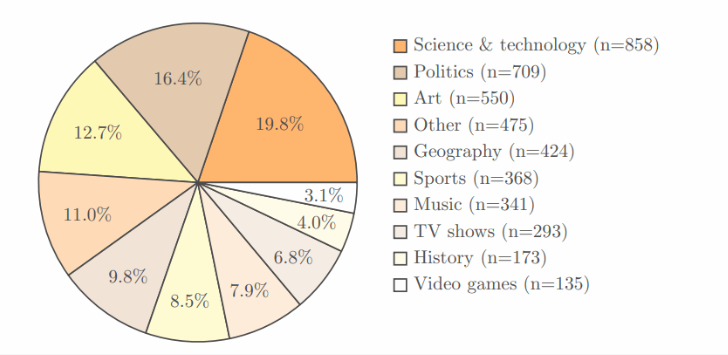

В исследовании принял собственный тест Simpleqa Simpleqa, который содержит 4326 областей, охватывающих несколько областей, таких как наука, политика и искусство, и каждый вопрос имеет четкий и правильный ответ.

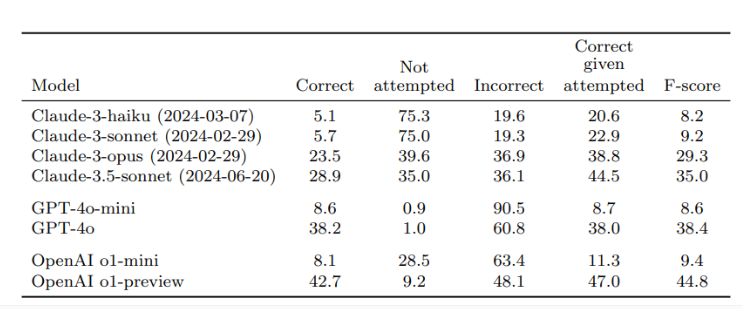

После проверки двумя независимыми рецензентами результаты показали, что скорость точность O1-просмотра, лучшая модель OpenAI, составляла всего 42,7%, в то время как GPT-4O был немного ниже, всего 38,2%. Что касается меньшего GPT-4O-Mini, то высокая точность составляет даже 8,6%. Напротив, модель Claude's Claude от Antropic выступила хуже, с точностью точности Claude-3,5-Sonnet всего 28,9%.

Ключом к этому исследованию является дизайн теста не только для проверки производительности ИИ, но и для того, чтобы все осознали ограничения моделей ИИ с точки зрения приобретения знаний. Исследователи подчеркивают, что при использовании этих моделей пользователи должны рассматривать их как инструменты обработки информации, а не полагаться на источники знаний. Чтобы получить более точные ответы, лучше всего предоставить надежные данные для ИИ, а не полагаться исключительно на его встроенные знания.

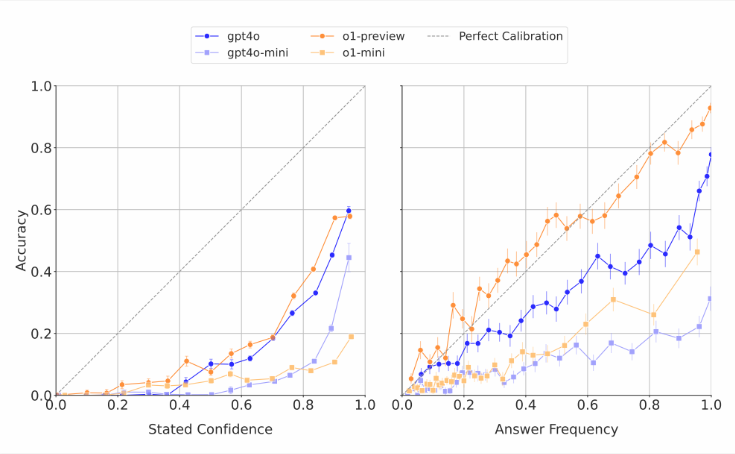

Стоит отметить, что модели ИИ часто оценивают свои собственные способности. Исследователи обнаружили, что когда эти модели попросили забить уверенность в своих ответах, они обычно давали преувеличенную оценку точности. В тестах, которые неоднократно отвечают на один и тот же вопрос, даже если модель дает один и тот же ответ несколько раз, их фактический показатель успеха по-прежнему ниже, чем точность их самооценки. Это согласуется с критикой внешнего мира, которая часто дает абсурдные ответы на языковые модели, но кажется уверенным.

Исследователи считают, что существует четкий разрыв в фактической точности современных систем ИИ и срочно нуждается в улучшении. В то же время они также задавали открытый вопрос: может ли производительность AI в ответе на короткие фактические вопросы предсказать, как он работает при работе с более длинными и более сложными ответами. Чтобы поддержать разработку более надежных языковых моделей, OpenAI публично опубликовал данные Simpleqa Benchmarks на GitHub.

Ключевые моменты:

Исследования OpenAI показывают, что наиболее продвинутые языковые модели имеют низкие показатели успеха при ответе на фактические вопросы, максимальный показатель успеха всего 42,7%.

Эти модели ИИ часто переоценивают их способности, и их оценки доверия, как правило, преувеличены.

OpenAI сделал Simpleqa Benchmark Public, чтобы помочь исследовать более надежные языковые модели.

Это исследование напоминает нам, что, несмотря на значительный прогресс в технологии искусственного интеллекта, его ограничения должны рассматриваться с осторожностью в практическом применении и продолжать способствовать технологическим улучшениям.