นี่คือรายการที่รวบรวมไว้ของเอกสาร "Model-as-a-Service (LMAAS)" ซึ่งเป็นส่วนใหญ่ของ Tianxiang Sun เราขอแนะนำให้นักวิจัย NLP ที่มีความสนใจในหัวข้อนี้เพื่อทำการขอการดึงเพื่อเพิ่มหรืออัปเดตเอกสาร (ดูการสนับสนุน) ดูที่เก็บนี้สำหรับการอัปเดตล่าสุด!

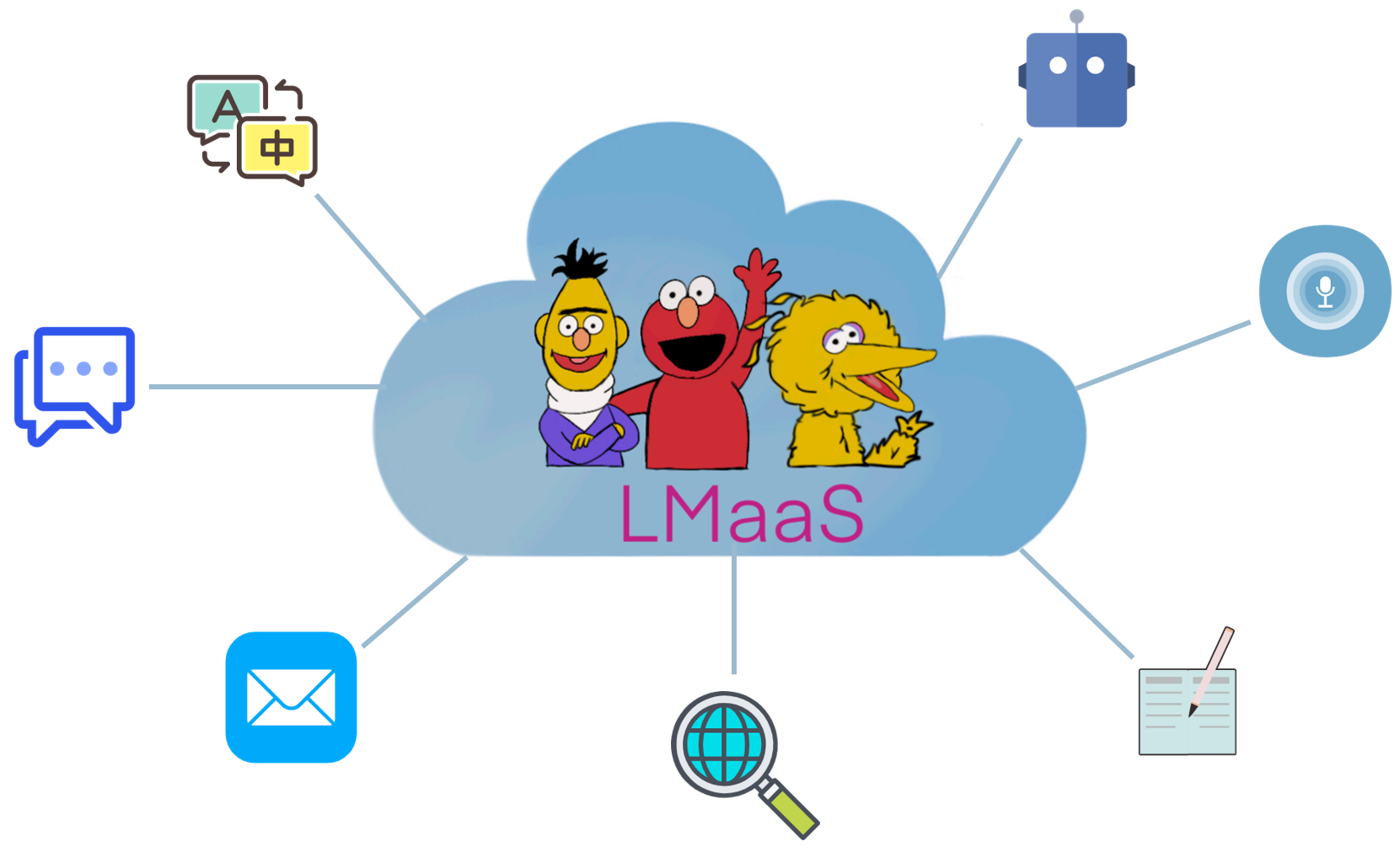

เนื่องจากเหตุผลเชิงพาณิชย์และค่าใช้จ่ายในการปรับราคาที่มีราคาแพงรุ่นภาษาขนาดใหญ่ที่ผ่านการฝึกอบรมมาล่วงหน้า (LLM) เช่น GPT-3 มักจะถูกปล่อยออกมาเป็นบริการแทนน้ำหนักแบบเปิดแบบเปิด เราเรียกสถานการณ์นี้ว่า " Language-Model-As-A-Service (LMAAS) " (คำนี้ใช้เดิมในกระดาษ ICML'2022 ของเรา) ในสถานการณ์เช่นนี้ผู้ใช้สามารถเข้าถึง LLM ที่ทรงพลังผ่าน API การอนุมานของพวกเขา บริการของ LLMS ได้ขับเคลื่อนกรณีการใช้งานจำนวนมาก (ดูการสาธิต GPT-3) ตรงกันข้ามกับการปรับแต่ง LMAAs อนุญาตให้ LLM วัตถุประสงค์ทั่วไปเพียงอย่างเดียวเพื่อให้บริการงานที่แตกต่างมากมายและดังนั้นจึงมีประสิทธิภาพในการปรับใช้อย่างมาก อย่างไรก็ตามวิธีการปรับ LLMs ให้เข้ากับเป้าหมายโดยไม่ต้องเข้าถึงพารามิเตอร์และการไล่ระดับสีเป็นสิ่งที่ท้าทาย เพื่อให้ LLMS เป็นประโยชน์ต่อผู้ชมที่กว้างขึ้นเรารวบรวมเอกสารที่เหมาะสมกับสถานการณ์นี้เพื่ออำนวยความสะดวกในการวิจัยในอนาคต

เอกสารใดที่เหมาะสมกับสถานการณ์ของ LMAAS? เราพิจารณาเอกสารที่ปรับ LLMs ให้เข้ากับงานดาวน์สตรีมโดยไม่ต้องเข้าถึงพารามิเตอร์แบบจำลองและการไล่ระดับสี แม้ว่า LLM ที่ปรับแต่งได้อย่างละเอียดสามารถเป็นบริการหลังจากการปรับใช้ แต่ก็ถูก จำกัด ให้แก้ปัญหางานเดียวสำหรับผู้ชมที่ จำกัด ในขอบเขตของเราเราชอบให้บริการแบบจำลองวัตถุประสงค์ทั่วไปสำหรับผู้ใช้ที่หลากหลาย

ในวรรณคดีที่มีอยู่มีการวิจัยหลายบรรทัดที่เหมาะสมกับ LMAAs:

ขอบเขตระหว่าง พรอมต์ข้อความ และ การเรียนรู้ในบริบท นั้นค่อนข้างเบลอ ใน repo นี้หมวดหมู่ ข้อความพรอมต์ มีเอกสารที่ไม่ได้ใช้ตัวอย่างที่มีป้ายกำกับในขณะที่หมวดหมู่ การเรียนรู้ในบริบท ประกอบด้วยเอกสารที่มีตัวอย่างที่มีป้ายกำกับในพรอมต์

หมายเหตุ: หัวข้อที่เกี่ยวข้อง (และซ้อนทับบางส่วน) คือ การเรียนรู้ที่รวดเร็ว ซึ่งมีวัตถุประสงค์เพื่อแก้ปัญหางานดาวน์สตรีมโดยใช้ LLM วัตถุประสงค์ทั่วไปโดยการแปลงอินพุตและเอาต์พุตด้วยเทมเพลตและ Verbalizer ตามลำดับ อย่างไรก็ตามการทำงานส่วนใหญ่ในการเรียนรู้ตามพรอมต์จำเป็นต้องมีการเข้าถึงพารามิเตอร์และการไล่ระดับสีแบบจำลองดังนั้นจึงไม่เหมาะสมกับขอบเขตของเรา สำหรับเอกสารการเรียนรู้ที่รวดเร็วซึ่งไม่เหมาะสำหรับ LMAAS เราขอแนะนำให้มีส่วนร่วมในรายการกระดาษที่ยอดเยี่ยมอีกรายการ: PromptPaper

เมื่อเปรียบเทียบกับ LLMs เฉพาะงานที่ปรับแต่งได้ LMAAS มีข้อได้เปรียบดังต่อไปนี้:

ตัวย่อของงาน

คุณสมบัติที่สำคัญของงาน

การตั้งค่าการทดลองหลักของงาน

แบบจำลองภาษาเป็นฐานความรู้? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel [PDF] [รหัส]

เราจะรู้ได้อย่างไรว่ารูปแบบภาษาใดรู้ Tacl 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig [PDF] [รหัส]

แบบจำลองภาษาเป็นผู้เรียนไม่กี่คน Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal Ramesh, Daniel M. Ziegler Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, หมากรุกเบนจามิน, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei [PDF]

การปรับรูปแบบภาษาสำหรับการเรียนรู้แบบไม่มีการยิงโดยการปรับแต่งเมตาบนชุดข้อมูลและคอลเลกชันที่รวดเร็ว ผลการวิจัยของ EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein [PDF] [รหัส]

แบบจำลองภาษา Finetuned เป็นผู้เรียนที่ไม่มีการยิง ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M. Dai, Quoc V. Le [PDF] [รหัส]

การฝึกอบรมมัลติทาสก์ทำให้การฝึกอบรมเป็นแบบไม่มีการยิง ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey Eliza Szczechla Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang Sharma, Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush [PDF] [รหัส]

แบบจำลองภาษาการฝึกอบรมเพื่อทำตามคำแนะนำด้วยความคิดเห็นของมนุษย์ Preprint 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller Peter Welinder, Paul Christiano, Jan Leike, Ryan Lowe [PDF] [รหัส]

แบบจำลองภาษาขนาดใหญ่เป็นเหตุผลที่ไม่มีการยิง Preprint 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa [PDF] [รหัส]

คำถามคำถามวิดีโอแบบไม่-ช็อตผ่านโมเดลภาษาสองทิศทางแช่แข็ง Preprint 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid [PDF] [รหัส]

แบบจำลองภาษาเป็นอินเทอร์เฟซอเนกประสงค์ทั่วไป Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei [PDF] [รหัส]

การสร้างพรอมต์ระดับที่เก็บสำหรับรูปแบบภาษาขนาดใหญ่ของรหัส Preprint 2022.6

Disha Shrivastava, Hugo LaRochelle, Daniel Tarlow [PDF] [รหัส], 2022.6

ไม่สนใจพรอมต์ก่อนหน้า: เทคนิคการโจมตีสำหรับแบบจำลองภาษา รางวัล Best Paper Award @ Neurips ML Safety Workshop 2022

Fábio Perez, Ian Ribeiro [PDF] [โครงการ], 2022.11

แบบจำลองภาษาเป็นผู้เรียนไม่กี่คน Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal Ramesh, Daniel M. Ziegler Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Grey, หมากรุกเบนจามิน, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei [PDF]

สอบเทียบก่อนการใช้งาน: ปรับปรุงประสิทธิภาพการยิงไม่กี่แบบของแบบจำลองภาษา ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh [PDF] [รหัส]

คำอธิบายของการเรียนรู้ในบริบทเป็นการอนุมานแบบเบย์โดยนัย ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA [PDF] [รหัส]

ห่วงโซ่แห่งความคิดกระตุ้นให้เกิดการให้เหตุผลในรูปแบบภาษาขนาดใหญ่ Preprint 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou [PDF]

การวางนัยทั่วไปข้ามงานผ่านคำแนะนำการระดมทุนภาษาธรรมชาติ ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi [PDF] [รหัส]

คำสั่งซื้อที่น่าอัศจรรย์และสถานที่ที่จะหาพวกเขา: เอาชนะความไวต่อการสั่งซื้อไม่กี่ครั้ง ACL 2022

เหยาลู, แม็กซ์บาร์โตโล, อลาสแตร์มัวร์, เซบาสเตียน Riede, Pontus Stenetorp [PDF]

โมเดลภาษาช่องสัญญาณดังกล่าวพร้อมสำหรับการจำแนกข้อความไม่กี่ภาพ ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer [PDF] [รหัส]

Meta-Learning ผ่านการปรับแต่งแบบจำลองภาษาในบริบท ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, เขา [PDF] [รหัส]

อะไรทำให้ตัวอย่างในบริบทที่ดีสำหรับ GPT-3? deelio@ACL 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen [PDF]

เรียนรู้ที่จะดึงพรอมต์สำหรับการเรียนรู้ในบริบท NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant [PDF] [รหัส]

Metaicl: เรียนรู้ที่จะเรียนรู้ในบริบท NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi [PDF] [รหัส]

การปรับปรุงการเรียนรู้ไม่กี่ครั้งในบริบทผ่านการฝึกอบรมผู้ดูแลตนเอง NAACL 2022

Mingda Chen, Jingfei Du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva [PDF]

การเรียนรู้ในบริบทที่สร้างขึ้นด้วยตนเอง: การใช้ประโยชน์จากแบบจำลองภาษาที่ไม่เร่งรีบอัตโนมัติเป็นเครื่องกำเนิดการสาธิต LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee [PDF]

ทบทวนบทบาทของการสาธิต: สิ่งที่ทำให้การเรียนรู้ในบริบท? Preprint 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer [PDF] [รหัส]

การเรียนรู้ในบริบทสำหรับการติดตามสถานะการสนทนาไม่กี่ครั้ง Preprint 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf [PDF] [รหัส]

ความสม่ำเสมอของตนเองช่วยปรับปรุงห่วงโซ่การให้เหตุผลทางความคิดในแบบจำลองภาษา Preprint 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, Denny Zhou [PDF]

สตาร์: การใช้เหตุผลที่เป็นเหตุผลที่สอนด้วยตนเองด้วยการใช้เหตุผล Preprint 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman [PDF]

การเปรียบเทียบการวางนัยทั่วไปผ่านคำแนะนำในบริบทในงานภาษา 1,600+ Preprint 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi [PDF] [รหัส]

แบบจำลองภาษาสามารถเรียนรู้จากคำอธิบายในบริบทได้หรือไม่? - Preprint 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill [PDF]

ฉลากความจริงภาคพื้นดิน: การมองลึกลงไปในการสาธิตฉลากอินพุต Preprint 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-Woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim [PDF]

ความไม่น่าเชื่อถือของคำอธิบายในการเรียนรู้ไม่กี่ครั้งในบริบท Preprint 2022.5

Xi Ye, Greg Durrett [PDF]

การแจ้งเตือนอย่างน้อยที่สุดช่วยให้การใช้เหตุผลที่ซับซ้อนในรูปแบบภาษาขนาดใหญ่ Preprint 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi [PDF]

การแจ้งเตือน Maieutic: การใช้เหตุผลที่สอดคล้องกันอย่างมีเหตุผลพร้อมคำอธิบายแบบเรียกซ้ำ Preprint 2022.5

Jaehun Jung, Lianhui Qin, Sean Weleck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi [PDF]

ล่วงหน้าของการทำให้แบบจำลองภาษามีเหตุผลดีขึ้น Preprint 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen [PDF] [รหัส]

ความสามารถฉุกเฉินของแบบจำลองภาษาขนาดใหญ่ Preprint 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto [PDF]

แบบจำลองภาษาเป็นอินเทอร์เฟซอเนกประสงค์ทั่วไป Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming Ma, Furu Wei [PDF] [รหัส]

Transformers เรียนรู้อะไรในบริบท? กรณีศึกษาคลาสฟังก์ชั่นง่าย ๆ Preprint 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant [PDF] [รหัส]

การเรียนรู้โดยการกลั่นบริบท Preprint 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong [PDF]

แบบจำลองภาษาที่มีผลผูกพันในภาษาสัญลักษณ์ Preprint 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Noah A. Smith, Tao Yu [PDF] [รหัส] [เว็บไซต์]

การรักษาความสามารถในการเรียนรู้ในบริบทในรูปแบบการปรับแต่งแบบจำลองภาษาขนาดใหญ่ Preprint 2022.11

Yihan Wang, Si Si, Daliang Li, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar [PDF]

การสอนอัลกอริทึมการใช้เหตุผลผ่านการเรียนรู้ในบริบท Preprint 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi [PDF]

อัลกอริทึมการเรียนรู้อะไรคือการเรียนรู้ในบริบท? การตรวจสอบด้วยแบบจำลองเชิงเส้น Preprint 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou [PDF]

การปรับแต่งกล่องดำสำหรับแบบจำลองภาษา-เป็นบริการ ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu [PDF] [รหัส]

การเรียนรู้ที่รวดเร็วของกล่องดำสำหรับโมเดลภาษาที่ผ่านการฝึกอบรมมาก่อน TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang [PDF]

Grips: การค้นหาคำสั่งที่ใช้การไล่ระดับสีฟรีและการค้นหาแบบจำลองภาษาขนาดใหญ่ Preprint 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal [PDF] [รหัส]

ไม่กี่นัดที่กระตุ้นให้เกิดการตอบสนองที่ควบคุมได้ Preprint 2022.6

Hsuan SU, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-yi Lee [PDF]

BBTV2: สู่อนาคตที่ไม่มีการไล่ระดับสีด้วยรูปแบบภาษาขนาดใหญ่ EMNLP 2022

Tianxiang Sun, Zhengfu HE, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu [PDF] [รหัส]

RLPROMPT: เพิ่มประสิทธิภาพข้อความที่ไม่ต่อเนื่องพร้อมกับการเรียนรู้การเสริมแรง EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu [PDF] [รหัส]

การปรับแต่งคลิป: ไปสู่การเรียนรู้ที่รวดเร็วโดยไม่ได้รับรางวัล ผลการวิจัยของ EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang [PDF]

Tempera: การแก้ไขเวลาทดสอบเวลาผ่านการเรียนรู้การเสริมแรง Preprint 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez [PDF] [รหัส]

พรอมต์ BOOSTING: การจำแนกข้อความกล่องดำด้วยบัตรผ่านไปข้างหน้าสิบครั้ง Preprint 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang [PDF]

มัลติทาสก์ก่อนการฝึกอบรมแบบแยกส่วนสำหรับการเรียนรู้แบบไม่กี่นัดของจีน ACL 2023

Tianxiang Sun, Zhengfu HE, Qin Zhu, Xipeng Qiu, Xuanjing Huang [PDF]

เมื่อ Destcent Gradient ตรงกับการเพิ่มประสิทธิภาพแบบปราศจากอนุพันธ์: การจับคู่ที่เกิดขึ้นในสถานการณ์กล่องดำ ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao [PDF]

ทำให้การปรับแต่งกล่องดำที่มีสีสันสดใส: การเพิ่มรูปแบบทั่วไปจากมุมมองมุมฉากสามมุมมอง LREC-Coling 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao [PDF]

เพื่อปรับแต่งหรือไม่ปรับ? ปรับการเป็นตัวแทนที่ได้รับการปรับแต่งให้เข้ากับงานที่หลากหลาย repl4nlp@acl 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith [PDF]

คำอธิบายมีประโยชน์สำหรับการปรับเทียบโมเดลกล่องดำได้หรือไม่? ACL 2022

Xi Ye, Greg Durrett [PDF] [รหัส]

การฝึกอบรมร่วมปรับปรุงการเรียนรู้แบบรวดเร็วสำหรับแบบจำลองภาษาขนาดใหญ่ ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag [PDF]

Y-tuning: กระบวนทัศน์การปรับแต่งที่มีประสิทธิภาพสำหรับโมเดลที่ผ่านการฝึกอบรมมาล่วงหน้าขนาดใหญ่ผ่านการเรียนรู้การแสดงฉลาก Preprint 2022.2

Yitao Liu, Chenxin AN, Xipeng Qiu [PDF]

LST: การปรับแต่งด้านบันไดสำหรับพารามิเตอร์และการเรียนรู้การถ่ายโอนที่มีประสิทธิภาพ Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal [PDF] [รหัส]

การปรับแต่งตัวถอดรหัส: การทำความเข้าใจภาษาที่มีประสิทธิภาพเป็นการถอดรหัส Preprint 2022.12

Ganquan Cui, Wentao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun [PDF]

การสร้างชุดข้อมูลด้วยแบบจำลองภาษาที่ผ่านการฝึกอบรม EMNLP 2021

Timo Schick, Hinrich Schütze [PDF] [รหัส]

GPT3MIX: ใช้ประโยชน์จากแบบจำลองภาษาขนาดใหญ่สำหรับการเพิ่มข้อความ ผลการวิจัยของ EMNLP 2021

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-Woo Lee, Woomyeong Park [PDF] [รหัส]

สร้างความรู้ที่ได้รับการกระตุ้นให้มีการให้เหตุผลเชิงพาณิชย์ ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Weleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi [PDF] [รหัส]

Zerogen: การเรียนรู้แบบศูนย์-ช็อตที่มีประสิทธิภาพผ่านการสร้างชุดข้อมูล EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong [PDF] [รหัส]

Zerogen+: การสร้างข้อมูลที่มีคุณภาพสูงด้วยตนเองในการเรียนรู้แบบศูนย์อย่างมีประสิทธิภาพ Preprint 2022.2

Jiahui Gao, Renjie Pi, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong [PDF]

Augesc: การเสริมการสนทนาด้วยแบบจำลองภาษาขนาดใหญ่สำหรับการสนทนาการสนับสนุนทางอารมณ์ ผลการวิจัยของ ACL 2023

Chujie Zheng, Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang [PDF]

การสร้างข้อมูลการฝึกอบรมด้วยแบบจำลองภาษา: ไปสู่ความเข้าใจภาษาที่ไม่มีการยิง Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [รหัส]

- ก่อนอื่นขอบคุณที่สละเวลามีส่วนร่วม! -

ขั้นตอนในการมีส่วนร่วม:

PaperNumber ที่ด้านบนของหน้าตามและส่งคำขอดึงของคุณ เราขอแนะนำให้อธิบายสั้น ๆ ว่าทำไมคุณถึงคิดว่าควรเพิ่มหรือเปลี่ยนแปลงกระดาษไม่ต้องกังวลถ้าคุณใส่อะไรผิดพลาดเราจะแก้ไขให้คุณ เพียงแค่มีส่วนร่วมและโปรโมตงานที่ยอดเยี่ยมของคุณที่นี่!

นอกเหนือจากผู้มีส่วนร่วมต่อไปนี้ที่ส่งคำขอดึงเราขอขอบคุณ Ohad Rubin และ Kang Min Yoo สำหรับการแนะนำเอกสาร