这是“语言模型as-a-a-service(LMAAS)”论文的精选清单,该论文主要由Tianxiang Sun维护。我们强烈鼓励对此主题感兴趣的NLP研究人员提出添加或更新论文的请求(请参阅贡献)。观看此存储库以获取最新更新!

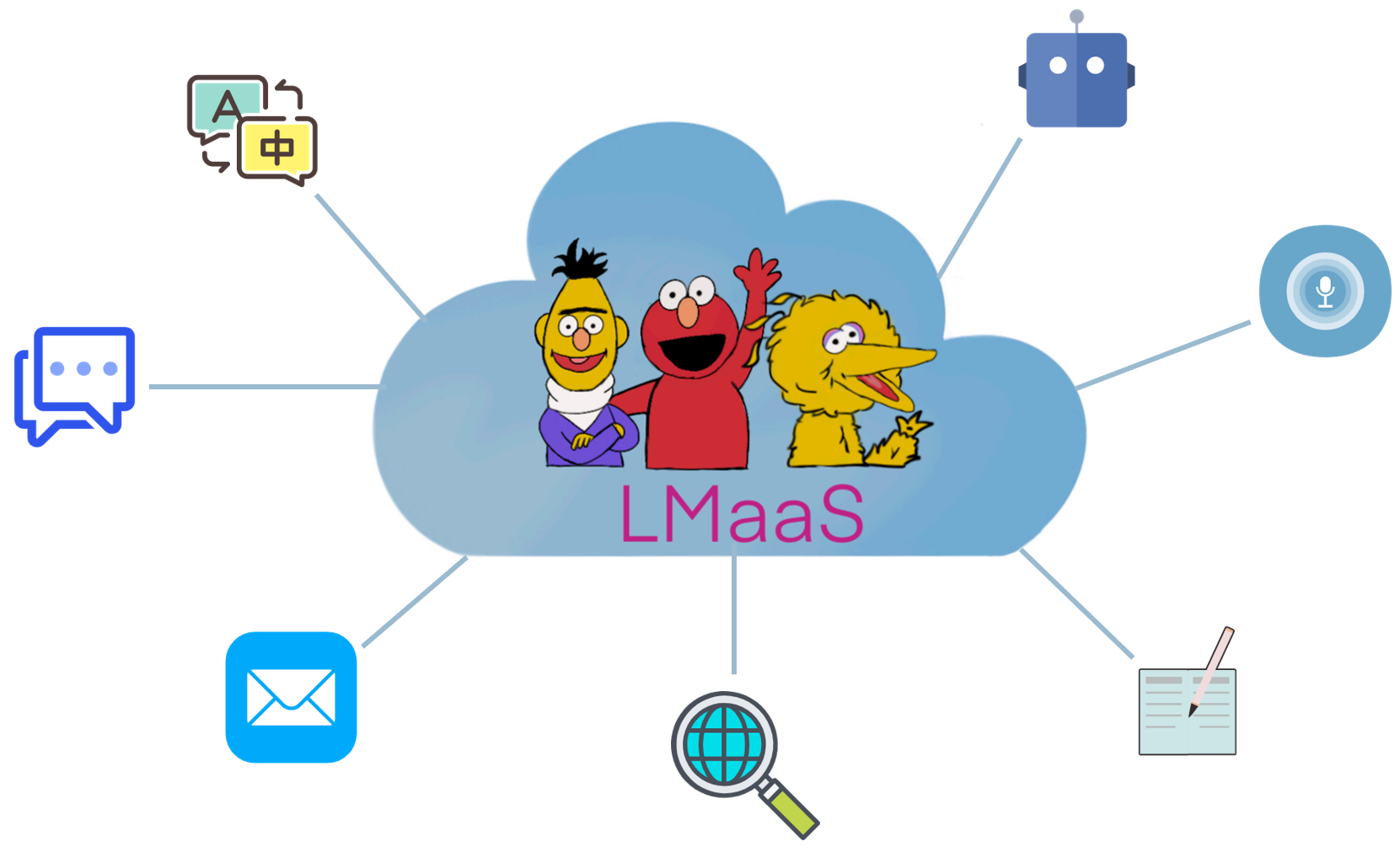

由于商业原因和昂贵的调整成本,预先培训的大型语言模型(LLM)(例如GPT-3)通常以服务而不是开源模型权重。我们称此场景为“语言模型 - as-a-service(LMAAS) ”(该术语最初用于我们的ICML'2022纸张)。在这种情况下,用户可以通过推理API访问强大的LLM。 LLM的服务为许多用例提供了动力(请参阅GPT-3演示)。与微调相反,LMAA允许单个通用LLM执行许多不同的任务,因此具有高度部署的效率。然而,如何在不访问其参数和梯度的情况下调整LLM的目标任务是一个挑战。为了使LLM受益于更广泛的受众,我们收集了适合这种情况的论文,以促进未来的研究。

哪些论文适合LMAAS的情况?我们主要考虑将LLMS调整到下游任务的论文,而无需访问模型参数和梯度。尽管部署后还可以进行微调的LLMS服务,但它们仅限于为有限的受众解决一项任务。在我们的范围中,我们更喜欢为各种用户提供通用模型。

在现有文献中,有几种适合LMAA的研究线:

文本提示和中文学习之间的边界有些模糊。在此存储库中,文本提示类别包含不使用标签样本的论文,而在上下文中的学习类别则由在提示中包含标记样本的论文组成。

注意:相关(和部分重叠)主题是基于及时的学习,该学习旨在分别通过使用某些模板和言语来转换输入和输出来使用通用LLMS解决下游任务。但是,基于及时的学习中的大多数工作都需要访问模型参数和梯度,因此不适合我们的范围。对于不适合LMAA的基于及时的学习论文,我们建议为另一个很棒的纸张列表做出贡献:提示纸。

与精细调整的特定任务LLM相比,LMAA具有以下优点:

作品的缩写。

工作的关键特征。

作品的主要实验环境。

语言模型作为知识基础? EMNLP 2019

Fabio Petroni,Timocktäschel,Patrick Lewis,Anton Bakhtin,Yuxiang Wu,Alexander H. Miller,Sebastian Riedel 。 [PDF] [代码]

我们怎么知道语言模型知道什么? TACL 2020

Zhengbao Jiang,Frank F. Xu,Jun Araki,Graham Neubig 。 [PDF] [代码]

语言模型是很少的学习者。神经2020

汤姆·B·布朗(Tom B.拉梅什,丹尼尔·齐格勒, Jeffrey Wu,Clemens Winter,Christopher Hesse,Mark Chen,Eric Sigler,Mateusz Litwin,Scott Gray,Benjamin Chess,Jack Clark,Christopher Berner,Christopher Berner,Sam McCandlish,Alec Radford,Ilya Sutskever,Dario Amodei 。 [PDF]

通过在数据集和提示集合上进行元调整来调整语言模型,以零射击学习。 EMNLP 2021的发现

Ruiqi Zhong,Kristy Lee,Zheng Zhang,Dan Klein 。 [PDF] [代码]

填充语言模型是零拍的学习者。 ICLR 2022

Jason Wei,Maarten Bosma,Vincent Y. Zhao,Kelvin Guu,Adams Wei Yu,Brian Lester,Nan du,Andrew M. Dai,Quoc V. Le 。 [PDF] [代码]

多任务提示训练可以使零击任务概括。 ICLR 2022

Victor Sanh,Albert Webson,Colin Raffel,Stephen H. Bach,Lintang Sutawika,Zaid Alyafeai,Antoine Chaffin,Arnaud Stiegler,Teven Le Scao,Arun Raja,Manan Dey,Manan Dey,Ma Saiful Bari,MaSaiph泰瓦恩(Taewoon)Eliza Szczechla Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neeraj, Jos Rozen, Abheesht Sharma ,安德里亚Santilli,Thibault Fevry,Jason Alan Fries,Ryan Teehan,Tali Bers,Stella Biderman,Leo Gao,Thomas Wolf,Alexander M. Rush 。 [PDF] [代码]

培训语言模型遵循人类反馈的说明。预印度2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell,彼得·韦林德(Peter Welinder),保罗·克里斯蒂安诺(Paul Christiano),扬·莱克瑞安·洛(Ryan Lowe) 。 [PDF] [代码]

大型语言模型是零拍的推理器。预印度2022.6

Takeshi Kojima,Shixiang Shane Gu,Machel Reid,Yutaka Matsuo,Yusuke Iwasawa 。 [PDF] [代码]

通过冷冻双向语言模型回答零拍的视频问题。预印度2022.6

Antoine Yang,Antoine Miech,Josef Sivic,Ivan Laptev,Cordelia Schmid 。 [PDF] [代码]

语言模型是通用接口。预印度2022.6

Yaru Hao,Haoyu Song,Li Dong,Shaohan Huang,Zewen Chi,Wenhui Wang,Ma,Furu Wei 。 [PDF] [代码]

存储库级的及时生成大型代码的大型语言模型。预印度2022.6

Disha Shrivastava,Hugo Larochelle,Daniel Tarlow [PDF] [Code],2022.6

忽略以前的提示:语言模型的攻击技术。最佳纸张奖 @ Neurips ML安全研讨会2022。

FábioPerez,Ian Ribeiro [PDF] [Project],2022.11

语言模型是很少的学习者。神经2020

汤姆·B·布朗(Tom B.拉梅什,丹尼尔·齐格勒, Jeffrey Wu,Clemens Winter,Christopher Hesse,Mark Chen,Eric Sigler,Mateusz Litwin,Scott Gray,Benjamin Chess,Jack Clark,Christopher Berner,Christopher Berner,Sam McCandlish,Alec Radford,Ilya Sutskever,Dario Amodei 。 [PDF]

使用前校准:提高语言模型的少量性能。 ICML 2021

Tony Z. Zhao,Eric Wallace,Shi Feng,Dan Klein,Sameer Singh 。 [PDF] [代码]

将内在学习作为隐性贝叶斯推论的解释。 ICLR 2022

Sang Michael Xie,Aditi Raghunathan,Percy Liang,Tengyu MA 。 [PDF] [代码]

思想链促使人们在大语言模型中引起推理。预印度2022.1

Jason Wei,Xuezhi Wang,Dale Schuurmans,Maarten Bosma,Brian Ichter,Fei Xia,Ed Chi,Quoc Le,Quoc LE,Denny Zhou 。 [PDF]

通过自然语言众包指令进行跨任务概括。 ACL 2022

Swaroop Mishra,Daniel Khashabi,Chitta Baral,Hannaneh Hajishirzi 。 [PDF] [代码]

井井有条的提示和在哪里找到它们:克服几乎没有弹药的订单灵敏度。 ACL 2022

lu,Max Bartolo,Alastair Moore,Sebastian Riede,Pontus Stenetorp 。 [PDF]

嘈杂的频道语言模型提示进行几个弹头文本分类。 ACL 2022

Sewon Min,Mike Lewis,Hannaneh Hajishirzi,Luke Zettlemoyer 。 [PDF] [代码]

通过语言模型在语言中进行元学习。 ACL 2022

Yanda Chen,Ruiqi Zhong,Sheng Zha,George Karypis,他。 [PDF] [代码]

是什么使GPT-3的良好的文本示例呢? Deelio@ACL 2022

Jiachang Liu,Dinghan Shen,Yizhe Zhang,Bill Dolan,Lawrence Carin,Weizhu Chen 。 [PDF]

学会检索提示中的内在学习。 NAACL 2022

Ohad Rubin,Jonathan Herzig,Jonathan Berant 。 [PDF] [代码]

metaicl:学习在上下文中学习。 NAACL 2022

Sewon Min,Mike Lewis,Luke Zettlemoyer,Hannaneh Hajishirzi 。 [PDF] [代码]

通过自我监督培训来改善内在的几次学习。 NAACL 2022

Mingda Chen,Jingfei du,Ramakanth Pasunuru,Todor Mihaylov,Srini Iyer,Veselin Stoyanov,Zornitsa Kozareva 。 [PDF]

自我生成的文化学习:利用自动回归语言模型作为演示生成器。 LPLM@NAACL 2022

Hyuhng Joon Kim,Hyunsoo Cho,Junyeob Kim,Taeuk Kim,Kang Min Yoo,Sang-Goo Lee 。 [PDF]

重新思考示范的作用:是什么使内在的学习工作?预印度2022.2

Sewon Min,Xinxi Lyu,Ari Holtzman,Mikel Artetxe,Mike Lewis,Hannaneh Hajishirzi,Luke Zettlemoyer 。 [PDF] [代码]

对话状态跟踪的文本学习。预印度2022.3

Yushi Hu,Chia-Hsuan Lee,Tianbao Xie,Tao Yu,Noah A. Smith,Mari Ostendorf 。 [PDF] [代码]

自洽性改善了语言模型中的思想推理链。预印度2022.3

Xuezhi Wang,Jason Wei,Dale Schuurmans,Quoc Le,Ed Chi,Denny Zhou 。 [PDF]

星:自学成才的推理推理推理。预印度2022.3

Eric Zelikman,Yuhuai Wu,Noah D. Goodman 。 [PDF]

通过对1,600多个语言任务的文章中的指令进行基准概括。预印度2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshaan Pathak, Giannis Karamanolakis, Haizhi Gary Lai, Ishan Purohit, Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulkit Verma, Ravsehaj Singh Puri, Rushang Karia, Shailaja Keyur Sampat,Savan Doshi,Siddhartha Mishra,Sujan Reddy,Sumanta Patro,Tanay Dixit,Xudong Shen,Chitta Baral,Yejin Choi,Noah A. Smith,Hannaneh Hajishirzi,Daniel Hajishirzi,Daniel Khashabi 。 [PDF] [代码]

语言模型可以从上下文中的解释中学习吗? 。预印度2022.4

Andrew K. Lampinen,Ishita Dasgupta,Stephanie Cy Chan,Kory Matthewson,Michael Henry Tessler,Antonia Creswell,James L. McClelland,Jane X. Wang,Felix Hill 。 [PDF]

地面真实标签很重要:更深入地研究输入标签的演示。预印度2022.5

Junyeob Kim,Hyuhng Joon Kim,Hyunsoo Cho,Hwiyeol Jo,Sang-Woo Lee,Sang-Goo Lee,Kang Min Yoo,Taeuk Kim 。 [PDF]

在几乎没有镜头的学习中解释的不可靠性。预印度2022.5

Xi ye,Greg Durrett 。 [PDF]

最小一是提示可以在大型语言模型中实现复杂的推理。预印度2022.5

Denny Zhou,NathanaelSchärli,Le Hou,Jason Wei,Nathan Scales,Xuezhi Wang,Dale Schuurmans,Olivier Bousquet,Quoc Le,Ed Chi 。 [PDF]

Maieutic提示:逻辑上一致的推理,并进行递归解释。预印度2022.5

Jaehun Jung,Lianhui Qin,Sean Welleck,Faeze Brahman,Chandra Bhagavatula,Ronan Le Bras,Yejin Choi 。 [PDF]

在使语言模型的推动下,更好的推理器。预印度2022.6

Yifei Li,Zeqi Lin,Shizhuo Zhang,Qiang Fu,Bei Chen,Jian-Guang Lou,Weizhu Chen 。 [PDF] [代码]

大型语言模型的紧急能力。预印度2022.6

Jason Wei,Yi Tay,Rishi Bommasani,Colin Raffel,Barret Zoph,Sebastian Borgeaud,Dani Yogatama,Maarten Bosma,Denny Zhou,Donny Zhou,Donald Metzler,Ed H. Chi,Tatsunori Hashimoto,Tatunori Hashimoto,Oriol Vinyals,Oriol Vinyals,Percy Liang Liang,William fedus,jeff defus,jeff deas eff deas eff 。 [PDF]

语言模型是通用接口。预印度2022.6

Yaru Hao,Haoyu Song,Li Dong,Shaohan Huang,Zewen Chi,Wenhui Wang,Ma,Furu Wei 。 [PDF] [代码]

变形金刚可以在文化中学习什么?简单功能类别的案例研究。预印度2022.8

Shivam Garg,Dimitris Tsipras,Percy Liang,Gregory Valiant 。 [PDF] [代码]

通过蒸馏上下文学习。预印度2022.9

查理·斯内尔(Charlie Snell),丹·克莱因(Dan Klein),瑞奇(Ruiqi Zhong) 。 [PDF]

用符号语言绑定语言模型。预印度2022.10

Zhoujun Cheng*,Tianbao Xie*,Peng Shi,Chengzu Li,Rahul Nadkarni,Yushi Hu,Caiming Xiong,Dragomir Radev,Mari Ostendorf,Luke Zettlemoyer,Luke Zettlemoyer,Noah A. Smith,Tao Yu 。 [PDF] [代码] [网站]

在大语言模型微调中保留文化学习能力。预印度2022.11

Yihan Wang,Si Si,Daliang Li,Michal Lukasik,Felix Yu,Cho-Jui Hsieh,Inderjit S Dhillon,Sanjiv Kumar 。 [PDF]

通过文化学习来教授算法推理。预印度2022.11

Hattie Zhou,Azade Nova,Hugo Larochelle,Aaron Courville,Behnam Neyshabur,Hanie Sedghi 。 [PDF]

哪些学习算法是在文化中学习?对线性模型进行调查。预印度2022.11

EkinAkyürek,Dale Schuurmans,Jacob Andreas,Tengyu MA,Denny Zhou 。 [PDF]

语言模型的黑盒调整。 ICML 2022

天xiang sun,Yunfan Shao,Hong Qian,Xuanjing Huang,Xipeng Qiu。 [PDF] [代码]

黑框促使学习预训练的语言模型。 TMLR 2023.2

Shizhe Diao,Xuechun Li,Yong Lin,Zhichao Huang,Tong Zhang 。 [PDF]

握把:无梯度,基于编辑的指令搜索,以提示大型语言模型。预印度2022.3

Archiki Prasad,Peter Hase,Xiang Zhou,Mohit Bansal 。 [PDF] [代码]

很少射击,促使可控响应生成。预印度2022.6

Hsuan Su,Pohan Chi,Shih-Cheng Huang,Chung Ho Lam,Saurav Sahay,Shang-Tse Chen,Hung-Yi Lee 。 [PDF]

BBTV2:迈向具有大语言模型的无梯度未来。 EMNLP 2022

天xiang sun,Zhengfu He,Hong Qian,Yunhua Zhou,Xuanjing Huang,Xipeng Qiu 。 [PDF] [代码]

RLPrompt:通过增强学习优化离散文本提示。 EMNLP 2022

Mingkai Deng,Jianyu Wang,Cheng-Ping Hsieh,Yihan Wang,Han Guo,Tianmin Shu,Meng Song,Eric P. Xing,Zhiting Hu 。 [PDF] [代码]

剪辑调整:迈向无衍生的及时学习,并混合奖励。 EMNLP 2022的发现

Yekun Chai,Shuohuan Wang,Yu Sun,Hao Tian,Hua Wu,Haifeng Wang 。 [PDF]

蛋白质:测试时间及时通过增强学习进行编辑。预印度2022.11

Tianjun Zhang,Xuezhi Wang,Denny Zhou,Dale Schuurmans,Joseph E. Gonzalez。 [PDF] [代码]

提示启动:带有十个前向通行证的黑框文本分类。预印度2022.12

Bairu Hou,Joe O'Connor,Jacob Andreas,Shiyu Chang,Yang Zhang 。 [PDF]

多任训练模块化提示的多任务预培训,以进行中文几次学习。 ACL 2023

天xiang sun,Zhengfu He,Qin Zhu,Xipeng Qiu,Xuanjing Huang 。 [PDF]

当梯度下降符合无衍生物的优化时:在黑框方案中进行的匹配。 ACL 2023

Chengcheng Han,Liqing Cui,Renyu Zhu,Jianing Wang,Nuo Chen,Qiushi Sun,Xiang Li,Ming Gao 。 [PDF]

使基于及时的黑框调音彩色:从三个正交角度来增强模型的概括。 LREC-Coling 2024

Qiushi Sun,Chengcheng Han,Nuo Chen,Renyu Zhu,Jingyang Gong,Xiang Li,Ming Gao 。 [PDF]

调音还是不调音?将预估计的代表适应各种任务。 REPL4NLP@ACL 2019

Matthew E. Peters,Sebastian Ruder,Noah A. Smith 。 [PDF]

解释对校准黑匣子型号有用吗? ACL 2022

Xi ye,Greg Durrett 。 [PDF] [代码]

共同培训改善了针对大型语言模型的迅速学习。 ICML 2022

亨特·朗(Hunter Lang),莫妮卡·阿格拉瓦尔(Monica Agrawal),尹金(Yoon Kim),大卫·桑塔格(David Sontag) 。 [PDF]

Y-Tuning:通过标签表示学习的大规模预训练模型的有效调整范例。预印度2022.2

Yitao Liu,Chenxin AN,Xipeng Qiu 。 [PDF]

LST:用于参数和内存有效传输学习的梯子侧调。神经2022

Yi-lin Sung,Jaemin Cho,Mohit Bansal 。 [PDF] [代码]

解码器调整:有效的语言理解是解码。预印度2022.12

Ganqu Cui,Winao Li,Ning ding,Longtao Huang,Zhiyuan Liu,毛松太阳。 [PDF]

使用验证的语言模型生成数据集。 EMNLP 2021

Timo Schick,HinrichSchütze 。 [PDF] [代码]

GPT3MIX:利用大型语言模型进行文本增强。 EMNLP 2021的发现

Kang Min Yoo,Dongju Park,Jaewook Kang,Sang-Woo Lee,Woomyeong Park 。 [PDF] [代码]

产生的知识促使常识性推理。 ACL 2022

Jicheng Liu,Alisa Liu,Ximing Lu,Sean Welleck,Peter West,Ronan Le Bras,Yejin Choi,Hannaneh Hajishirzi 。 [PDF] [代码]

零:通过数据集生成有效的零击学习。 EMNLP 2022

Jicheng Ye,Jiahui Gao,Qintong Li,Hang Xu,Jiangtao Feng,Zhiyong Wu,Tao Yu,Lingpeng Kong 。 [PDF] [代码]

零体+:有效的零击学习中的自引导高质量数据生成。预印度2022.2

Jihui Gao,Renjie Pi,Yong Lin,Hang Xu,Jicheng Ye,Zhiyong Wu,Xiaodan Liang,Zhenguo li,Lingpeng Kong 。 [PDF]

GOUSC:使用大语言模型进行对话进行对话,以进行情感支持对话。 ACL 2023的发现

Chujie Zheng,Sahand Sabour,Jiaxin Wen,Zheng Zhang,Minlie Huang 。 [PDF]

使用语言模型生成培训数据:朝着零局的语言理解。神经2022

Yu Meng,Jiaxin Huang,Yu Zhang,Jiawei Han [PDF] [代码]

?首先,感谢您抽出宝贵的时间做出贡献! ?

贡献的步骤:

PaperNumber ,然后提交您的拉请请求。我们建议给出一个非常简短的解释,为什么您认为应该添加或更改论文。不用担心,如果您错了问题,我们会为您修复它们。只需在这里做出贡献并促进您的出色工作!

除了提交拉动请求的以下贡献者外,我们还要感谢Ohad Rubin和Kang Min Yoo推荐论文。