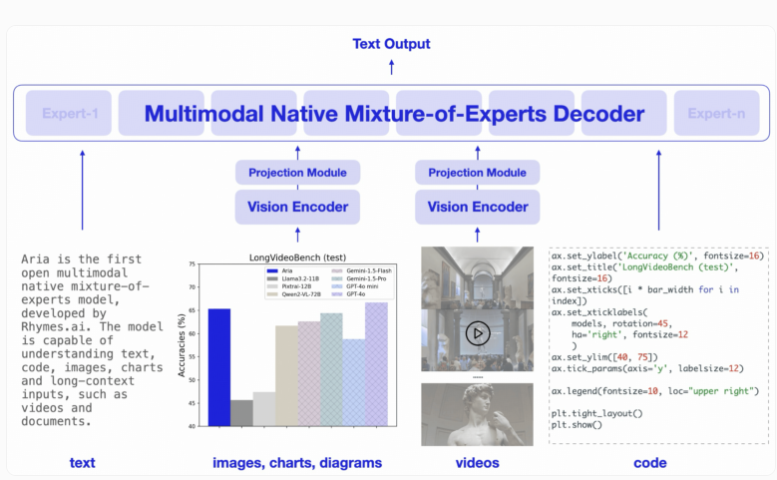

日本东京初创公司Rhymes AI发布了其首款人工智能模型Aria,这是一个开源的多模态混合专家(MoE)模型。Downcodes小编获悉,Aria在处理文本、代码、图像和视频等多种输入方面表现出色,其能力甚至超越了一些知名的商业模型。Aria采用独特的MoE架构,通过多个专业专家提高计算效率,并拥有高达249亿个参数和64,000个令牌的多模态上下文窗口,使其能够处理更长的输入数据。Rhymes AI还与AMD合作,优化模型性能,并推出了基于AMD硬件的BeaGo搜索应用。

Aria 的设计理念是希望能够在文本、代码、图像和视频等多种输入形式上,提供卓越的理解和处理能力。与传统的 Transformer 模型不同,MoE 模型通过多个专业的专家来替代其前馈层。当处理每个输入令牌时,一个路由模块会选择一部分专家进行激活,从而提高计算效率,减少每个令牌的激活参数数量。

Aria 的解码器每个文本令牌可以激活35亿个参数,整个模型拥有249亿个参数。为了处理视觉输入,Aria 还设计了一款轻量级的视觉编码器,拥有4.38亿个参数,可以将各种长度、大小和纵横比的视觉输入转换为视觉令牌。此外,Aria 的多模态上下文窗口达到64,000个令牌,意味着它能处理更长的输入数据。

在训练方面,Rhymes AI 共分为四个阶段,先用文本数据进行预训练,再引入多模态数据,接着是长序列的训练,最后进行微调。

在此过程中,Aria 总共使用了6.4万亿个文本令牌和4000亿个多模态令牌进行预训练,数据来自 Common Crawl 和 LAION 等知名数据集,并进行了部分合成增强。

根据相关基准测试,Aria 在多个多模态、语言和编程任务中表现优于 Pixtral-12B 和 Llama-3.2-11B 等模型,并且因激活参数较少,推理成本也较低。

此外,Aria 在处理带有字幕的视频或多页文档时表现良好,其理解长视频和文档的能力超过了 GPT-4o mini 和 Gemini1.5Flash 等其他开源模型。

为便于使用,Rhymes AI 将 Aria 的源代码以 Apache2.0许可证形式发布在 GitHub 上,支持学术和商业使用。同时,他们还提供了一个训练框架,可以在单个 GPU 上对 Aria 进行多种数据源和格式的微调。值得一提的是,Rhymes AI 与 AMD 达成了合作,以优化模型性能,展示了一款名为 BeaGo 的搜索应用,该应用能够在 AMD 硬件上运行,为用户提供更全面的文本和图像 AI 搜索结果。

划重点:

Aria 是全球首个开源的多模态混合专家 AI 模型。

Aria 在处理文本、图像和视频等多种输入时,表现出色,超越了许多同行模型。

? Rhymes AI 与 AMD 合作,优化模型性能,并推出支持多种功能的 BeaGo 搜索应用。

总而言之,Aria 模型的开源和高性能,为人工智能领域带来了新的突破,也为开发者和研究者提供了强大的工具。其多模态能力和高效的计算效率,使其在未来应用中拥有巨大的潜力。 Downcodes小编期待Aria在更多领域的应用和发展。