Downcodes小编带你了解瑞士洛桑联邦理工学院(EPFL)最新研究成果!该研究深入比较了两种主流大型语言模型 (LLM) 的适应性训练方法:上下文学习 (ICL) 和指令微调 (IFT),并使用 MT-Bench 基准测试对模型遵循指令的能力进行了评估。研究结果显示,两种方法在不同场景下各有千秋,为 LLM 的训练方法选择提供了宝贵的参考。

瑞士洛桑联邦理工学院 (EPFL) 的一项最新研究比较了两种主流的大型语言模型 (LLM) 适应性训练方法:上下文学习 (ICL) 和指令微调 (IFT)。研究人员使用 MT-Bench 基准测试来评估模型遵循指令的能力,发现在特定情况下,两种方法的表现各有优劣。

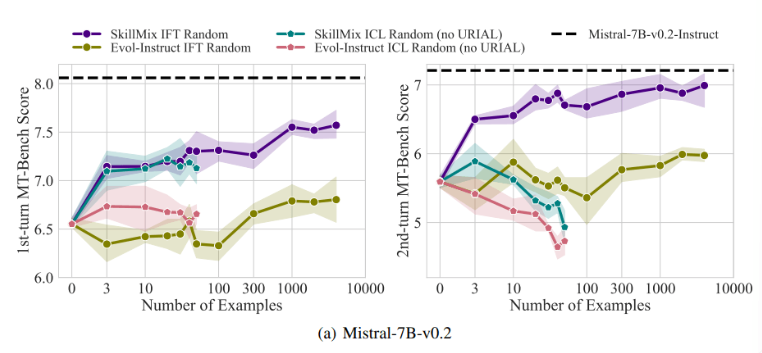

研究发现,当可用的训练样本数量较少时(例如不超过50个),ICL 和 IFT 的效果非常接近。这表明在数据有限的情况下,ICL 或许可以作为 IFT 的替代方案。

然而,随着任务复杂度的增加,例如在多轮对话场景中,IFT 的优势就变得明显。研究人员认为,ICL 模型容易过度拟合到单个样本的风格,导致在处理复杂对话时表现不佳,甚至不如基础模型。

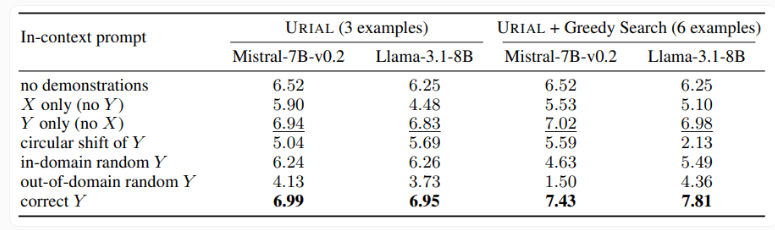

研究还考察了 URIAL 方法,这种方法仅使用三个样本和指令遵循规则来训练基础语言模型。虽然 URIAL 取得了一定的效果,但与经过 IFT 训练的模型相比仍有差距。EPFL 的研究人员通过改进样本选择策略,提升了 URIAL 的性能,使其接近微调模型。这凸显了高质量训练数据对 ICL、IFT 以及基础模型训练的重要性。

此外,研究还发现解码参数对模型性能有显著影响。这些参数决定了模型如何生成文本,对基础 LLM 和使用 URIAL 训练的模型都至关重要。

研究人员指出,即使是基础模型,在合适的解码参数下也能在一定程度上遵循指令。

这项研究的意义在于,它揭示了上下文学习可以快速有效地调整语言模型,尤其是在训练样本有限的情况下。但对于多轮对话等复杂任务,指令微调仍然是更优的选择。

随着数据集规模的扩大,IFT 的性能会持续提升,而 ICL 的性能在达到一定样本数量后会趋于稳定。研究人员强调,选择 ICL 还是 IFT 取决于多种因素,例如可用资源、数据量和具体应用需求。无论选择哪种方法,高质量的训练数据都至关重要。

总而言之,EPFL 的这项研究为大型语言模型的训练方法选择提供了新的见解,也为未来的研究方向指明了道路。选择 ICL 还是 IFT 需要根据具体情况权衡利弊,高质量的数据始终是关键。希望这项研究能帮助大家更好地理解和应用大型语言模型。