大型语言模型(LLM)的“黑盒”特性一直是困扰人工智能领域的重要问题。模型输出结果的不可解释性,使得其可靠性和可信度难以保证。为了解决这一难题,OpenAI推出了一种名为Prover-Verifier Games(PVG)的新技术,旨在提升LLM输出的可解释性和可验证性。Downcodes小编将为您详细解读这项技术。

OpenAI最近发布了一项名为Prover-Verifier Games(PVG)的新技术,旨在解决人工智能模型输出的“黑盒”问题。

想象一下,你有一个超级智能的助手,但它的思考过程就像一个黑盒子,你完全不知道它是怎么得出结论的。这听起来是不是有点让人不放心?没错,这就是目前很多大型语言模型(LLM)面临的问题。它们虽然强大,但生成的内容准确性却难以验证。

论文网址:https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

为了解决这个问题,OpenAI推出了PVG技术。简单来说,就是让小模型(比如GPT-3)来监督大模型(比如GPT-4)的输出。这就像是在玩一个游戏,证明者(Prover)负责生成内容,而验证者(Verifier)则负责判断这些内容是否正确。听起来是不是很有趣?

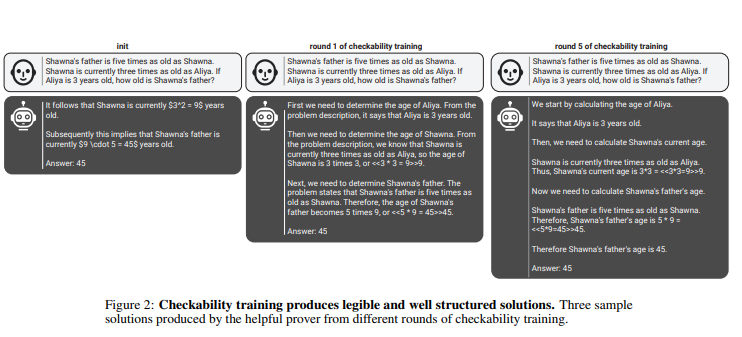

在这个规则中,证明者和验证者通过多轮迭代训练,不断提升自己的能力。验证者通过监督学习来预测内容的正确性,而证明者则通过强化学习来优化其生成的内容。更有趣的是,还有两种类型的证明者:有用的证明者和狡猾的证明者。有用的证明者努力生成正确且有说服力的内容,而狡猾的证明者则试图生成错误但同样有说服力的内容,以此来挑战验证者的判断力。

penAI强调,为了训练有效的验证者模型,需要大量真实准确的标签数据,以提升其识别能力。否则,即使使用PVG技术,验证的内容仍可能存在非法输出的风险。

划重点:

? PVG技术通过小模型验证大模型输出,解决了AI“黑盒”问题。

? 训练框架基于博弈论,模拟证明者和验证者的互动,提高了模型输出的准确性和可控性。

? 需要大量真实数据来训练验证者模型,确保其具备足够的判断力和鲁棒性。

总而言之,OpenAI的PVG技术为解决人工智能模型的“黑盒”问题提供了一种新思路,但其有效性仍依赖于高质量的训练数据。 这项技术的未来发展值得期待,它将推动人工智能模型朝着更加可靠、可解释和可信的方向发展。Downcodes小编期待看到更多类似的创新技术出现。