Downcodes小编获悉,Hugging Face近日发布了一款名为SmolLM的全新AI工具,这是一系列参数规模从135M到1.7B不等的小型语言模型,旨在为各种设备和应用提供高效、强大的AI能力。SmolLM模型在资源有限的设备上也能出色运行,同时兼顾用户隐私保护,非常适合在手机和平板电脑等设备上使用。

最近,Hugging Face推出了一款全新的AI工具——SmolLM。这是一系列高性能的小型语言模型,参数从135M到1.7B不等,专门为各种设备和应用设计。想象一下,这些小模型能够在手机和笔记本电脑上高效运行,简直太酷了!

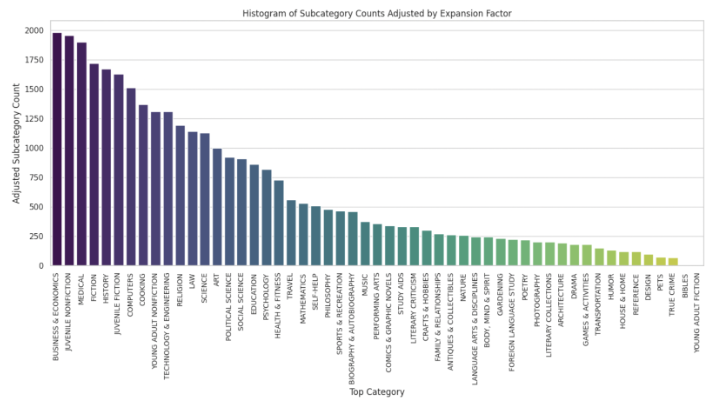

SmolLM模型的特点就是小巧而强大。它们能在更少的计算资源下,依然表现出色,帮助用户保护隐私。Hugging Face在训练这些模型时使用了一个叫做SmolLM-Corpus的数据集,这个数据集经过精心挑选,包含了丰富的教育和合成数据,确保模型能够学习到各种知识。

具体来说,SmolLM有三个版本:135M、360M和1.7B参数。这些模型不仅能处理多种任务,还能根据用户的硬件配置,灵活运行。比如,SmolLM-135M模型就超越了许多同类产品,成为了小于200M参数模型中的佼佼者。

SmolLM模型在各个基准测试中进行了评估,测试了常识推理和世界知识。这些型号表现出令人印象深刻的性能,在各自的尺寸类别中表现优于其他型号。例如,尽管在较少的令牌上进行了训练,但 SmolLM-135M 模型超过了 MobileLM-125M,后者是当前参数小于200M 的最佳模型。同样,SmolLM-360M 和 SmolLM-1.7B 模型分别优于参数小于500M 和2B 的所有其他模型。

除了优秀的性能,SmolLM还经过了特别的调教,使得它在理解指令和回答问题时更加出色。Hugging Face还提供了WebGPU的演示,大家可以直接体验这些模型的能力。

SmolLM的发布证明了即使是小型模型,也能通过高质量的训练数据,实现令人惊叹的表现。

产品入口:https://top.aibase.com/tool/smollm

划重点:

1. **高效性能**:SmolLM模型在低计算资源下也能表现出色,保护用户隐私。

2. **丰富数据**:使用高质量的SmolLM-Corpus数据集,确保模型学习到多样知识。

3. ? **多种应用**:适用于手机、笔记本等设备,灵活运行,满足不同需求。

SmolLM凭借其高效的性能、丰富的知识储备以及广泛的应用性,为AI领域带来了新的可能性。 Downcodes小编相信,SmolLM将会在未来AI应用中发挥重要作用。赶紧去体验一下吧!