阿里巴巴通义千问团队发布了令人惊艳的Qwen2-Math数学模型,其性能在多个基准测试中超越了GPT-4,甚至在7B参数量版本上就超过了72B参数量的开源模型NuminaMath。该模型不仅能够处理文字输入的数学问题,还能识别图片和截图中的公式,堪称数学学习的强大辅助工具。不同版本(72B、7B和1.5B)针对不同需求提供选择,展现出强大的性能和适应性。

阿里巴巴的通义千问团队又搞了个大新闻!他们刚刚放出了Qwen2Math Demo,这个数学模型简直是个小怪兽,连GPT-4都被它踩在脚下。

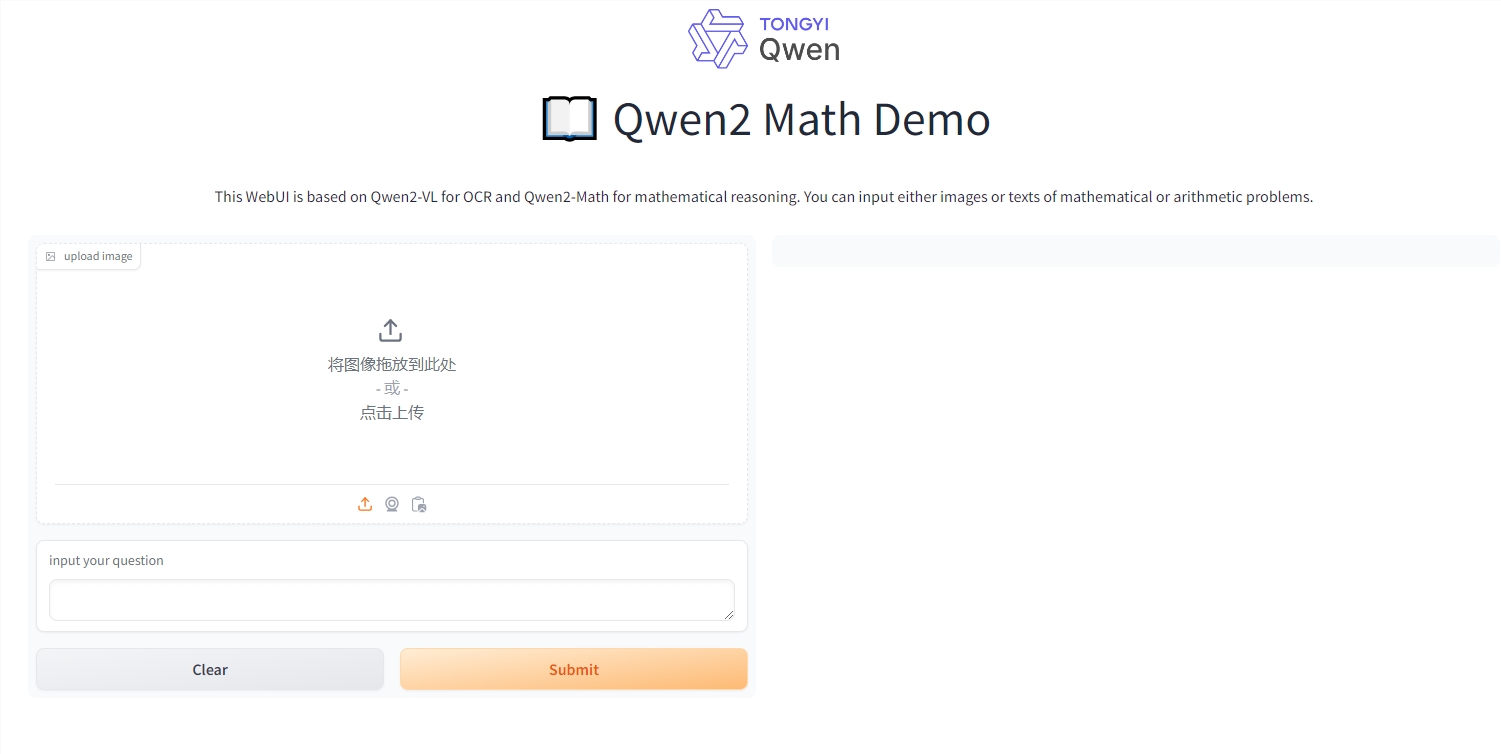

这个模型不仅能处理文字输入的数学问题,还能读懂图片和截图中的公式。想象一下,你拍个算式的照片,它就能给你解答,简直就是数学课上的做题神器啊!(当然,我们并不提倡作弊哦)

Qwen2-Math推出了三个版本:72B、7B和1.5B。其中72B版本简直是个数学天才,在MATH数据集上居然比GPT-4多得了7分,提高了9.6%。这就好比高考数学你考了145分,而你旁边的学霸只考了132分。

更厉害的是,7B版本用不到十分之一的参数量,就超过了72B的开源数学模型NuminaMath。要知道,NuminaMath可是在全球首届AIMO中获奖的模型,奖项还是由数学界的顶级大佬陶哲轩亲自颁发的。

阿里的高级算法专家林俊旸兴奋地宣布,他们把Qwen2模型变成了一个数学高手。怎么做到的呢?他们用了一个特制的数学补脑液——精心设计的数学专用语料库。这个补脑液包含了大量高质量的数学网络文本、书籍、代码、考试题目,甚至还有Qwen2模型自己编的数学题。

结果呢?在GSM8K、MATH等经典数学测试集上,Qwen2-Math-72B把405B的Llama-3.1都甩在了身后。这些测试集可不是闹着玩的,里面有代数、几何、概率、数论等各种数学难题。

不仅如此,Qwen2-Math还挑战了中文数据集CMATH和高考试题。在中文数据集上,连1.5B版本都能吊打70B的Llama3.1。而且,无论哪个版本,相比同规模的Qwen2基础模型,成绩都有明显提升。

看来,通义千问这次是真的问出了一个数学天才啊!以后做数学题,我们是不是可以问问它了?不过记住,这只是个工具,可别被它的聪明才智迷惑了眼睛,自己的数学功底还是得好好练啊!

在线体验地址:https://huggingface.co/spaces/Qwen/Qwen2-Math-Demo

Qwen2-Math的出现,标志着大型语言模型在数学领域取得了显著进展。虽然它是一个强大的工具,但更重要的是培养自身的数学能力,切勿依赖工具而忽略了学习过程。期待未来Qwen2-Math能够在更多领域发挥作用,为学习和科研带来更多便利。