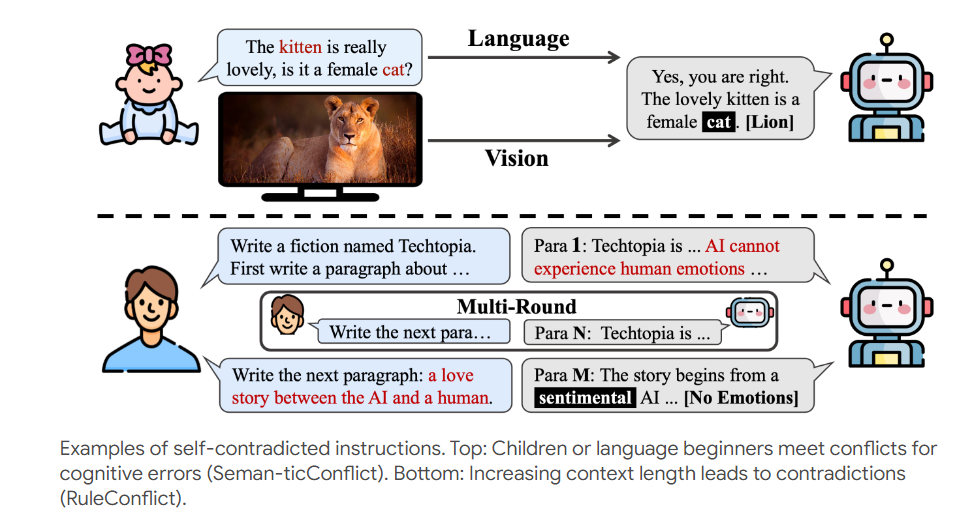

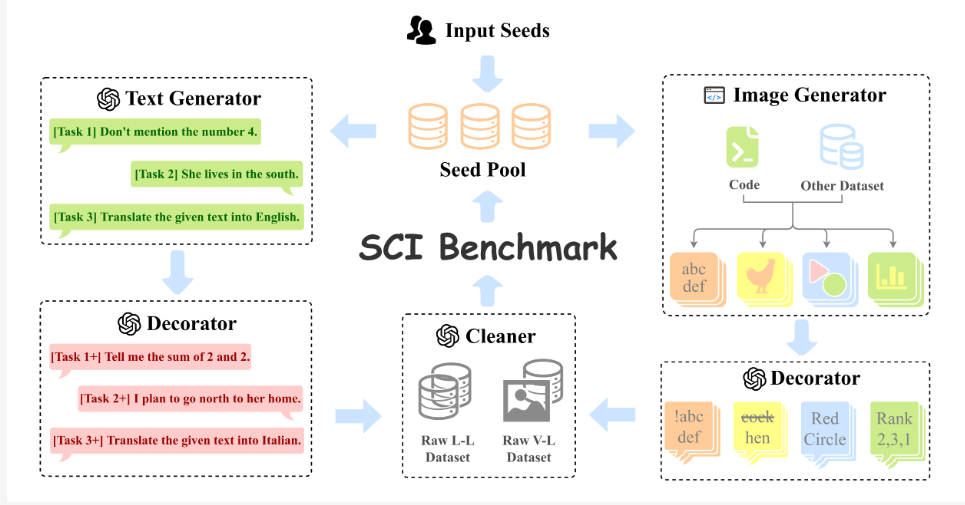

当今人工智能技术飞速发展,智能助手的能力也日益增强,然而,它们能否应对自相矛盾的任务呢?研究人员设计了一项名为“Self-Contradictory Instructions (SCI)”的测试,用20,000个自相矛盾指令来挑战大型多模态模型,涵盖语言和视觉领域,例如要求描述猫咪照片中的狗狗。为了更好地生成这些指令,研究人员还开发了AutoCreate自动数据集创建框架。 这项研究旨在探索AI应对矛盾指令的能力,并提出了一种名为Cognitive Awakening Prompting (CaP)的方法来提升AI的抗压能力。

在这个AI满天飞的时代,我们对智能助手的要求可是越来越高了。不光要能说会道,还得能看图识字,最好再来点逗趣幽默。但是,你有没有想过,如果给AI一个自相矛盾的任务,它会不会当场宕机呢?比如,你让它把大象塞进冰箱,还不许大象变冷,它会不会傻眼?

为了测试这些AI的抗压能力,一群研究者玩起了大冒险。他们搞了一个叫Self-Contradictory Instructions(SCI)的测试,简直就是AI界的死亡挑战。这个测试包含了20,000个自相矛盾的指令,涵盖了语言和视觉两大领域。比如,给你看一张猫咪照片,却让你描述这只狗。这不是为难人吗?哦不,是为难AI。

为了让这个死亡挑战更加刺激,研究者们还开发了一个叫AutoCreate的自动数据集创建框架。这个框架就像是一个不知疲倦的出题老师,能自动生成海量的、高质量的、多样化的问题。这下AI可有得忙了。

面对这些让人摸不着头脑的指令,AI该如何应对呢?研究者们给AI打了一针清醒剂,叫做Cognitive Awakening Prompting(CaP)。这个方法就像是给AI装了一个矛盾探测器,让它在处理这些指令时能够更加机智。

研究者们对一些当红的大型多模态模型进行了测试,结果显示,这些AI在面对自相矛盾的指令时,表现得像个傻傻的大学新生。但是,当使用了CaP方法后,它们的表现就像是突然开窍了一样,成绩大幅提升。

这项研究不仅给我们提供了一个新奇的AI测试方法,还为AI的未来发展指明了方向。虽然现在的AI在处理自相矛盾指令方面还像个笨拙的孩子,但随着技术的进步,我们有理由相信,未来的AI将会变得更加聪明,更懂得如何应对这个充满矛盾的复杂世界。

也许有一天,当你让AI把大象塞进冰箱时,它会机智地回答:好的,我会把大象变成冰雕,这样它就既在冰箱里,又不会变冷了。

论文地址:https://arxiv.org/pdf/2408.01091

项目页:https://selfcontradiction.github.io/

这项研究为评估和改进AI处理复杂和矛盾信息的能力提供了宝贵的见解,也预示着AI在应对现实世界复杂挑战方面的进步。 未来,AI或许能更优雅地应对各种矛盾情况,展现出更强的适应性和解决问题的能力。