Anthropic API 推出了期待已久的新功能——提示缓存,这将显着提升Claude 模型的效率和经济性。此功能允许开发者在API 调用之间缓存常用的上下文信息,从而减少冗余计算,降低成本和延迟。对于需要处理大量上下文信息的应用场景,例如对话代理、编码助手和大型文档处理,提示缓存将带来巨大的性能提升。这项更新目前已在Claude3.5 Sonnet 和Claude3 Haiku 的公开测试版中上线,并计划扩展至Claude3 Opus。

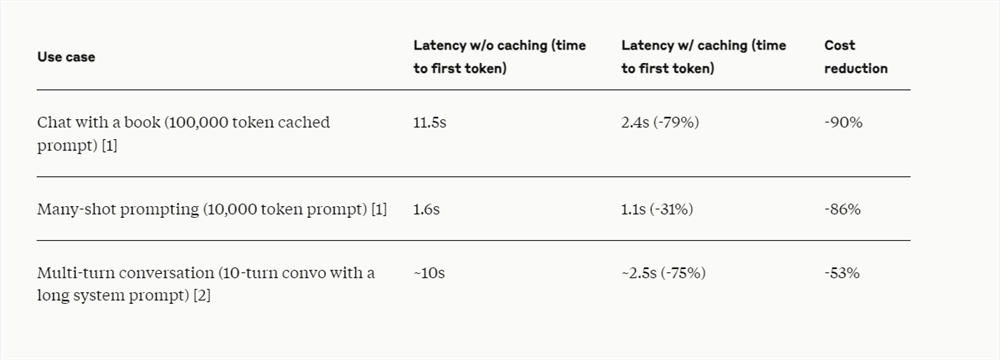

Anthropic API 近日推出了提示缓存功能,开发人员现在可以在API调用之间缓存常用的上下文信息。通过提示缓存,客户能够为Claude模型提供更多的背景知识和示例输出,同时显着降低长提示的成本,减少高达90%的费用,降低高达85%的延迟。

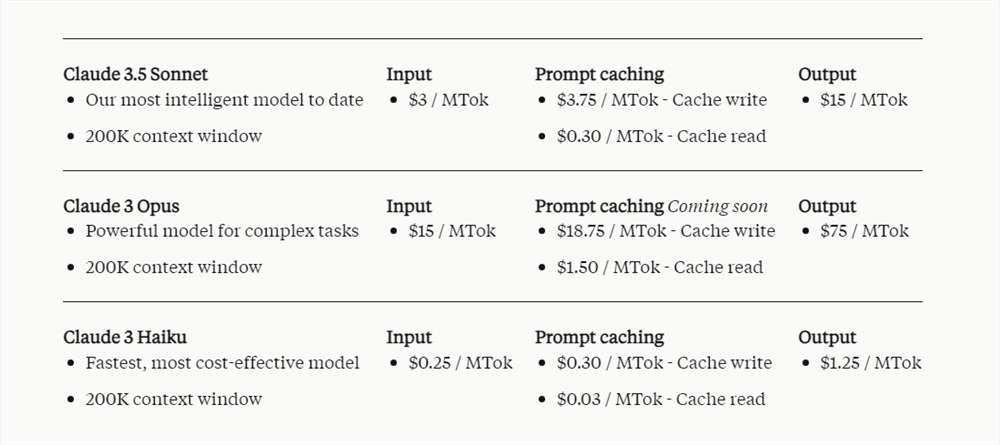

该功能目前已在Claude3.5Sonnet和Claude3Haiku的公开测试版中可用,未来还将支持Claude3Opus。

提示缓存功能特别适用于以下场景:当需要在多次请求中反复引用大量提示上下文时,如对话代理中减少长对话的成本和延迟,尤其是在包含复杂指令或文档上传的情况下;编码助手可以通过在提示中保留代码库的汇总版本来改进自动完成和代码库问答;处理大型文档时,提示缓存能够嵌入完整的长篇材料而不会增加响应时间;此外,对于涉及多轮工具调用和迭代更改的代理搜索和工具使用场景,提示缓存也能显着提升性能。

提示缓存的定价取决于缓存的输入令牌数量以及使用频率。写入缓存的成本比基本输入令牌价格高出25%,而使用缓存内容的成本则大幅降低,仅为基本输入令牌价格的10%。

据悉,Notion 作为Anthropic API的客户,已将提示缓存功能集成到其人工智能助手Notion AI中。通过降低成本和提高速度,Notion优化了内部运营,并为用户带来了更高级、更快速的体验。

提示缓存功能的推出,体现了Anthropic致力于优化Claude模型性能和降低用户成本的努力,为开发者提供了更经济高效的AI解决方案,进一步提升了Claude模型在各种应用场景下的实用性。 Notion的成功案例也证明了该功能的实际价值。