如果让AI用自己生成的图像进行再训练,结果会怎样?最近,斯坦福大学和加州大学伯克利分校的研究人员们就做了这样一个实验,结果让人大跌眼镜。

研究人员们发现,当AI图像生成模型被重新训练,使用它们自己生成的图像时,这些模型会产生高度扭曲的图像。更糟糕的是,这种扭曲不仅限于用于再训练的文本提示,一旦模型被“污染”,即使之后只用真实图像进行再训练,模型也很难完全恢复。

实验的起点是一个名为Stable Diffusion(SD)的开源模型。研究人员们首先从FFHQ人脸数据集中选取了70,000张高质量的人脸图像,并自动分类。然后,他们使用这些真实图像作为输入,通过Stable Diffusion模型生成了900张与特定人群特征一致的图像。

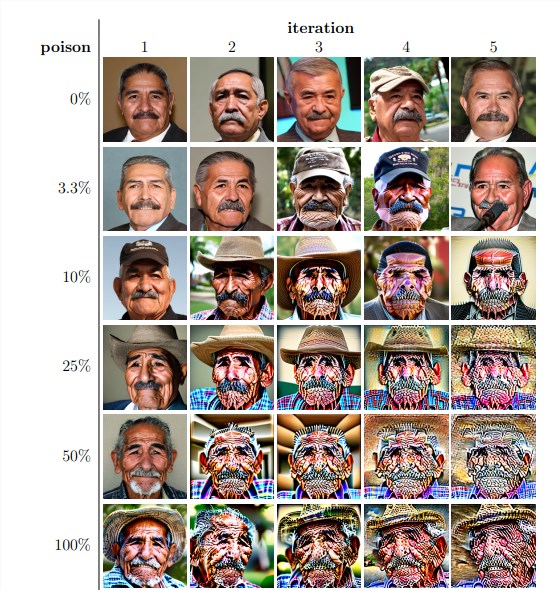

接下来,研究人员们将这些生成的图像用于模型的迭代再训练。他们发现,不管再训练数据集中自生成图像的比例如何,模型最终都会崩溃,生成的图像质量急剧下降。即使是在再训练数据中只包含3%自生成图像的情况下,模型崩溃的现象依然存在。

实验结果显示,基线版本的Stable Diffusion模型生成的图像与文本提示一致,且视觉质量高。但当模型经过迭代再训练后,生成的图像开始出现语义上的不一致和视觉扭曲。研究人员们还发现,模型崩溃不仅影响图像质量,还导致生成的图像缺乏多样性。

为了验证这一点,研究人员们还进行了控制实验,尝试通过调整生成图像的颜色直方图和移除低质量图像来减轻模型崩溃的影响。但结果表明,这些措施并不能有效阻止模型崩溃。

研究人员们还探讨了模型在被“污染”后是否有可能通过再训练恢复。他们发现,尽管在某些情况下,经过多次迭代再训练后,生成的图像质量有所恢复,但模型崩溃的迹象依然存在。这表明,一旦模型被“污染”,其影响可能是长期的,甚至是不可逆的。

这项研究揭示了一个重要的问题:当前流行的基于扩散的文本到图像生成AI系统对数据“污染”非常敏感。这种“污染”可能无意中发生,比如通过不加选择地从在线资源抓取图像。也可能是有针对性的攻击,比如故意在网站上放置被“污染”的数据。

面对这些挑战,研究人员们提出了一些可能的解决方案,比如使用图像真实性检测器来排除AI生成的图像,或者在生成的图像中加入水印。这些方法虽然不完美,但结合起来可能会显著降低数据“污染”的风险。

这项研究提醒我们,AI技术的发展并非没有风险。我们需要更加谨慎地处理AI生成的内容,确保它们不会对我们的模型和数据集造成长期的负面影响。未来的研究需要进一步探索如何使AI系统对这种类型的数据“污染”更具韧性,或者开发出能够加速模型“治愈”的技术。