格灵深瞳最新开源的RWKV-CLIP模型,凭借其融合Transformer和RNN架构的创新设计,在视觉语言表征学习领域展现出强大的性能。该模型通过巧妙地结合双塔架构、空间混合和通道混合模块以及多样化的描述生成框架,有效解决了噪声数据问题,并显着提升了模型的鲁棒性和下游任务表现。其在图像文本匹配和理解方面取得突破性进展,为视觉语言模型的研究和应用提供了新的方向。

格灵深瞳开源了RWKV-CLIP模型,这是一个结合了Transformer和RNN优点的视觉语言表征学习器。该模型通过图文预训练任务,使用从网站获取的图像-文本对扩展数据集,显着提高了视觉和语言任务的性能。

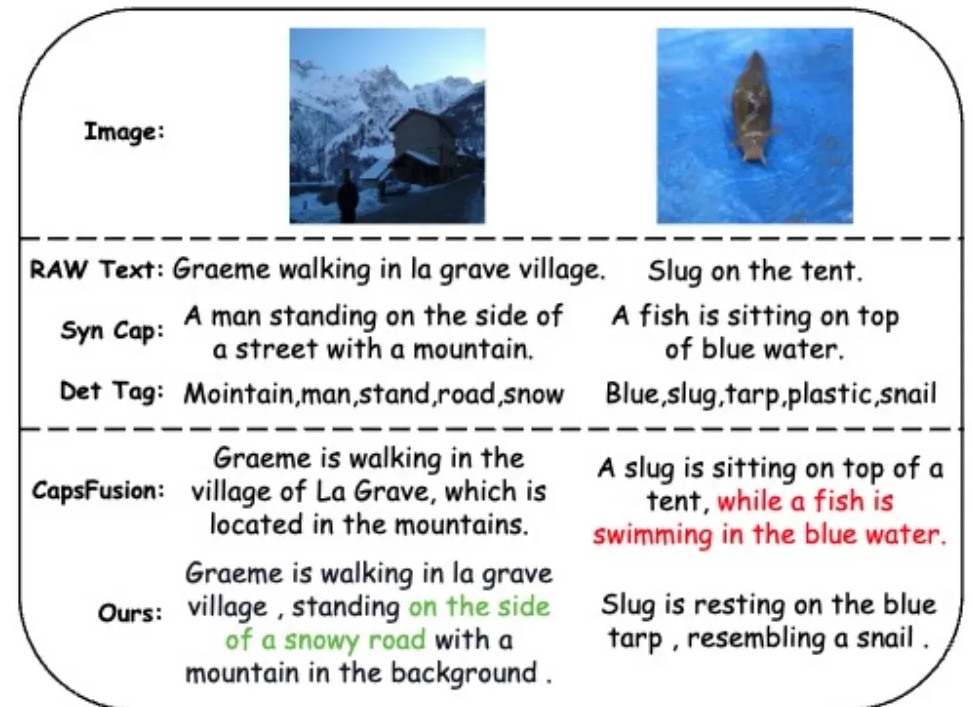

为了解决噪声数据问题并提高数据质量,研究团队引入了一个多样化的描述生成框架,利用大型语言模型(LLM)从基于网络的文本、合成字幕和检测标签中合成和细化内容。

RWKV-CLIP模型采用双塔架构,融合了Transformer的有效并行训练和RNN的高效推理。模型由多个空间混合和通道混合模块堆叠而成,通过这些模块实现对输入图像和文本的深入处理。在空间混合阶段,模型利用注意力机制进行全局的线性复杂度计算,强化特征在通道层级的交互。通道混合阶段进一步细化特征表示。 RWKV-CLIP模型在输入增强方面,通过随机选择原始文本、合成字幕或生成描述作为文本输入,增强了模型的鲁棒性。

实验结果表明,RWKV-CLIP在多个下游任务中取得了最先进的性能,包括线性探测、零样本分类和零样本图像文本检索。与基线模型相比,RWKV-CLIP实现了显着的性能提升。

RWKV-CLIP模型的跨模态分析显示,其学习到的表示在同一模态中表现出更清晰的可辨别性,并且在图像-文本模态空间中表现出更近的距离,表明跨模态对齐性能更出色。

模型地址: https://wisemodel.cn/models/deepglint/RWKV-CLIP

总而言之,RWKV-CLIP模型在视觉语言领域展现出极大的潜力,其开源也为相关研究提供了宝贵的资源。 感兴趣的开发者可以访问提供的链接下载模型并进行进一步研究和应用。