北京智源人工智能研究院(BAAI)发布了一款突破性的3D生成模型See3D,该模型利用海量无标注互联网视频进行学习,实现了从视频到3D模型的生成,标志着“See Video,Get 3D”理念的重大进展。See3D模型无需依赖传统的相机参数和3D标注,通过视觉条件技术,仅利用视频中的视觉线索即可生成相机方向可控、几何一致的多视角图像,极大降低了3D数据获取的成本和难度,为3D生成技术带来了新的可能性。

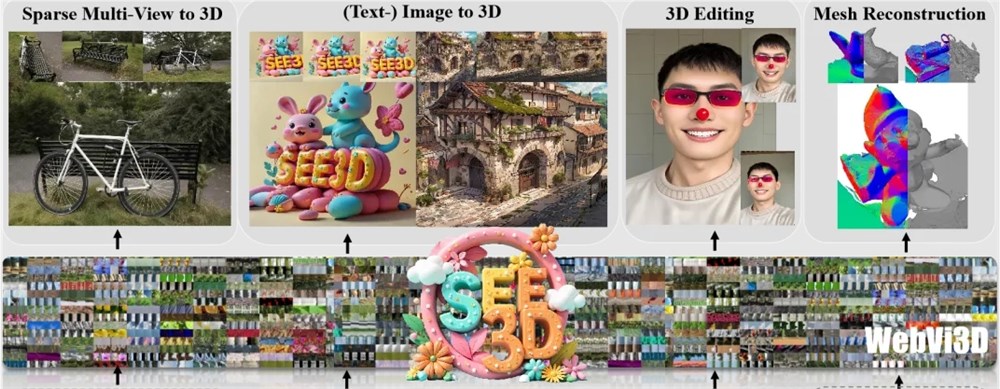

See3D模型支持从文本、单视图和稀疏视图生成3D模型,并具备3D编辑和高斯渲染功能。该模型、代码和Demo已开源,方便研究者深入学习和应用。See3D的应用场景广泛,包括解锁3D互动世界、基于稀疏图片的3D重建、开放世界3D生成以及基于单视图的3D生成等。其核心优势在于数据扩展性、相机可控性和几何一致性,通过构建包含1600万视频片段、3.2亿帧图像的WebVi3D数据集,实现了3D生成技术的显著提升。

研究团队通过自动筛选视频数据,构建了大规模WebVi3D数据集,并通过向掩码视频数据添加时间依赖噪声,生成纯粹的2D视觉信号,支持可扩展的多视图扩散模型训练,最终实现了无需相机条件的3D生成。See3D的出现为3D生成领域带来了新的思路,有望推动大规模无相机标注数据在3D研究中的应用,降低3D数据采集成本,缩小与现有闭源3D解决方案的差距。

See3D的优势在于其数据扩展性、相机可控性和几何一致性,能够在任意复杂的相机轨迹下生成场景,并保持前后帧视图的几何一致性。这使得See3D在各种3D创作应用中具有广泛的适用性。

通过扩大数据集规模,See3D为3D生成技术的发展提供了新的思路,希望这项工作能够促进3D研究社区对大规模无相机标注数据的关注,降低3D数据采集的成本,并缩小与现有闭源3D解决方案之间的差距。

项目地址:https://vision.baai.ac.cn/see3d

总而言之,See3D模型的开源发布,为3D生成领域带来了新的技术突破和发展方向,其高效、便捷的特性将为更多应用场景带来革新,值得期待其在未来能够取得更大的发展和应用。