ARC-AGI,一个旨在评估通用人工智能(AGI)抽象和推理能力的基准测试,近期取得进展,但其创造者弗朗索瓦·肖莱却提醒我们,这并不意味着AGI的临近。他指出,当前AI系统在ARC-AGI测试中的表现仍然远低于预期,大型语言模型(LLM)的局限性是主要原因,它们更擅长模式识别而非真正的推理。肖莱和合作者发起了一百万美元的竞赛,以推动开源AI在ARC-AGI上的突破,但结果也印证了测试本身可能存在不足之处,需要进一步改进。

自2019年推出以来,ARC-AGI一直是人工智能领域关注的焦点。尽管AI系统在测试中取得了一些进步,但其得分仍然远低于人类水平。这引发了对当前AI发展方向的反思,也促使研究人员重新审视AGI的定义和评估方法。文章详细分析了ARC-AGI测试的局限性,以及对未来AGI研究方向的展望,并展示了相关竞赛结果以及研究人员的应对策略。

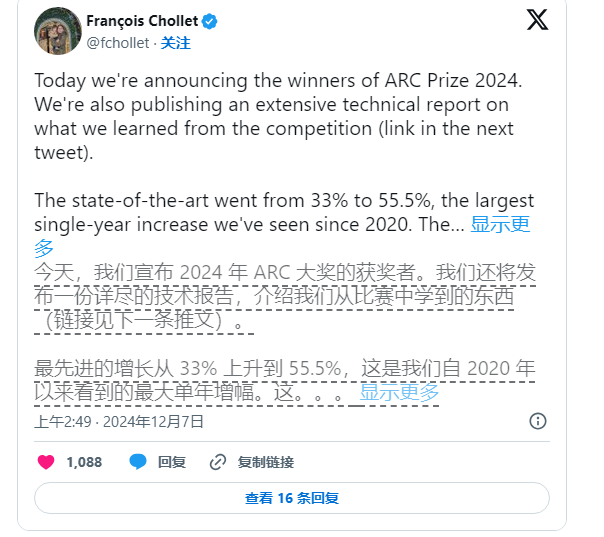

尽管如此,肖莱并未停止推动AI研究。他和Zapier创始人Mike Knoop于今年6月联合发起了一项100万美元的竞赛,鼓励开源AI挑战ARC-AGI基准。尽管在17,789份参赛作品中,表现最好的AI系统仅得到了55.5%的分数,低于实现“人类水平”所需的85%标准,但肖莱和Knoop仍认为这是向前迈出的重要一步。

Knoop在博客文章中指出,这一成绩并不意味着我们离实现AGI更近,反而凸显了ARC-AGI中部分任务过于依赖“蛮力”解决方案,未必能为真正的通用智能提供有效信号。ARC-AGI的设计本意是通过提供复杂、从未见过的任务来测试AI的泛化能力,然而,这些任务能否有效评估AGI仍然存疑。

图源备注:图片由AI生成,图片授权服务商Midjourney

ARC-AGI基准中的任务涉及如拼图问题等,要求AI根据已知信息推测出未知答案。尽管这些任务看似能推动AI对新情境的适应,但结果表明,现有模型似乎通过大量计算找到了解决方案,而未必展现出真正的智能适应能力。

此外,ARC-AGI的创建者也面临来自同行的批评,特别是在AGI定义方面的模糊性。OpenAI的一位员工最近表示,如果将AGI定义为“在大多数任务上比大多数人类表现更好”的人工智能,那么AGI实际上已经实现。然而,肖莱和Knoop则认为,ARC-AGI基准的现有设计尚未完全实现这一目标。

展望未来,肖莱和Knoop计划发布第二代ARC-AGI基准,并将在2025年举行新的竞赛,以解决当前测试中的不足。他们表示,新的基准将更加聚焦于推动AI研究向更加重要的方向发展,加速AGI的实现进程。

然而,修复现有基准并非易事。肖莱和Knoop的努力表明,定义人工智能的智能,尤其是在通用智能领域,仍然是一项艰巨而复杂的任务。

总而言之,ARC-AGI基准测试的进展及相关讨论,反映了人工智能领域对通用人工智能的探索仍在持续进行中,既有突破,也有挑战,未来需要更严格的定义和更有效的评估方法来推动AGI的真正发展。