NVIDIA最新发布的开放视觉语言模型NVILA,在准确性和效率方面取得了显着突破,成为视觉AI领域的又一里程碑。相比于其他大型视觉模型,NVILA在训练成本、内存占用和延迟方面均实现了大幅降低,其在多个基准测试中也展现出优异的性能,甚至超越了部分竞争对手。文章详细介绍了NVILA的技术细节,包括“先扩展后压缩”技术以及动态S2扩展、基于DeltaLoss的数据集修剪等优化策略,旨在平衡模型的准确性和效率。 这标志着视觉语言模型技术朝着更经济、更高效的方向发展。

近日,NVIDIA 推出了新一代开放视觉语言模型——NVILA。该旨在优化准确性和效率,凭借出色的性能,成为视觉AI 领域的佼者。

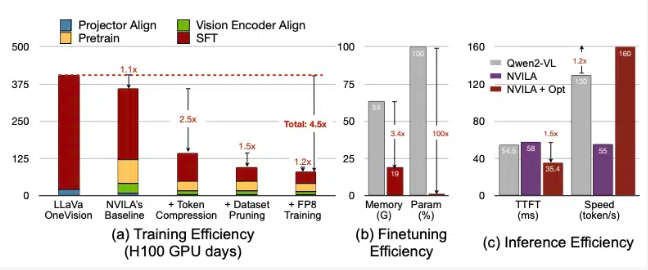

根据NVIDIA 的介绍,NVILA 在训练成本上降低了4.5倍微调所需内存减少了3.4倍,并且在预填充和解码的延迟上几乎降低了2倍。这些数据是与另一种大型视觉模型LLaVa OneVision 进行比较得出的。

在视频基准测试中,NVILA 的表现超过了GPT4o Mini,并且在与GPT4o、Sonnet3.5和Gemini1.5Pro 的比较中也表现出色。此外,NVILA 还在与Llama3.2的对比中取得了微弱胜利。尽管如此,NVIDIA 表示,目前尚未将该模型发布到Hugging Face 平台上,他们承诺会很快发布代码和模型,以促进模型的可复现性。

NVIDIA 指出,训练视觉语言模型的成本非常高,训练一个7B 参数的视觉语言模型大约需要400个GPU 天。同时,微调这样的模型也非常耗费内存,7B 参数的模型需要超过64GB 的GPU 内存。

因此,NVIDIA 采用了一种名为“先扩展后压缩” 的技术,旨在平衡模型的准确性与效率。该模型并不通过降低照片和视频的大小来化输入,而是使用高分辨率像和视频中的多个帧,以确保不丢失任何细节。

在压缩过程中,模型通过将视觉信息压缩为更少的token,来减少输入数据的大小,并将像素进行分组,以保留重要信息。 NVIDIA 在论文中提到,双倍分辨率将使视觉token 数量翻倍,这将使训练和推理成本增加超过2倍。因此,他们通过压缩空间/ 时间token 降低这部分成本。

NVIDIA 还展示些模型的演示效果,NVILA 能够根据一张图片或一段视频回答多个查询。它的输出结果还与NVIDIA 之前发布的VILA1.5模型进行了对比。此外,NVIDIA 还详细介绍了一些其他技术,例如动态S2扩展、基于DeltaLoss 的数据集修剪、使用FP8精度进行量化等。

这些技术均应用于一个8B 参数的模型,具体细节可以在Arxiv 上查看。

论文入口:https://arxiv.org/pdf/2412.04468

划重点:

? NVILA 模型在训练成本上降低了4.5倍,提升了视觉AI 的效率。

? 通过高分辨率图像和视频帧,NVILA 确保了输入信息的完整性。

? NVIDIA 承诺将很快发布代码与模型,促进研究的可复现性。

总而言之,NVILA 的出现为视觉语言模型的发展带来了新的可能性,其高效的训练和推理过程将降低视觉AI 应用的门槛,推动该领域进一步发展。期待NVIDIA早日公开代码和模型,让更多研究者能够参与其中,共同推进视觉AI技术的进步。