Epoch AI近日发布了一款大型语言模型训练计算能力模拟器,该模拟器通过模拟不同硬件条件下训练GPT-4的成本和效率,为研究人员提供了宝贵的参考。模拟结果显示,即使使用2012年的老旧显卡GTX580也能训练GPT-4,但成本将是现代硬件的十倍,这凸显了硬件性能提升对AI模型训练的重要性。该模拟器还支持多数据中心训练模拟,允许用户自定义参数,分析不同硬件和训练策略的性能差异,为未来大型AI模型的训练提供了重要的决策依据。

最近,人工智能研究公司 Epoch AI 发布了一款互动模拟器,专门用于模拟训练大型语言模型所需的计算能力。通过这款模拟器,研究人员发现,虽然可以使用2012年的老旧显卡(如 GTX580)来训练 GPT-4,但成本将是如今现代硬件的十倍。

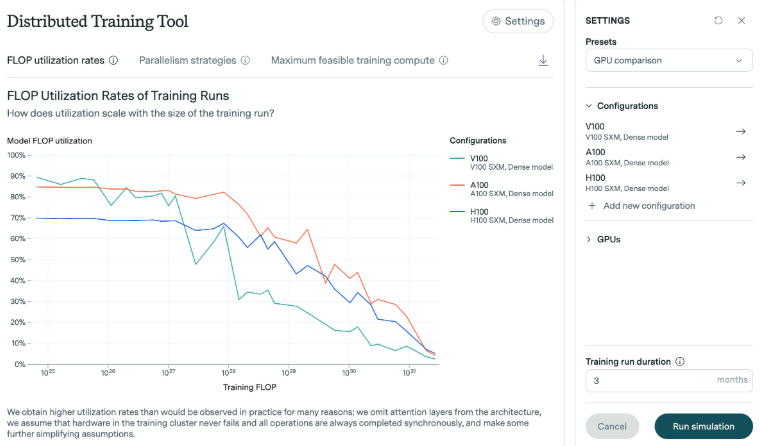

Epoch AI 的研究显示,训练 GPT-4所需的浮点运算次数(FLOP)在1e25到1e26之间。为了进行这项研究,模拟器分析了不同显卡的效率,特别是在模型规模扩大时的表现。结果表明,随着模型的增长,效率通常会降低。以近年来推出的 H100显卡为例,它能在较长时间内保持较高的效率,而 V100显卡则在面对更大训练规模时效率下降得更加明显。

在 Epoch AI 的实验中,GTX580显卡的内存仅为3GB。这款显卡曾是2012年训练 AlexNet 模型时的主流选择。尽管技术已经进步,但研究人员认为,使用老旧硬件进行如此大规模的训练是可能的,不过所需的资源和成本却非常高。

此外,这款模拟器还支持在多个数据中心之间进行复杂的训练模拟。用户可以自定义数据中心的规模、延迟和连接带宽等参数,从而模拟跨多个位置的训练运行。这一工具还允许分析现代显卡(如 H100和 A100)之间的性能差异,研究不同批量大小和多 GPU 训练的效果,并生成详细的日志文件记录模型的输出。

Epoch AI 表示,开发这个模拟器的目的是为了加深对硬件效率提升的理解,并评估芯片出口管制的影响。随着大型训练任务在本世纪的预期增加,了解未来所需的硬件要求变得尤为重要。

总而言之,Epoch AI 的这项研究和模拟器为大型语言模型的训练提供了重要的参考价值,有助于研究人员更好地理解硬件效率、优化训练策略,并为未来AI模型的训练提供更可靠的预测。