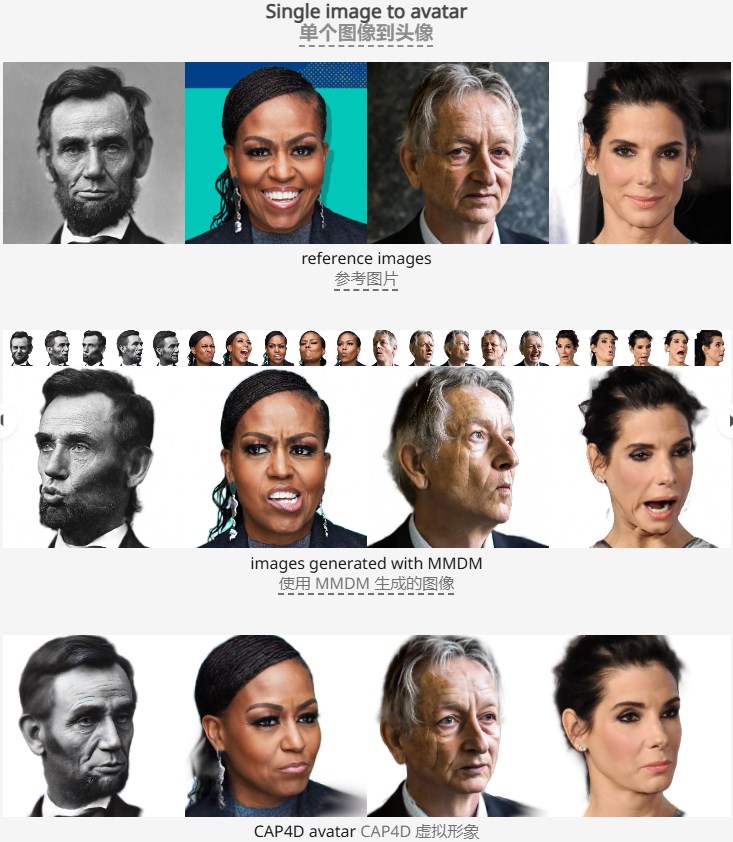

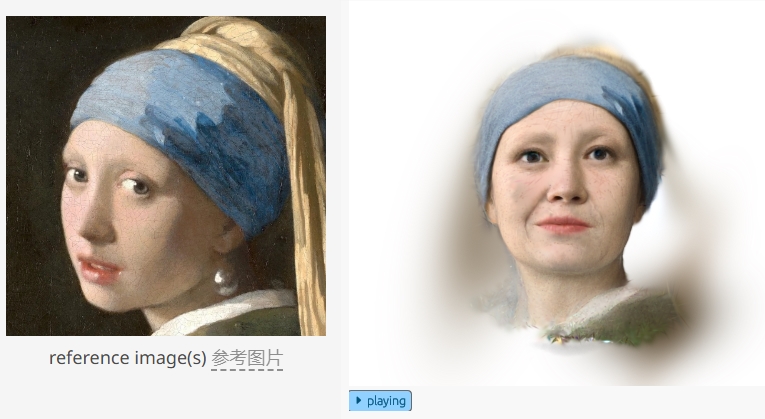

多伦多大学及向量研究所的研究团队最新发布了CAP4D模型,这是一项突破性的4D头像生成技术。它基于形变多视角扩散模型(MMDM),能够通过任意数量的参考图像生成逼真的、可实时控制的4D头像,显着提升了头像重建效果和细节呈现。这项技术不仅可以处理单张或少量参考图像,甚至可以从文本提示或艺术作品中生成头像,展现了其强大的适应性和生成能力。其双阶段方法首先利用MMDM生成不同视角和表情的图像,然后结合参考图像重建4D头像,并支持与现有图像编辑模型和语音驱动动画模型结合,实现更丰富的交互和动态效果,为虚拟头像应用开辟了新的可能性。

该模型采用双阶段方法,首先利用MMDM 生成不同视角和表情的图像,然后将这些生成的图像与参考图像结合,重建出一个可实时控制的4D 头像。用户可以输入任意数量的参考图像,模型会利用这些图像信息生成高质量的4D头像,并支持与语音驱动动画模型结合,实现音频驱动的动态效果。 CAP4D模型的出现,标志着4D头像生成技术取得了显着进展,其在虚拟现实、游戏以及元宇宙等领域具有广阔的应用前景。

该研究团队展示了CAP4D 生成的各种头像,涵盖了单张参考图像、少量参考图像和挑战性更大的从文本提示或艺术作品生成头像的场景。通过使用多张参考图像,模型能够恢复出单张图像中无法看到的细节与几何形状,从而提升了重建效果。此外,CAP4D 还具备与现有图像编辑模型相结合的能力,使得用户可以对生成的头像进行外观和光照的编辑。

为了进一步提升头像的表现力,CAP4D 能够将生成的4D 头像与语音驱动动画模型结合,实现音频驱动的动画效果。这使得头像不仅能够展现静态的视觉效果,还能通过声音与用户进行动态互动,开创了虚拟头像应用的新领域。

划重点:

CAP4D 模型能够通过任意数量的参考图像生成高质量的4D 头像,采用双阶段工作流程。

该技术可以生成多种不同视角的头像,显着提高了图像重建效果和细节呈现。

CAP4D 与语音驱动动画模型相结合,实现音频驱动的动态头像,拓展了虚拟头像的应用场景。

总而言之,CAP4D模型在4D头像生成领域取得了显着突破,其高效、逼真和多功能的特点为虚拟现实、数字娱乐等领域带来了新的可能性。 未来,该技术有望进一步发展,为用户提供更便捷、更逼真的虚拟互动体验。