谷歌近日发布了其最新多模态推理模型Gemini2.0 Flash Thinking,该模型号称是谷歌迄今为止最强大的模型,具备快速、透明的处理能力,能够高效解决复杂问题。 Gemini2.0 Flash Thinking 不仅支持大规模文本处理,还具备原生图像上传与分析功能,显着扩展了其应用场景。 其透明的推理过程,通过下拉菜单展示模型的逐步思考步骤,解决了AI “黑箱” 问题,为用户提供了更清晰的理解。本文将深入分析Gemini2.0 Flash Thinking 的主要特点、功能以及与其他模型的对比,揭示其在人工智能领域的重要意义。

在人工智能领域竞争日益激烈的背景下,谷歌近日宣布推出Gemini2.0Flash Thinking模型。这一多模态推理模型具备快速且透明的处理能力,能够应对复杂问题。谷歌首席执行官桑达尔・皮查伊在社交媒体X 上表示:“这是我们迄今为止最具深度的模型。”

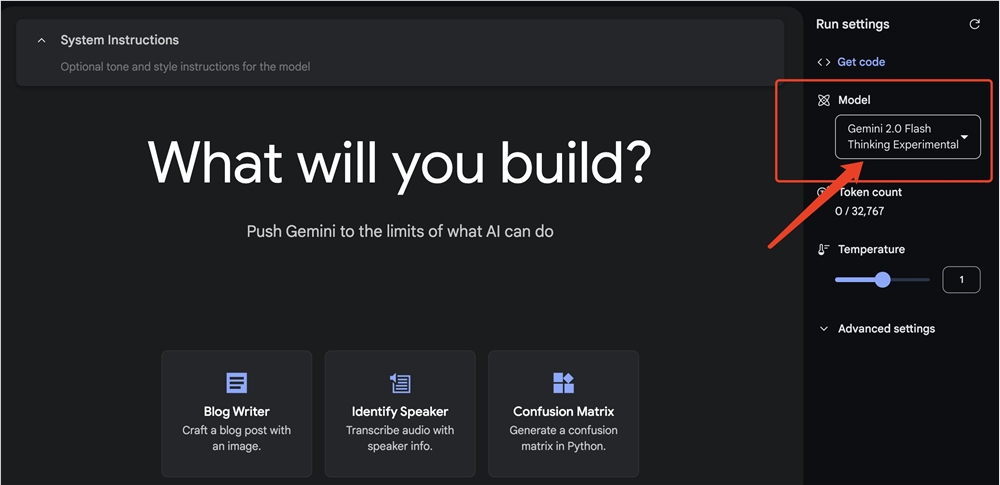

根据开发者文档,Gemini2的Flash Thinking比基础版本的Gemini2.0Flash模型具备更强的推理能力。新模型支持32,000个输入标记(大约50到60页文本),输出响应可以达到8,000个标记。谷歌在其AI 工作室的侧边面板中表示,这一模型特别适用于“多模态理解、推理” 以及“编码”。

开发者文档:https://ai.google.dev/gemini-api/docs/thinking-mode?hl=zh-cn

目前关于模型的训练过程、架构、许可和成本等详细信息尚未公布,但谷歌AI 工作室显示目前使用该模型每个标记的费用为零。

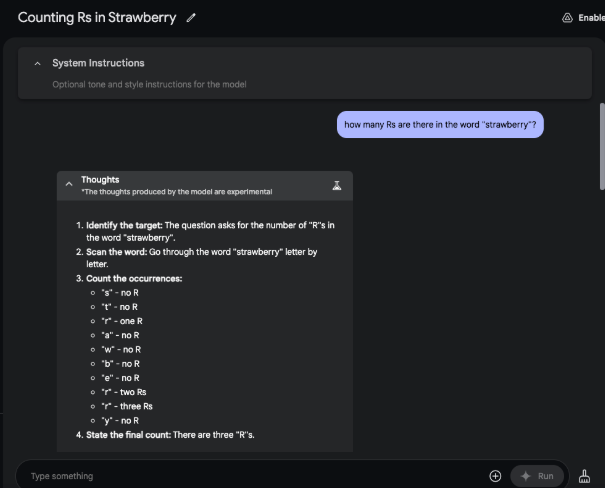

Gemini2.0的一个显着特点是允许用户通过下拉菜单访问模型的逐步推理过程,这在OpenAI 的o1和o1mini 等竞争模型中并不具备。这种透明的推理方式使得用户能够清楚了解模型得出结论的过程,有效解决了AI 被视为“黑箱” 的问题。

在一些简单测试中,Gemini2.0能够快速(在一到三秒内)正确回答一些复杂问题,例如计算“草莓” 这个词中字母“R” 的数量。在另一项测试中,模型通过逐步分析整体数字和小数位,系统地比较了两个小数(9.9与9.11)。

第三方独立分析机构LM Arena 将Gemini2.0Flash Thinking模型评为所有大语言模型类别中的最佳表现模型。

此外,Gemini2.0Flash Thinking模型还具备原生的图像上传与分析功能。相比于OpenAI 的o1,后者最初为文本模型,并在后续进行了图像和文件分析的扩展。当前,两者都只能返回文本输出。

虽然Gemini2.0Flash Thinking模型的多模态能力扩展了其潜在应用场景,但开发者需注意,该模型目前不支持与谷歌搜索的结合,也无法与其他谷歌应用及外部工具集成。通过Google AI Studio和Vertex AI,开发者可以对这一模型进行实验。

在日益竞争的AI 市场中,Gemini2.0Flash Thinking模型可能标志着问题解决模型的新纪元。凭借处理多种数据类型、提供可视化推理和大规模运作的能力,它在推理AI 市场中成为OpenAI o1系列及其他模型的重要竞争者。

划重点:

Gemini2.0Flash Thinking模型具备强大的推理能力,支持32,000个输入标记和8,000个输出标记。

该模型通过下拉菜单提供逐步推理,增强透明性,解决AI “黑箱” 问题。

具备原生图像上传与分析能力,扩展了多模态应用场景。

总而言之,Gemini2.0 Flash Thinking 模型凭借其强大的推理能力、透明的推理过程和多模态功能,在人工智能领域展现出强大的竞争力,为未来的AI 应用开辟了新的可能性。 但其目前的一些局限性,例如与谷歌其他服务的集成度等,也值得关注。