训练大型AI模型的成本高昂,其巨大的资源需求限制了其广泛应用,并引发了对能源效率和环境影响的担忧。传统的训练方法效率低下,依赖于稠密矩阵,需要大量的内存和计算能力。现有的一些方法虽然试图缓解这些问题,但在实际应用中仍然存在局限性。因此,开发一种能够同时降低内存使用、计算成本和训练时间,且不损害性能的方法至关重要。

训练大型AI模型(如Transformer和语言模型)已成为AI领域不可或缺的关键环节,但也面临着高昂的计算成本、内存消耗和能源需求。例如,OpenAI的GPT-3拥有1750亿个参数,需要数周的GPU训练。这种巨大的资源需求限制了这项技术在大规模计算资源充足的组织中的应用,同时也加剧了人们对能源效率和环境影响的担忧。解决这些挑战对于确保AI发展的更广泛可及性和可持续性至关重要。

传统训练方法效率低下,亟需创新解决方案

CoMERA框架:通过自适应张量优化实现高效训练

CoMERA的基础是自适应张量表示,它允许模型层根据资源约束动态调整其秩。通过修改张量秩,该框架可以在不损害神经网络操作完整性的情况下实现压缩。这种动态优化是通过一个两阶段的训练过程实现的:

早期阶段:专注于稳定收敛。

后期阶段:微调秩以满足特定的压缩目标。

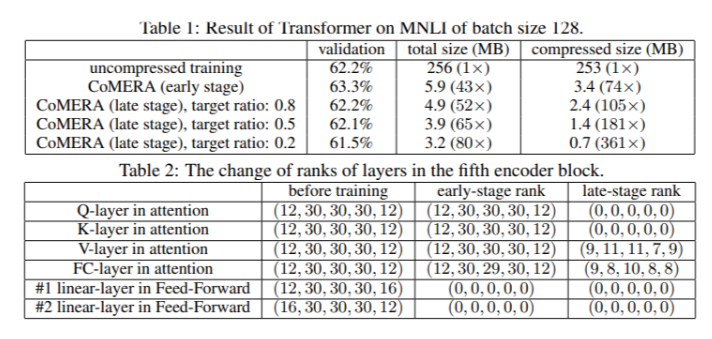

在一个六编码器Transformer模型中,CoMERA在其早期阶段实现了高达43倍的压缩比,而在其后期优化阶段,压缩比更是高达361倍。此外,与GaLore相比,它将内存消耗降低了9倍,每轮训练速度提高了2-3倍。

多项测试结果表明CoMERA性能卓越

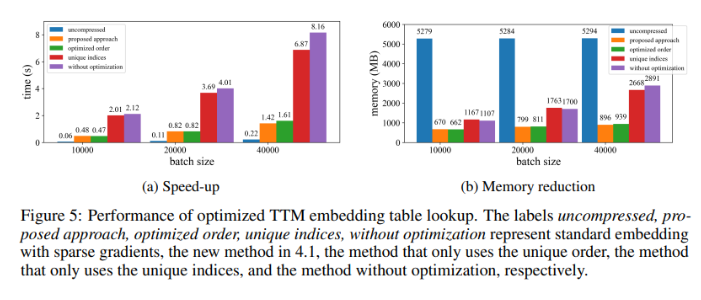

在应用于MNLI数据集上训练的Transformer模型时,CoMERA将模型大小从256MB缩小到低至3.2MB,同时保持了精度。在诸如DLRM的大规模推荐系统中,CoMERA将模型压缩了99倍,并使峰值内存使用量减少了7倍。该框架还在预训练CodeBERT(一个特定领域的大型语言模型)方面表现出色,获得了4.23倍的整体压缩比,并在某些训练阶段实现了2倍的加速。这些结果突显了其处理各种任务和架构的能力,扩展了其在各个领域的适用性。

CoMERA框架的关键优势总结

这项研究的主要结论如下:

CoMERA为特定层实现了高达361倍的压缩比,为整个模型实现了99倍的压缩比,大大降低了存储和内存需求。

该框架将Transformer和推荐系统的每轮训练时间缩短了2-3倍,节省了计算资源和时间。

通过使用张量化表示和CUDA图,CoMERA将峰值内存消耗减少了7倍,使得在较小的GPU上进行训练成为可能。

CoMERA的方法支持包括Transformer和大型语言模型在内的多种架构,同时保持或提高了精度。

通过降低训练所需的能源和资源,CoMERA有助于实现更可持续的AI实践,并使更广泛的受众能够使用尖端模型。

总而言之,CoMERA框架为高效训练大型AI模型提供了一种具有突破性的解决方案,它通过自适应张量优化,显著降低了计算成本和内存需求,同时保持了模型的精度。这项研究为AI领域的持续发展和更广泛的可及性做出了重要贡献。