昆仑万维颜水成团队与新加坡南洋理工大学合作,发布了一项名为Q*的突破性项目,旨在显着提升小语言模型的推理能力。不同于市面上其他大型语言模型,Q*专注于增强小模型的性能,使其推理能力能够媲美参数量大数十倍甚至上百倍的模型。这项研究成果有望改变小模型在实际应用中的局限性,为人工智能领域带来新的发展机遇。通过创新的算法,Q*实现了对小模型推理能力的显着提升,并在多个基准测试中取得了超越大型模型的优异成绩。

近日,来自国内昆仑万维颜水成团队与新加坡南洋理工大学的研究团队发布了一项名为Q * 的项目,旨在提升小模型的推理能力。这一项目不同于OpenAI,却能让小模型达到参数量比其大数十倍、甚至上百倍模型的推理能力。

该研究团队通过Q * 算法的实验表现,取得了显着的成果:在GSM8K 数据集上,Q * 帮助Llama-2-7b 提升至80.8% 的准确率,超越了ChatGPT。

在MATH 数据集上,Q * 帮助DeepSeek-Math-7b 提升至55.4% 的准确率,超越了Gemini Ultra。

在MBPP 数据集上,Q * 帮助CodeQwen1.5-7b-Chat 提升至77.0% 的准确率,缩小了与GPT-4的编程水平差距。这些成果显示出Q * 算法在提升小模型推理能力方面的潜力。

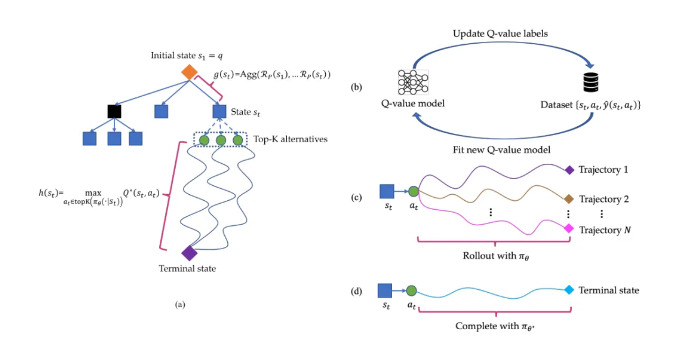

Q * 算法的工作原理是通过将大语言模型的推理轨迹分解为若干个状态,对每一个状态进行全盘规划,利用A * 搜索算法实现了复杂推理任务的优先搜索。同时,他们还通过监督学习的方式训练了一个代理Q 值模型,以获得状态- 动作对的最优Q 值,从而提升模型的性能。

划重点:

Q * 项目非OpenAI 发布,通过研究团队的算法,小模型的推理能力得到大幅提升。

该项目在多个数据集上取得了显着的实验成果,证明了Q * 算法的潜力和有效性。

论文链接:https://arxiv.org/abs/2406.14283

Q*项目的研究成果为小模型的发展提供了新的方向,其高效的算法和显着的提升效果值得关注。未来,该算法有望在更多领域得到应用,推动人工智能技术的进步。论文链接已提供,感兴趣的读者可以进一步了解详情。