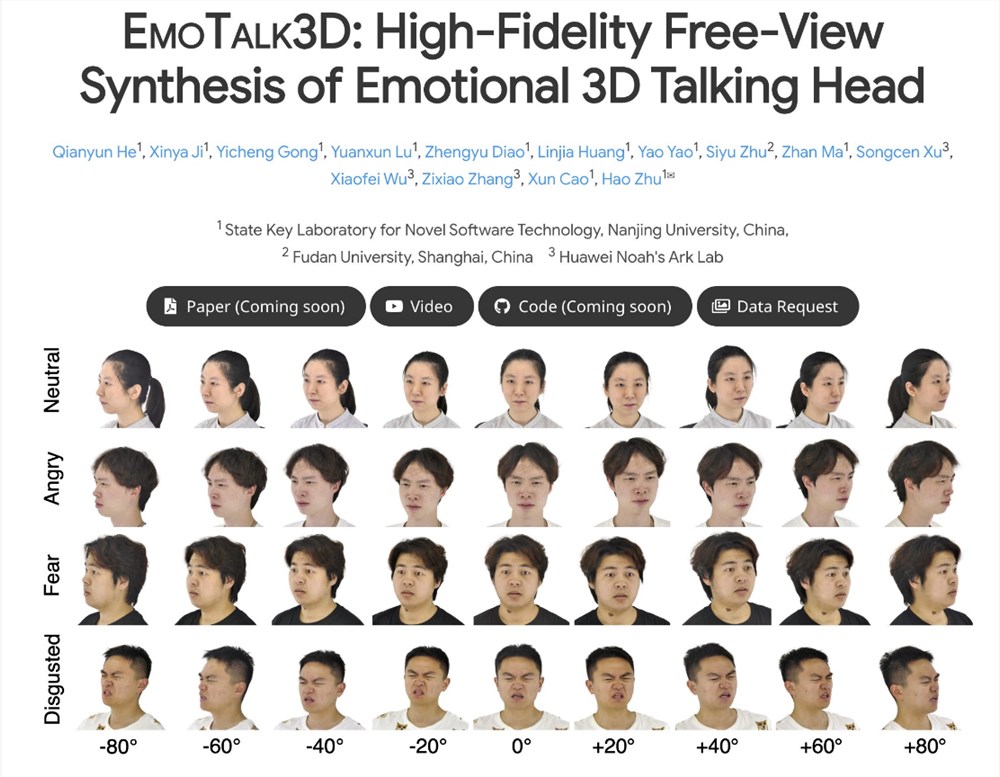

EmoTalk3D项目在人工智能领域取得了突破性进展,其核心在于成功合成高保真度、情感丰富的3D说话头像。该项目通过构建一个包含多视图视频、情感标注和3D几何图形的全新数据集EmoTalk3D,并研发了一种创新的“语音到几何到外观”映射框架,解决了现有技术在多视图一致性和情感表达方面的不足。该框架能够精准预测3D几何序列,并基于4D高斯表示合成3D头像外观,最终实现自由视图的说话头像动画,甚至连细微表情和皱纹都能够逼真地呈现。

据了解,EmoTalk3D项目的研究团队针对当前3D说话头像技术在多视图一致性和情感表达方面的不足,提出了一种全新的合成方法。该方法不仅具有增强的唇部同步和渲染质量,还能在生成的说话头像中实现可控的情绪表达。

研究团队设计了一个“语音到几何到外观”的映射框架。该框架首先从音频特征中预测出忠实的3D几何序列,然后基于这些几何图形合成由4D高斯表示的3D说话头像的外观。这一过程中,外观被进一步分解为规范和动态高斯分量,通过从多视图视频中的学习,二者得以融合,从而渲染出自由视图的说话头像动画。

值得一提的是,EmoTalk3D项目的研究团队还成功解决了先前方法在捕捉动态面部细节方面的难题,如皱纹和细微表情的呈现。实验结果表明,该方法在生成高保真和情绪可控的3D说话头像方面具有显著优势,同时在唇部运动生成中展现出了更好的渲染质量和稳定性。

目前,EmoTalk3D项目的代码和数据集已在指定的HTTPS URL上发布,供全球的研究人员和开发者们参考和使用。这一创新性的技术突破无疑将为3D说话头像领域的发展注入新的活力,并有望在未来应用于虚拟现实、增强现实、影视制作等多个领域。

EmoTalk3D项目的成功,为3D数字人物的制作带来了新的可能性,其高保真、情感化的3D头像技术,将为虚拟现实、增强现实以及影视制作等领域带来革命性的变革。未来,我们可以期待更多基于EmoTalk3D技术的产品和应用出现,为人们带来更沉浸式的体验。