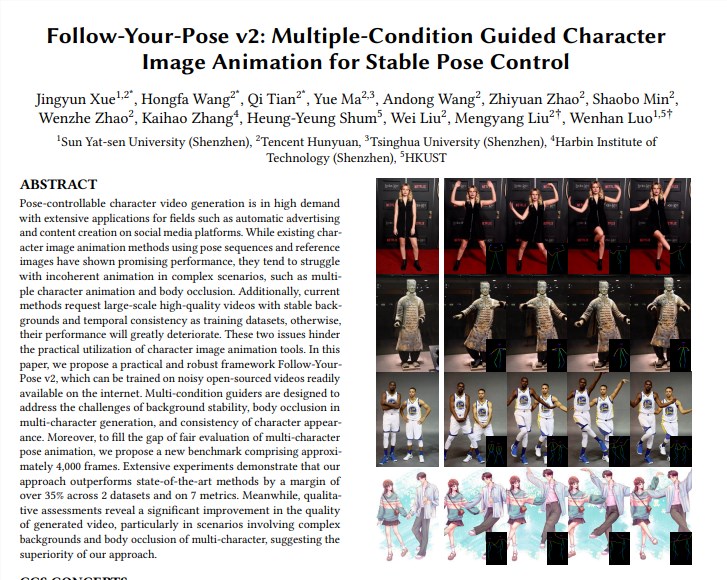

腾讯混元团队携手中山大学和香港科技大学,重磅推出全新图生视频模型“Follow-Your-Pose-v2”,实现了视频生成技术从单人到多人的突破性进展。该模型能够处理多人合照,让照片中的人物同时在生成的视频中动起来,显着提升了视频生成的效率和质量。其技术亮点在于支持多人视频动作生成、拥有强大的泛化能力、可使用日常生活照/视频进行训练和生成,并能正确处理人物遮挡等问题。该模型在多个数据集上的表现均优于现有技术,展现了其强大的性能和广泛的应用前景。

支持多人视频动作生成:在推理耗时更少的情况下,实现多人视频动作的生成。

强泛化能力:无论年龄、服装、人种、背景杂乱程度或动作复杂性如何,都能生成高质量视频。

日常生活照/视频可用:模型训练及生成可以使用日常生活照(包括抓拍)或视频,无需寻找高质量图片/视频。

正确处理人物遮挡:面对单张图片上多个人物躯体相互遮挡的问题,能生成具有正确前后关系的遮挡画面。

技术实现方面:

模型利用"光流指导器"引入背景光流信息,即使在相机抖动或背景不稳定的情况下,也能生成稳定背景动画。

通过"推理图指导器"和"深度图指导器",模型能更好地理解图片中的人物空间信息和多角色的空间位置关系,有效解决多角色动画和身体遮挡问题。

评估与比较:

团队提出了一个新的基准Multi-Character,包含约4000 帧多角色视频,用以评估多角色生成效果。

实验结果显示,"Follow-Your-Pose-v2"在两个公共数据集(TikTok和TED演讲)和7 个指标上的性能均优于最新技术35%以上。

应用前景:

图像到视频生成技术在电影内容制作、增强现实、游戏制作及广告等多个行业有着广泛的应用前景,是2024 年备受关注的AI技术之一。

其他信息:

腾讯混元团队还公布了文生图开源大模型(混元DiT)的加速库,大幅提升推理效率,生图时间缩短75%。

混元DiT模型的使用门槛降低,用户可以在Hugging Face的官方模型库中用三行代码调用模型。

论文地址:https://arxiv.org/pdf/2406.03035

项目页:https://top.aibase.com/tool/follow-your-pose

“Follow-Your-Pose-v2”模型的出现,标志着图生视频技术取得了重大突破,其在多个领域的应用前景值得期待。未来,随着技术的不断发展和完善,相信该模型将在更多场景中发挥重要作用,为人们带来更便捷、更智能的视频生成体验。