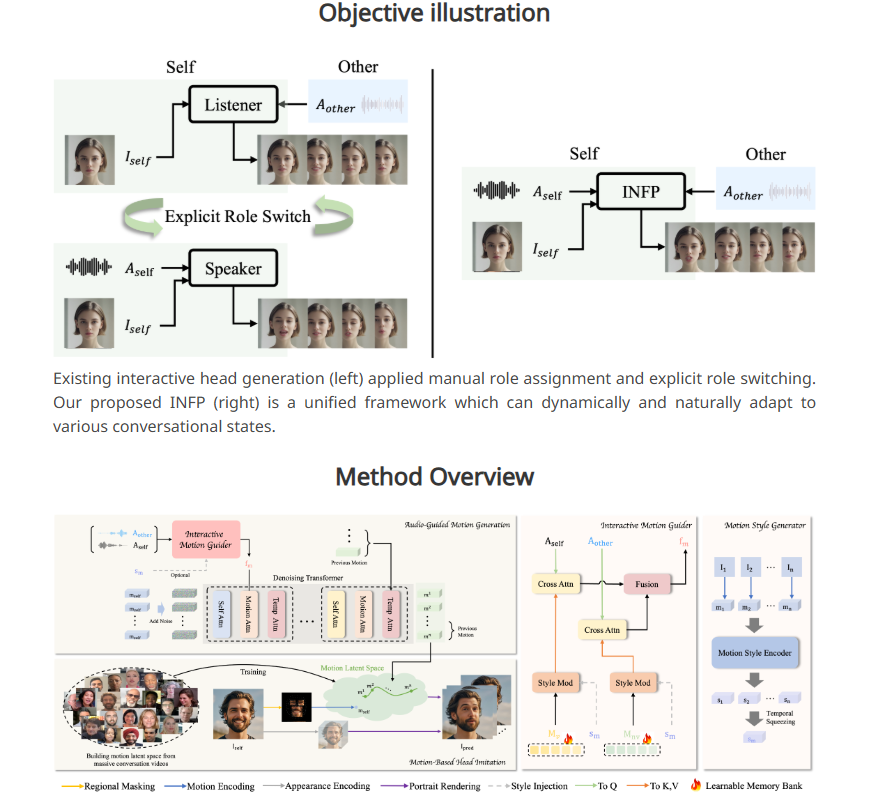

字节跳动推出全新AI系统INFP,该系统能够使静态人物肖像照片通过音频输入“说话”并做出反应。不同于传统技术,INFP无需手动指定角色,系统可根据对话自动判断,极大提升了效率和便捷性。其核心技术在于“基于运动的头部模仿”和“音频引导运动生成”两个步骤,通过分析对话中的面部表情、头部运动和音频输入,生成自然流畅的运动模式,使静态图像栩栩如生。为了训练INFP,字节跳动还构建了包含200多小时真实对话视频的DyConv数据集,确保系统的高质量输出。

INFP 的工作流程分为两个主要步骤。第一步,称为 “基于运动的头部模仿”,该系统通过分析人们在对话中的面部表情和头部运动,从视频中提取细节。这些运动数据会被转化为可以用于后续动画的格式,使静态照片能够与原始人物的运动相匹配。

第二步是 “音频引导运动生成”,系统则根据音频输入生成自然的运动模式。研究团队开发了一种 “运动引导器”,该工具通过分析对话双方的音频,创建出说话和倾听的运动模式。随后,名为扩散变换器的 AI 组件对这些模式进行逐步优化,从而生成流畅且真实的运动,完美契合音频内容。

为了对系统进行有效训练,研究团队还建立了一个名为 DyConv 的对话数据集,汇集了200多个小时的真实对话视频。与现有的对话数据库(如 ViCo 和 RealTalk)相比,DyConv 在情感表达和视频质量方面具有独特优势。

字节跳动表示,INFP 在多个关键领域的表现优于现有工具,特别是在与语音匹配的唇部运动、保留个体面部特征以及创造多样化自然动作方面。此外,该系统在生成仅听对话者的视频时同样表现出色。

虽然目前 INFP 仅支持音频输入,研究团队正在探索将系统扩展到图像和文本的可能性,未来目标是能够创建出人物全身的真实动画。然而,考虑到这类技术可能被用于制造虚假视频和传播错误信息,研究团队计划将核心技术限制在研究机构使用,类似于微软对其先进语音克隆系统的管理。

这项技术是字节跳动更广泛 AI 战略的一部分,依托其旗下的热门应用 TikTok 和 CapCut,字节跳动拥有广阔的 AI 创新应用平台。

项目入口:https://grisoon.github.io/INFP/

划重点:

INFP 可以让静态人像通过音频实现 “说话”,自动判断对话角色。

该系统通过两个步骤工作:首先提取人类对话中的运动细节,其次将音频转换为自然的运动模式。

字节跳动的 DyConv 数据集包含超过200小时的高质量对话视频,帮助提升系统性能。

INFP 系统的推出展现了字节跳动在人工智能领域的创新实力,其未来发展潜力巨大,但也需要谨慎应对潜在的伦理风险。 技术的进步应始终以社会利益为导向,确保其被用于造福人类。