长视频理解一直是视频分析领域的一大挑战,传统的模型在处理长视频时效率低下,难以有效提取关键信息。本文介绍了一种名为HiCo的层次化视频标记压缩技术,以及基于该技术的“VideoChat-Flash”系统,该系统通过多阶段学习和改进的“干草堆中的针”任务,显着提升了长视频理解能力,并大幅降低了计算需求。研究团队构建了包含300,000小时视频和2亿字注释的大型数据集,用于模型训练和评估。

具体而言,HiCo通过将长视频分割成短片段并压缩冗余信息来降低计算复杂度,同时利用与用户查询的语义关联进一步减少处理的标记数量。 “VideoChat-Flash”采用多阶段学习方案,先用短视频进行监督微调,再逐步引入长视频训练,最终实现对混合长度语料的全面理解。 此外,改进的“干草堆中的针”任务提升了模型对上下文和多跳视频配置的理解能力。

在长视频处理的具体实现中,“VideoChat-Flash” 采用了一种多阶段的短视频到长视频的学习方案。研究人员首先使用短视频及其对应的注释进行监督微调,随后逐步引入长视频进行训练,最终实现了对混合长度语料的全面理解。这种方式不仅提高了模型的视觉感知能力,还为长视频的处理提供了丰富的数据支持,研究团队构建了一个包含300,000小时视频和2亿字注释的庞大数据集。

此外,研究中还提出了一种改进的“干草堆中的针” 任务,用于多跳视频配置。通过新的基准,模型不仅需要找到视频中的单一目标图像,还需理解多个相互关联的图像序列,从而提高了模型对上下文的理解能力。

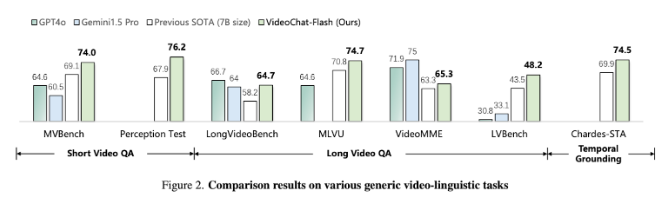

实验结果表明,所提出的方法在计算上减少了两个数量级,特别是在短视频和长视频的基准测试中表现出色,成为新的短视频理解领域的领导者。同时,该模型在长视频理解方面也超越了现有的开源模型,显示出强大的时间定位能力。

论文:https://arxiv.org/abs/2501.00574

划重点:

研究人员提出了层次化视频标记压缩技术HiCo,显着降低长视频处理的计算需求。

“VideoChat-Flash” 系统采用多阶段学习方法,结合短视频和长视频进行训练,提升了模型的理解能力。

实验结果显示,该方法在多个基准测试中达到了新的性能标准,成为长视频处理领域的先进模型。

总而言之,这项研究为高效的长视频理解提供了一种新的解决方案,HiCo技术和VideoChat-Flash系统在计算效率和模型性能方面都取得了显着的突破,为未来长视频分析应用奠定了坚实的基础。 该研究成果具有重要的理论意义和实际应用价值。