浙江大学和阿里巴巴达摩院联合推出了一项突破性研究:利用教学视频构建高质量多模态教科书数据集。这项研究旨在解决现有大型语言模型(VLMs)预训练数据知识密度低、图文关联性弱的问题,为VLMs提供更优质的训练素材,并革新教育资源的利用方式。该研究团队收集并处理了海量教学视频,最终构建了一个涵盖多个学科、总时长超过22000小时的高质量数据集,为人工智能在教育领域的应用提供了新的可能性。

近日,浙江大学与阿里巴巴达摩院联合发布了一项引人瞩目的研究,旨在通过教学视频创建高质量的多模态教科书。这一创新的研究成果不仅为大规模语言模型(VLMs)的训练提供了新的思路,也可能改变教育资源的利用方式。

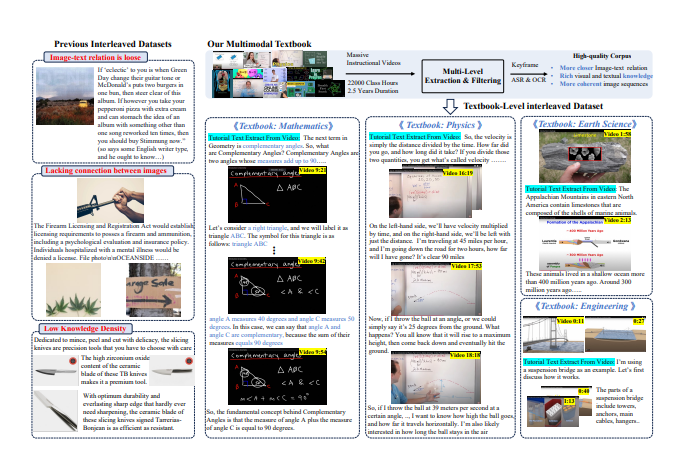

随着人工智能技术的迅猛发展,VLMs 的预训练语料主要依赖图文对数据与图文交织语料。然而,当前的这些数据多来自网页,文本与图像的关联性较弱,知识密度也相对较低,无法有效支持复杂的视觉推理。

为了应对这一挑战,研究团队决定从互联网上海量的教学视频中提炼高质量的知识语料。他们收集了超过15.9万个教学视频,经过精细的过滤和处理,最终保留了75,000个高质量视频,涵盖数学、物理、化学等多个学科,总时长超过22,000小时。

研究者们设计了一条复杂的 “视频到教科书” 处理管道。首先,使用自动语音识别(ASR)技术将视频中的讲解内容转录为文本,接着通过图像分析和文字匹配,筛选出与知识点高度相关的片段。最终,这些处理过的关键帧、OCR 文本和转录文本被交错组织,形成了一个内容丰富、结构严谨的多模态教科书。

这一研究的初步结果显示,与以往的网页中心数据集相比,新生成的教科书数据集在知识密度和图像关联性上显著提升,为 VLMs 的学习提供了更为坚实的基础。此外,研究还引起了学术界的广泛关注,相关数据集在 Hugging Face 平台上迅速攀升至热门榜单,短短两周内下载量便超过7000次。

通过这一创新的尝试,研究者们希望不仅能推动 VLMs 的发展,更能在教育资源的整合与应用上开启新的可能性。

论文地址:https://arxiv.org/pdf/2501.00958

这项研究成果不仅对人工智能领域具有重要意义,也为未来的教育模式改革提供了新的方向,预示着人工智能技术在教育领域的广泛应用前景。该数据集的开源也为全球研究者提供了宝贵的资源,促进了学术界的合作与交流。