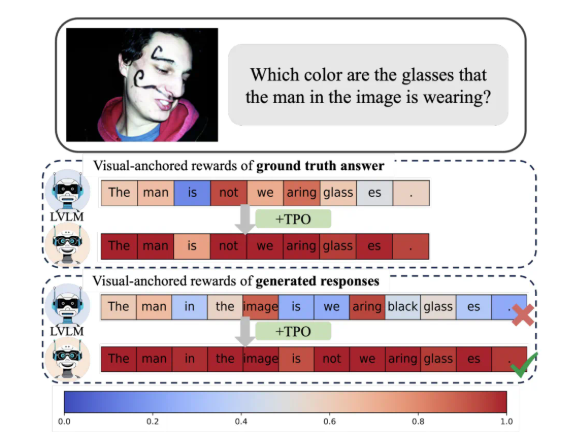

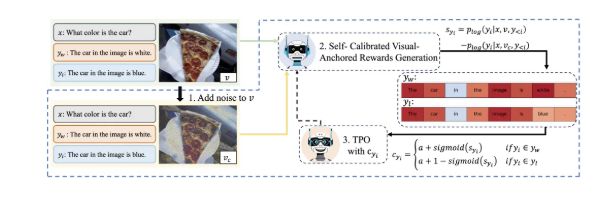

视觉大模型(LVLMs)在图像理解领域取得显着进展,但“幻觉现象”成为其发展瓶颈。淘天集团未来生活实验室团队针对这一问题,提出了一种名为“令牌偏好优化”(TPO)的新方法,该方法通过引入自校准的视觉锚定奖励机制,有效提升模型对视觉信息的依赖性,从而降低幻觉发生的概率。 TPO 的核心在于自动化令牌级奖励信号的生成,避免了繁琐的人工标注,并为每个令牌分配反映其与视觉信息依赖程度的奖励,提升模型性能。

TPO 的最大创新在于它实现了自动化的令牌级奖励信号。这一方法能够自动识别偏好数据中的视觉锚定令牌,避免了人工细粒度标注的繁琐,同时在训练过程中为每个令牌分配了反映其与视觉信息依赖程度的奖励。这一自校准的视觉锚定奖励信号,旨在优化模型对视觉信息的依赖性,从而有效减轻幻觉现象的发生。

研究表明,采用TPO 的模型在多个评测基准中显着优于传统的方法,尤其是在更复杂的任务中,模型生成的答案越来越依赖于图像信息而非语言模型的先验知识。这一进步不仅提升了模型的理解能力,也为进一步研究提供了重要的理论基础。

此外,研究团队还对TPO 的不同参数设置进行了消融实验,发现优化的加噪步骤和奖励分配策略能够进一步提高模型性能。这一发现无疑为未来的视觉大模型研究和应用指明了方向。

总之,淘天的这一创新成果为多模态对齐技术提供了新的思路,推动了AI 技术在生活和消费领域的深入应用。

通过TPO方法的应用,有效解决了视觉大模型的“幻觉”问题,提升了模型的可靠性和准确性,为未来视觉大模型的发展提供了新的方向,也为人工智能在实际生活中的应用奠定了坚实的基础,具有重要的理论意义和应用价值。该研究成果为多模态技术的发展贡献了新的力量。