在人工智能领域,对大型语言模型(LLM)的有效评估至关重要。然而,传统的评估方法往往难以满足实际应用需求。为了解决这一问题,Hugging Face 推出了一个名为 LightEval 的轻量级 AI 评估套件。LightEval 旨在帮助企业和研究人员更便捷、更有效地评估 LLM,确保模型的准确性和符合业务目标。它支持多种设备和自定义评估流程,并与 Hugging Face 的其他工具无缝集成,为 AI 开发提供了一个完整的流程。

最近,Hugging Face 推出了一个名为 LightEval 的新工具,这是一个轻量级的 AI 评估套件,旨在帮助企业和研究人员更好地评估大型语言模型(LLMs)。

随着 AI 技术在各个行业中变得愈加重要,如何有效地评估这些模型,确保其准确性和符合业务目标,就显得尤为重要。

通常来说,AI 模型的评估常常被低估。我们常常关注模型的创建和训练,但评估模型的方式同样至关重要。如果缺乏严谨且针对特定情境的评估,AI 系统就有可能输出不准确、有偏见或与业务目标不一致的结果。

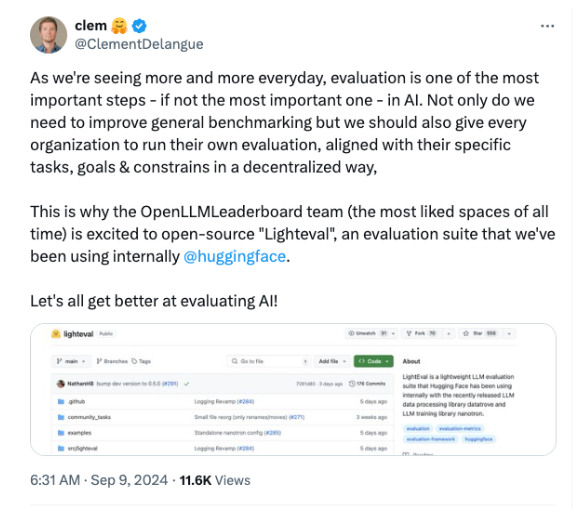

因此,Hugging Face 的 CEO Clément Delangue 在社交媒体上强调,评估不仅是一个最后的检查点,更是确保 AI 模型符合预期的基础。

如今,AI 已经不仅仅局限于研究实验室或科技公司,许多行业,如金融、医疗和零售等,都在积极采用 AI 技术。然而,很多企业在评估模型时常常面临挑战,因为标准化的基准测试往往无法捕捉实际应用中的复杂性。LightEval 正是为了解决这个问题而生,它允许用户根据自己的需求进行定制化评估。

这个评估工具与 Hugging Face 现有的一系列工具无缝集成,包括数据处理库 Datatrove 和模型训练库 Nanotron,提供了一个完整的 AI 开发流程。

LightEval 支持在多种设备上进行评估,包括 CPU、GPU 和 TPU,适应不同的硬件环境,满足企业的需求。

LightEval 的推出正值 AI 评估受到越来越多关注的时刻。随着模型的复杂性增加,传统评估技术逐渐显得力不从心。Hugging Face 的开源策略将使得企业能够自行运行评估,确保其模型在投入生产之前符合其道德和业务标准。

此外,LightEval 易于使用,即使是技术水平不高的用户也能上手。用户可以在多种流行基准上评估模型,甚至定义自己的自定义任务。而且,LightEval 还允许用户指定模型评估的配置,如权重、管道并行性等,给需要独特评估流程的公司提供了强大的支持。

项目入口:https://github.com/huggingface/lighteval

划重点:

Hugging Face 推出 LightEval,一个轻量级的 AI 评估套件,旨在提升评估的透明度和定制化。

LightEval 与现有工具无缝集成,支持多设备评估,适应不同硬件环境的需求。

这个开源工具使企业能够自行进行评估,确保模型符合其业务和道德标准。

LightEval 的开源和易用性,使其成为企业和研究人员评估 LLM 的有力工具,有助于推动 AI 技术的更安全、更可靠发展。 通过自定义评估流程和多设备支持,LightEval 满足了不同场景下的评估需求,为 AI 应用的落地提供了坚实保障。