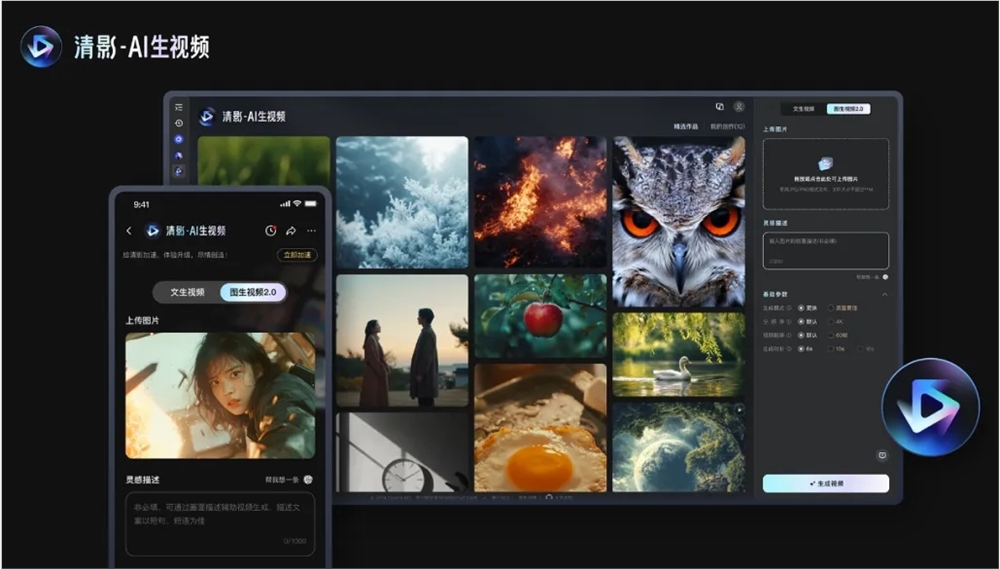

北京智谱华章科技有限公司重磅推出CogVideoX v1.5开源模型,该模型在视频生成领域取得显着突破。继8月初发布后,CogVideoX系列凭借其领先技术和开发者友好特性迅速成为行业焦点。此次更新带来了诸多改进,包括支持更长、更高清的视频生成,以及对图生视频质量和语义理解能力的大幅提升,为用户提供更优质的AI视频生成体验。 更值得关注的是,新版本整合了清影平台和CogSound音效模型,进一步完善了视频生成生态。

此次开源的内容包括两个模型:CogVideoX v1.5-5B和CogVideoX v1.5-5B-I2V。新版本也将同步上线到清影平台,并与新推出的CogSound音效模型结合,提供质量提升、超高清分辨率支持、可变比例适应不同播放场景、多通道输出以及带声效的AI视频等特色服务。

在技术层面,CogVideoX v1.5通过自动化筛选框架过滤了缺乏动态连通性的视频数据,并采用端到端的视频理解模型CogVLM2-caption生成精准的视频内容描述,提升了文本理解和指令遵循能力。此外,新版本采用了高效的三维变分自编码器(3D VAE)解决内容连贯性问题,并自主研发了融合文本、时间和空间三维度的Transformer架构,取消了传统的跨注意力模块,通过专家自适应层归一化技术优化了扩散模型中时间步信息的利用。

训练方面,CogVideoX v1.5构建了一个高效的扩散模型训练框架,通过多种并行计算和时间优化技术,实现了对长视频序列的快速训练。公司表示,他们已验证了scaling law在视频生成领域的有效性,并计划在未来扩大数据量和模型规模,探索创新模型架构,以更高效地压缩视频信息,并更好地融合文本与视频内容。

代码:https://github.com/thudm/cogvideo

模型:https://huggingface.co/THUDM/CogVideoX1.5-5B-SAT

CogVideoX v1.5的开源,为视频生成技术发展提供了新的动力,也为开发者提供了更强大的工具。 智谱华章持续的技术创新和开源精神值得肯定,未来该模型的应用前景值得期待。 期待更多基于CogVideoX v1.5的创新应用出现。