AMD最新发布的Strix Point APU系列处理器在AI大语言模型(LLM)应用方面展现出显着优势,性能超越英特尔Lunar Lake系列。该系列处理器针对移动平台设计,旨在提供更高的性能和更低的延迟,满足日益增长的AI工作负载需求。 AMD重点强调Ryzen AI处理器在处理LLM任务时的卓越表现,并推出LM Studio工具简化大语言模型的使用,降低用户门槛。

近日,AMD 发布了其最新的Strix Point APU 系列,强调该系列在AI 大语言模型(LLM)应用中的出色表现,远超英特的Lunar Lake 系列处理器。 AI 工作负载需求的不断增长,硬件的竞争愈发激烈。为了应对市场,AMD 推出了为移动平台设计的AI 处理器,旨在更高的性能更低的延迟。

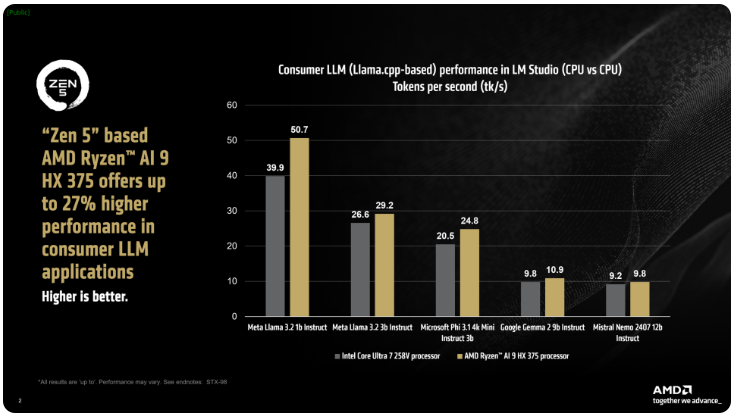

AMD 表示,ix Point 系列的Ryzen AI300处理器在处理AI LLM 任务时,能够显着提高每秒处理的Tokens 数量,相较于英特尔的Core Ultra258V,Ryzen AI9375的性能提升达到了27%。虽然Core Ultra7V 并不是L Lake 系列中最快型号,但其核心和线程数量接近于更高端的Lunar Lake 处理器,显示出AMD 产品在此领域的竞争力。

AMD 的LM Studio 工具一款面向消费者的应用,基llama.cpp 框架,旨在简化大语言模型的使用。该框架优化了x86CPU 的性能,虽然不需要GPU 就能运行LLM,但使用GPU 可以进一步加速处理速度。根据测试,Ryzen AI9HX375在Meta Llama3.21b Instruct 模型中,能够实现35倍更低延迟,每秒处理达到50.7个Tokens 比之下,Core Ultra7258V 仅为39.9个Tokens。

不仅如此,Strix Point APU 还配备强大的基于RDNA3.5构的Radeon 集成显卡,通过ulkan API 将任务卸载到iGPU 上,进一步提升LLM 的性能。利用变更图形内存(VGM)技术,Ryzen AI300处理器可优化内存分配,提高能效,最终实现达60% 的性能提升。

在对比测试中,AMD 在Intel AI Playground 平台上使用相同设置,发现Ryzen AI9HX375在Microsoft Phi3.1上比Core Ultra7258V 快87%,而在Mistral7b Instruct0.3模型中快13%。尽管如此,若与Lunar Lake 系列中的旗舰产品Core Ultra9288V 进行比较,结果将更加有趣。目前,AMD 正专注于通过LM Studio 使大语言模型的使用变得更加普及,旨在让更多非技术用户也能轻松上手。

划重点:

AMD Strix Point APUs 在AI LLM 应用中比英特尔Lunar Lake 提升了27% 的性能。

Ryzen AI9HX375在Meta Llama3.2模型中表现3.5倍更低的延迟。

LM Studio 工具旨在使大语言模型的使用变得更简单,适合非技术用户。

总而言之,AMD Strix Point APU 系列在AI LLM 应用领域的强劲表现,以及易于使用的LM Studio 工具,预示着AMD在AI硬件市场上的积极布局和竞争力,为消费者带来更便捷高效的AI体验。