近年来,人工智能(AI)在编程领域的应用日益广泛,但其能力仍存在一定的局限性。最近,BuzzFeed 的资深数据科学家Max Woolf 通过一系列实验发现,通过不断向大型语言模型(LLM)提供“写更好代码”的提示,AI 生成的代码质量可以得到显着提升。这一发现不仅在技术圈引发了热议,也引起了众多AI 科学家的关注,进一步凸显了迭代优化和提示词设计在AI 编程中的重要性。

在Woolf 的实验中,他选择了Claude3.5Sonnet 这一AI 模型作为研究对象。实验的第一步是让模型解决一个相对简单的编程问题:如何在一百万个随机整数中,找出各位数之和为30 的最小值与最大值之间的差值。 Claude 在接到任务后,迅速生成了符合要求的代码,但Woolf 认为这段代码仍有改进的空间。

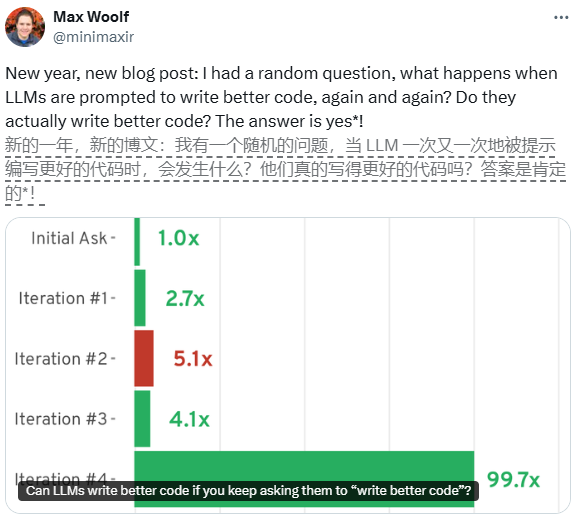

为了进一步优化代码,Woolf 决定在每次生成代码后,通过“写更好代码”的提示,要求Claude 进行迭代优化。第一次迭代后,Claude 将代码重构为一个面向对象的Python 类,并实现了两项显着的优化,使得代码的运行速度提高了2.7 倍。在第二次迭代中,Claude 进一步引入了多线程处理和向量化计算,最终使代码的运行速度达到了基础版本的5.1 倍。

然而,随着迭代次数的增加,代码质量的提升逐渐放缓。尽管模型在后续的迭代中尝试了更复杂的技术,如JIT 编译和异步编程,但这些优化并未带来预期的性能提升,甚至在某些情况下导致了性能的下降。这一现象表明,迭代提示虽然在早期阶段能够显着提升代码质量,但在达到一定水平后,其效果会逐渐减弱。

Woolf 的实验不仅展示了AI 在编程领域的巨大潜力,也揭示了其在实际应用中的局限性。尽管AI 能够通过不断迭代优化代码,但在设计提示词时,如何平衡性能与复杂性仍然是一个需要深入探讨的问题。这项研究为未来的AI 编程提供了新的思路,同时也提醒我们,AI 并非万能,合理的使用和优化策略才是关键。