在多模态大语言模型(MLLMs)的迅猛发展下,图像和视频相关任务迎来了前所未有的突破,尤其是在视觉问答、叙述生成和交互式编辑等领域。然而,尽管这些技术取得了显着进展,实现细粒度的视频内容理解仍然是一个亟待解决的难题。这一挑战不仅涉及像素级的分割和带有语言描述的跟踪,还包括在特定视频提示上进行视觉问答等复杂任务。

尽管当前最先进的视频感知模型在分割和跟踪任务上表现出色,但它们在开放式语言理解和对话能力方面仍显不足。视频MLLMs 虽然在视频理解和问答任务上表现良好,但在处理感知任务和视觉提示方面依然力不从心。这种局限性限制了它们在更广泛场景中的应用。

现有的解决方案主要分为两类:多模态大语言模型(MLLMs)和引用分割系统。 MLLMs 最初致力于改进多模态融合方法和特征提取器,逐渐发展为在LLMs 上进行指令调优的框架,如LLaVA。近期,研究人员尝试将图像、视频和多图像分析统一到单一框架中,如LLaVA-OneVision。同时,引用分割系统也经历了从基本融合模块到集成分割和跟踪的变革。然而,这些解决方案在感知和语言理解能力的全面整合上仍存在不足。

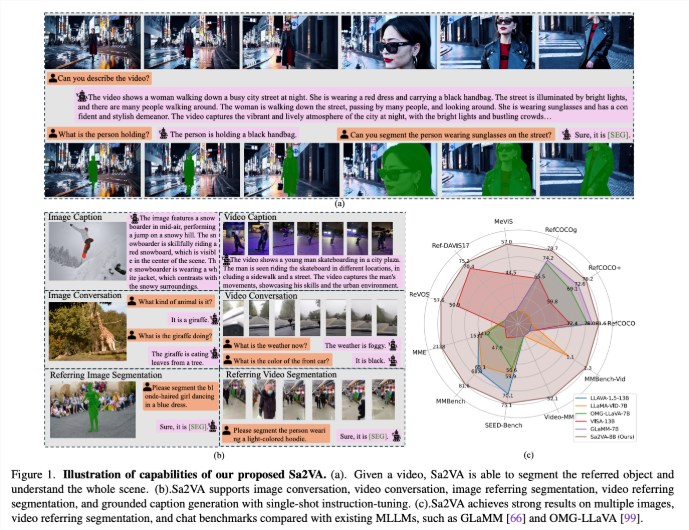

来自UC Merced、字节跳动种子团队、武汉大学和北京大学的研究人员提出了Sa2VA,这是一种开创性的统一模型,旨在实现图像和视频的密集基础理解。该模型通过最小化一次性指令调优,支持广泛的图像和视频任务,克服了现有多模态大语言模型的局限性。

Sa2VA 创新性地将SAM-2 与LLaVA 整合,将文本、图像和视频统一到共享的LLM 令牌空间中。此外,研究人员还推出了一个名为Ref-SAV 的广泛自动标注数据集,包含超过72K 个复杂视频场景中的对象表达,以及2K 个经过人工验证的视频对象,以确保稳健的基准能力。

Sa2VA 的架构主要由两个部分组成:类似LLaVA 的模型和SAM-2,采用了一种新颖的解耦设计。 LLaVA-like 组件包括处理图像和视频的视觉编码器、视觉投影层以及用于文本令牌预测的LLM。该系统采用独特的解耦方式,使得SAM-2 在预训练的LLaVA 模型旁边运作,而不进行直接的令牌交换,从而保持计算效率,并允许与各种预训练的MLLMs 进行插拔式功能连接。

研究结果表明,Sa2VA 在引用分割任务中取得了最先进的结果,其Sa2VA-8B 模型在RefCOCO、RefCOCO + 和RefCOCOg 上的cIoU 评分分别为81.6、76.2和78.9,超越了GLaMM-7B 等之前的系统。在对话能力方面,Sa2VA 在MME、MMbench 和SEED-Bench 上分别取得了2128、81.6和75.1的优异成绩。

此外,Sa2VA 在视频基准测试中的表现也显着超过了之前的状态- of-the-art VISA-13B,显示出其在图像和视频理解任务中的高效性与有效性。

论文:https://arxiv.org/abs/2501.04001

模型:https://huggingface.co/collections/ByteDance/sa2va-model-zoo-677e3084d71b5f108d00e093

划重点:

Sa2VA 是一个新颖的统一AI 框架,实现了图像与视频的深度理解,克服了现有多模态模型的局限性。

该模型在引用分割和对话能力等多项基准测试中均取得了最先进的成绩,展现了出色的性能。

Sa2VA 的设计通过解耦的方式有效整合了视觉和语言理解能力,支持广泛的图像与视频任务。