近日,VITA-MLLM 团队发布了其最新研究成果VITA-1.5,这一版本在VITA-1.0 的基础上进行了全面升级,特别是在多模态交互的实时性和准确性方面取得了显着进展。 VITA-1.5 不仅支持英语和中文两种语言,还在多项性能指标上实现了质的飞跃,为用户带来了更加流畅和高效的交互体验。

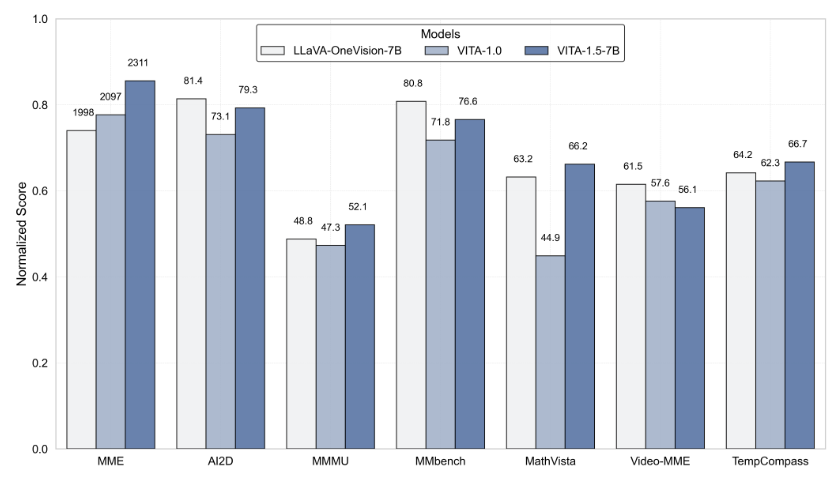

VITA-1.5 在互动延迟方面取得了重大突破,将原本的4秒延迟大幅缩短至仅1.5秒。这一改进使得用户在语音交互过程中几乎感受不到任何延迟,极大地提升了用户体验。此外,VITA-1.5 在多模态性能方面也有显着提升,经过MME、MMBench 和MathVista 等多个基准测试的评估,其平均性能从59.8提升至70.8,展现出卓越的多模态处理能力。

在语音处理方面,VITA-1.5 也进行了深度优化。其自动语音识别(ASR)系统的错误率从18.4降至7.5,显着提高了语音指令的理解和响应准确性。同时,VITA-1.5 引入了一个全新的端到端文本转语音(TTS)模块,该模块能够直接接收大型语言模型(LLM)的嵌入作为输入,从而大幅提升了语音合成的自然度和连贯性。

为了确保多模态能力的平衡,VITA-1.5 采用了渐进式训练策略,使得新增的语音处理模块对视觉-语言表现的影响最小,图像理解性能仅从71.3轻微下降至70.8。通过这些技术创新,VITA-1.5 进一步推动了实时视觉与语音交互的边界,为未来的智能交互应用奠定了坚实的基础。

对于开发者而言,VITA-1.5 的使用非常便捷。开发者可以通过简单的命令行操作快速上手,并且团队还提供了基础和实时互动演示,帮助用户更好地理解和使用该系统。为了进一步提升实时交互体验,用户需要准备一些必要的模块,例如语音活动检测(VAD)模块。此外,VITA-1.5 的代码将全面开源,方便广大开发者参与和贡献,共同推动这一技术的进步。

VITA-1.5 的推出标志着交互式多模态大语言模型领域的又一重要里程碑,展现了VITA-MLLM 团队在技术创新和用户体验上的不懈追求。这一版本的发布不仅为用户带来了更加智能化的交互体验,也为未来的多模态技术发展指明了方向。

项目入口:https://github.com/VITA-MLLM/VITA?tab=readme-ov-file

划重点:

VITA-1.5大幅降低互动延迟,从4秒缩短至1.5秒,显着提升用户体验。

多模态性能提升,多个基准测试的平均性能从59.8提升至70.8。

语音处理能力增强,ASR 错误率从18.4降至7.5,语音识别更准确。