随着人工智能技术的飞速发展,大语言模型(LLM)在现代应用中扮演着越来越重要的角色。无论是聊天机器人、代码生成器,还是其他基于自然语言处理的任务,LLM 的能力都成为了核心驱动力。然而,随着模型规模的不断扩大和复杂度的提升,推理过程中的效率问题逐渐凸显,尤其是在处理大规模数据和复杂计算时,延迟和资源消耗成为了亟待解决的瓶颈。

注意力机制作为 LLM 的核心组件,其性能直接影响到模型的推理效率。然而,传统的注意力机制如 FlashAttention 和 SparseAttention 在面对多样化的工作负载、动态输入模式以及 GPU 资源限制时,往往表现不佳。高延迟、内存瓶颈以及资源利用率低等问题,严重制约了 LLM 推理的可扩展性和响应速度。因此,开发一种高效、灵活的解决方案成为了当前研究的重点。

为了应对这一挑战,来自华盛顿大学、NVIDIA、Perplexity AI 和卡内基梅隆大学的研究团队共同开发了 FlashInfer。这是一个专门为 LLM 推理设计的人工智能库和内核生成器,旨在通过高性能的 GPU 内核实现,优化多种注意力机制,包括 FlashAttention、SparseAttention、PageAttention 及采样。FlashInfer 的设计理念强调灵活性和效率,能够有效应对 LLM 推理服务中的关键挑战,为大规模语言模型的推理提供了切实可行的解决方案。

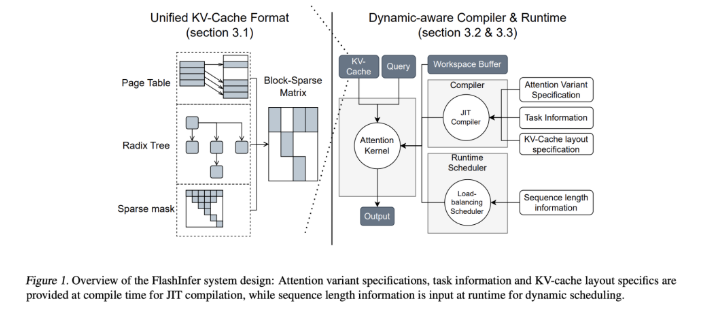

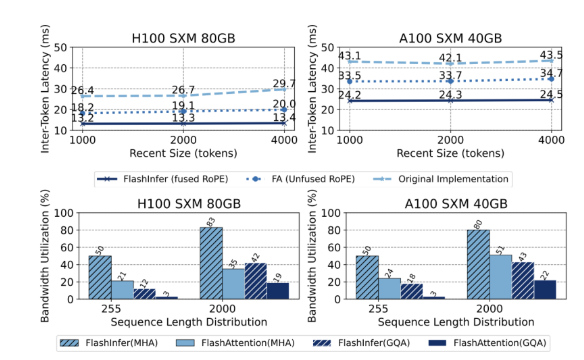

FlashInfer 的核心技术特点包括以下几个方面:首先,它提供了全面的注意力内核支持,涵盖预填充、解码和追加注意力等多种机制,同时兼容各种 KV-cache 格式,显著提升了单请求和批量服务场景的性能。其次,通过分组查询注意力(GQA)和融合的旋转位置嵌入(RoPE)注意力,FlashInfer 在长提示解码方面实现了显著的性能提升,比 vLLM 的 Page Attention 实现快31倍。此外,FlashInfer 的动态负载平衡调度器能够根据输入变化动态调整,减少 GPU 空闲时间,确保资源的高效利用。其与 CUDA Graphs 的兼容性进一步提升了在生产环境中的适用性。

在性能方面,FlashInfer 在多个基准测试中表现出色,特别是在处理长上下文推理和并行生成任务时,显著减少了延迟。在 NVIDIA H100 GPU 上,FlashInfer 在并行生成任务中实现了13-17% 的速度提升。其动态调度器和优化的内核显著改善了带宽和 FLOP 利用率,无论是在序列长度不均还是均匀的情况下,都能够高效利用 GPU 资源。这些优势使得 FlashInfer 成为了推动 LLM 服务框架发展的重要工具。

作为一个开源项目,FlashInfer 不仅为 LLM 推理挑战提供了高效的解决方案,还鼓励研究界的进一步合作与创新。其灵活的设计和集成能力,使其能够适应不断变化的人工智能基础设施需求,确保在应对新兴挑战时保持领先地位。通过开源社区的共同努力,FlashInfer 有望在未来的 AI 技术发展中发挥更加重要的作用。

项目入口:https://github.com/flashinfer-ai/flashinfer

划重点:

FlashInfer 是一个新发布的人工智能库,专为大语言模型推理设计,能显著提升效率。

该库支持多种注意力机制,优化了 GPU 资源利用,减少了推理延迟。

FlashInfer 作为开源项目,欢迎研究者共同参与,推动 AI 基础设施的创新与发展。