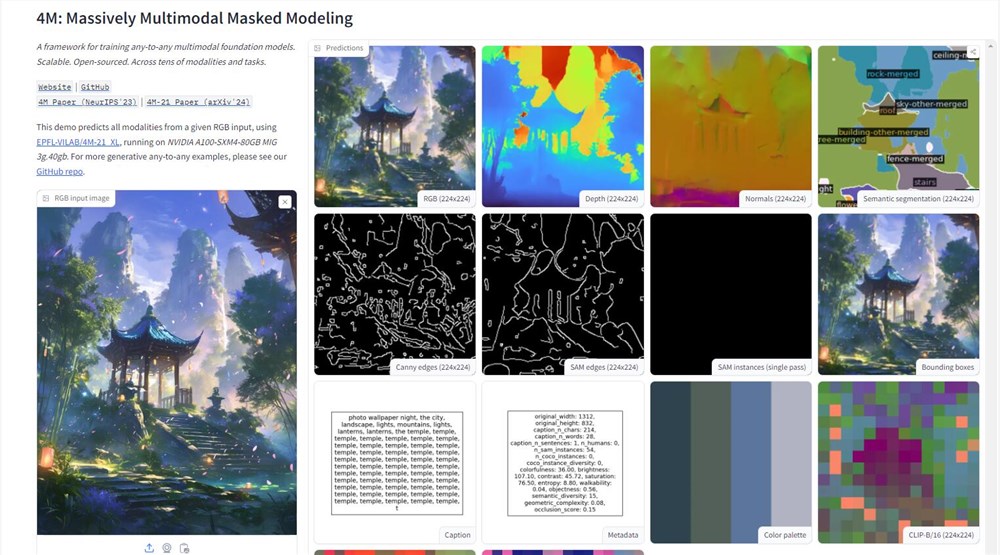

苹果公司在人工智能领域迈出了重要一步,他们在Hugging Face平台上公开了4M模型的演示。这一多模态AI模型能够处理文本、图像和3D场景等多种数据类型,展现出强大的信息处理能力。通过上传一张图片,用户可以轻松获取图片的深度图、线稿等详细信息,这标志着苹果在AI技术应用上的重大突破。

4M模型的技术核心在于其"大规模多模态屏蔽建模"训练方法。这种方法允许模型同时处理多种视觉模态,将图像、语义和几何信息转化为统一的tokens,从而实现不同模态间的无缝对接。这种设计不仅提高了模型的通用性,也为未来的多模态AI应用开辟了新的可能性。

苹果此举打破了其在研发领域一贯的保密传统,主动在开源AI平台上展示技术实力。通过开放4M模型,苹果不仅展示了其AI技术的先进性,还向开发者社区抛出了橄榄枝,希望围绕4M构建一个繁荣的生态系统。这预示着苹果生态系统中可能会出现更多智能化的应用,如更智能的Siri和更高效的Final Cut Pro。

然而,4M模型的推出也带来了数据实践和AI伦理方面的挑战。作为一个数据密集型的AI模型,如何在推动技术进步的同时保护用户隐私,将是苹果需要认真考虑的问题。苹果一直以用户隐私保护者自居,面对这一挑战,他们需要在技术创新和用户信任之间找到平衡点。

在训练方法上,4M采用了一种创新的随机选择标记的方式:将部分标记作为输入,另一部分作为目标,从而实现训练目标的可扩展性。这种设计使得4M能够将图片和文本都视为数字标记,大大提升了模型的灵活性和适应性。

4M模型的训练数据来源于全球最大的开源数据集之一CC12M。虽然该数据集数据丰富,但标注信息并不完善。为了解决这个问题,研究人员采用了弱监督伪标签的方法,利用CLIP、MaskRCNN等技术对数据集进行全面预测,再将预测结果转化为tokens,为4M的多模态兼容打下了坚实基础。

经过广泛的实验和测试,4M已经证明了自己能够直接执行多模态任务,无需进行大量的特定任务预训练或微调。这就像是给了AI一个多模态的瑞士军刀,让它能够灵活应对各种挑战。4M的推出不仅展示了苹果在AI领域的技术实力,也为未来AI应用的发展指明了方向。

演示地址:https://huggingface.co/spaces/EPFL-VILAB/4M