Downcodes小編獲悉,通義千問團隊近日開源了其最新的Qwen2.5-Coder全系列模型,這標誌著開源大模型領域另一個里程碑事件的發生。 Qwen2.5-Coder系列模型因其強大的程式碼能力、多樣的功能以及便捷的實用性而備受矚目,其在程式碼生成、修復和推理等方面均展現出卓越的性能,為開發者提供了強大的工具,推動了Open Code LLMs的進一步發展。此系列模型的開源,將大大促進人工智慧技術在程式設計領域的應用和創新。

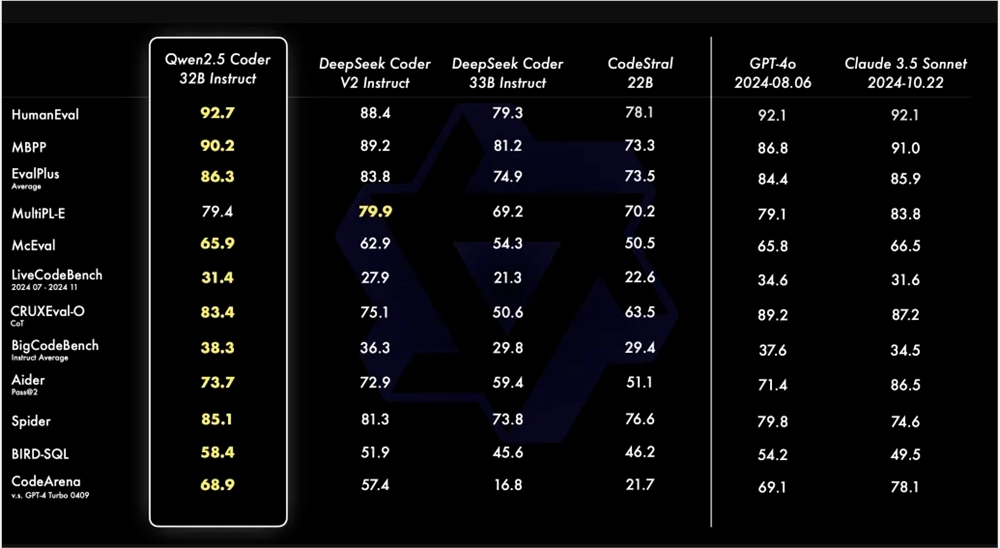

通義千問團隊近日宣布開源其最新的Qwen2.5-Coder全系列,這項舉措旨在推動Open Code LLMs的發展。 Qwen2.5-Coder以其強大、多樣和實用性受到關注。 Qwen2.5-Coder-32B-Instruct模型在代碼能力上達到了SOTA水平,與GPT-4o相當,展現出全面的能力,包括代碼生成、代碼修復和代碼推理。它在多個程式碼產生基準測試中取得了最佳表現,並在Aider基準測試中達到73.7分,與GPT-4o表現相當。

Qwen2.5-Coder支援超過40種程式語言,並在McEval上獲得65.9分,其中Haskell、Racket等語言的表現尤為突出。這得歸功於其預訓練階段獨特的資料清洗和配比。此外,Qwen2.5-Coder-32B-Instruct在多程式語言的程式碼修復能力上也表現出色,在MdEval基準測試中得分75.2,排名第一。

為了檢驗Qwen2.5-Coder-32B-Instruct在人類偏好上的對齊表現,建構了一個內部標註的程式碼偏好評估基準Code Arena。結果顯示Qwen2.5-Coder-32B-Instruct在偏好對齊方面具有優勢。

Qwen2.5-Coder系列此次開源了四個尺寸的模型,包括0.5B/3B/14B/32B,涵蓋了主流的六個模型尺寸,滿足不同開發者的需求。官方提供了Base和Instruct兩種模型,前者作為開發者微調模型的基礎,後者作為官方對齊的聊天模型。模型尺寸與效果之間存在正相關,Qwen2.5-Coder在所有尺寸下都取得了SOTA表現。

Qwen2.5-Coder的0.5B/1.5B/7B/14B/32B模型採用Apache2.0許可,而3B模型為Research Only許可。團隊透過評估不同尺寸的Qwen2.5-Coder在所有資料集上的表現,驗證了Scaling在Code LLMs上的有效性。

Qwen2.5-Coder的開源,為開發者提供了一個強大、多樣化且實用的程式設計模型選擇,有助於推動程式語言模型的發展和應用。

Qwen2.5-Coder模型連結:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

總之,Qwen2.5-Coder的開源為開發者帶來了強大的工具,其卓越的性能和廣泛的適用性將極大地推動程式碼產生和程式設計領域的發展。 期待未來Qwen2.5-Coder能夠在更多應用程式場景中發揮作用。