麻省理工學院的一項最新研究揭示了大型語言模型(LLM)內部結構與人腦的驚人相似性,這引發了人工智慧領域的一場熱議。 Downcodes小編將為您詳細解讀這項研究的突破性發現,以及其對未來AI發展的重要性。研究人員透過對LLM活化空間的深入分析,發現了三個層級的結構特徵,這些特徵的發現,將有助於我們更好地理解LLM的工作機制,並為未來AI技術的發展提供新的方向。

AI 竟然開始「長腦子」了?!麻省理工學院的最新研究表明,大型語言模型(LLM)的內部結構,竟然和人腦有著驚人的相似之處!

這項研究利用稀疏自編碼器技術,對LLM的激活空間進行了深入分析,發現了三個層級的結構特徵,令人驚嘆:

首先,在微觀層面上,研究人員發現了類似「晶體」結構的存在。這些「晶體」的面是由平行四邊形或梯形構成,類似於我們熟知的詞彙類比,例如「男人:女人::國王:女王」。

更令人驚訝的是,透過線性判別分析技術去除一些無關的干擾因素(如詞語長度)後,這些「晶體」結構會變得更加清晰。

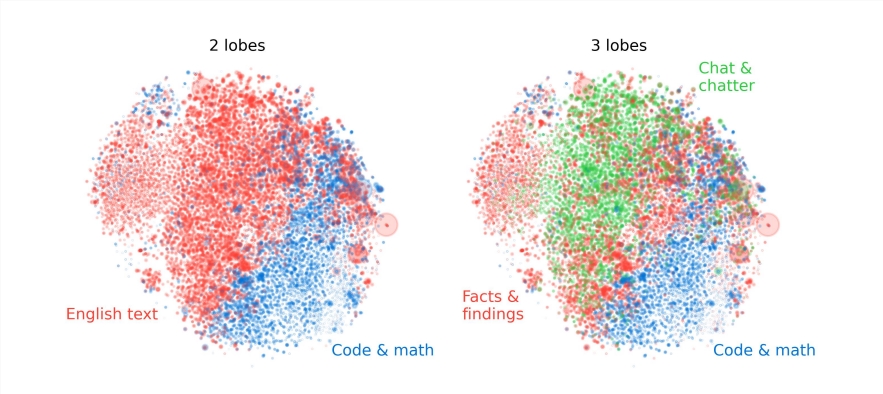

其次,在中觀層面上,研究人員發現LLM的活化空間存在著類似人腦功能分區的模組化結構。

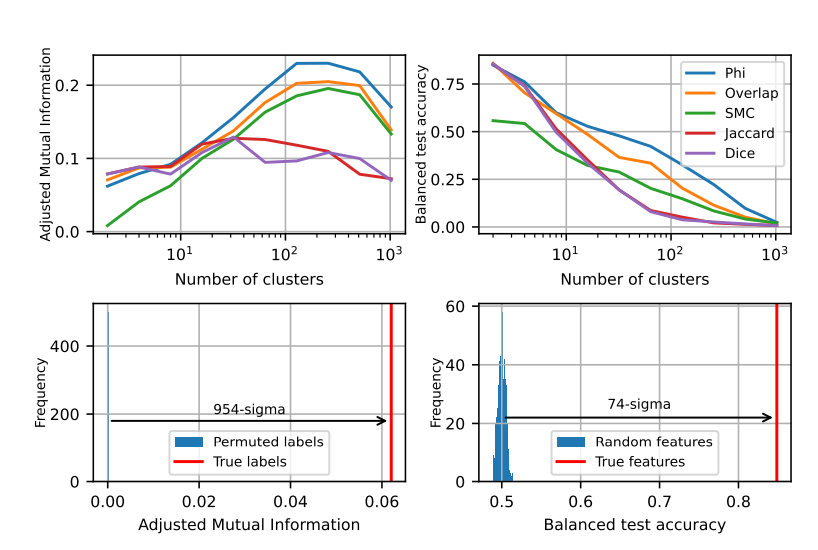

例如,與數學和程式碼相關的特徵會聚集在一起,形成一個類似人腦功能葉的「腦葉」。透過多種指標進行量化分析,研究人員證實了這些「腦葉」的空間局部性,顯示共同出現的特徵在空間上也更加聚集,遠遠超出了隨機分佈的預期。

在宏觀層面上,研究人員發現LLM特徵點雲的整體結構並非各向同性,而是呈現出一種冪律特徵值分佈,且這種分佈在中間層最為明顯。

研究人員也量化分析了不同層級的聚類熵,發現中間層的聚類熵較低,顯示特徵表示更加集中,而早期和晚期層的聚類熵較高,顯示特徵表示更加分散。

這項研究為我們理解大型語言模型的內部機制提供了全新的視角,也為未來開發更強大、更聰明的AI系統奠定了基礎。

這項研究成果令人振奮,它不僅加深了我們對大型語言模型的理解,也為未來人工智慧的發展指明了新的方向。 Downcodes小編相信,隨著科技的不斷進步,人工智慧將在更多領域展現出其強大的潛力,為人類社會帶來更美好的未來。