即時與AI互動是人工智慧領域的一大挑戰,尤其是在整合多模態資訊並保持對話流暢性方面。現有許多AI系統在即時對話的流暢性、上下文理解和多模態理解方面仍有不足,這限制了它們的實際應用。 Downcodes小編將為您介紹Fixie AI推出的Ultravox v0.4.1,一個旨在解決這些問題的開源多模態模型系列。

在人工智慧的應用中,如何實現與AI 的即時互動一直是開發者和研究人員面臨的重大挑戰。這其中,整合多模態訊息(如文字、影像和音訊)以形成一個連貫的對話系統顯得特別複雜。

儘管像GPT-4這樣的先進大型語言模型取得了一些進展,但許多AI 系統在實現即時對話流暢性、上下文意識以及多模態理解方面仍然存在困難,這限制了它們在實際應用中的效果。此外,這些模型的運算需求也使得在沒有大量基礎架構支援的情況下實現即時部署變得極為困難。

為了解決這些問題,Fixie AI 推出了Ultravox v0.4.1,這是一個專為實現與AI 的即時對話而設計的多模態開源模型系列。

Ultravox v0.4.1具備處理多種輸入格式(如文字、影像等)的能力,旨在提供一個封閉來源模型如GPT-4的替代方案。此版本不僅關注語言能力,還著重於在不同媒體類型之間實現流暢、具有上下文意識的對話。

作為開源項目,Fixie AI 希望透過Ultravox 讓全球開發者和研究人員能夠平等地獲取最先進的對話技術,適用於從客戶支援到娛樂等多種應用。

Ultravox v0.4.1模型基於最佳化的變換器架構,能夠並行處理多種資料。透過使用一種稱為跨模態注意力的技術,這些模型可以同時整合和解釋來自不同來源的資訊。

這意味著使用者可以向AI 展示一張影像,詢問相關問題,並即時獲得有依據的答案。 Fixie AI 在Hugging Face 上託管了這些開源模型,方便開發者進行存取和實驗,並提供了詳細的API 文檔,以促進在實際應用中的無縫整合。

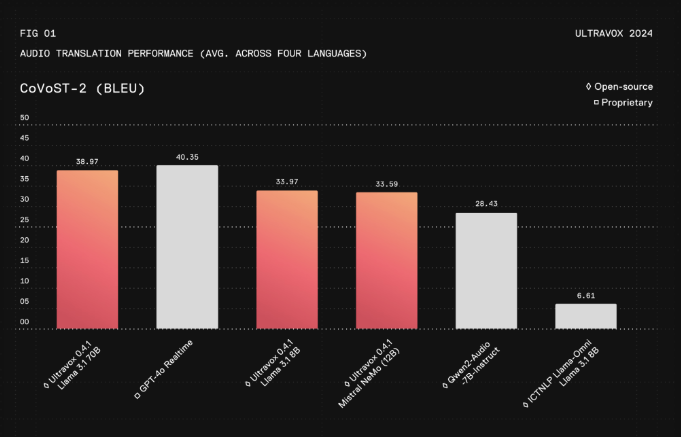

根據最近的評估數據,Ultravox v0.4.1在響應延遲上取得顯著降低,速度比領先的商業模型快約30%,同時保持相當的準確性和上下文理解能力。此模型的跨模態能力使其在複雜用例中表現出色,例如在醫療保健領域將圖像與文字結合進行綜合分析,或在教育領域提供豐富的互動內容。

Ultravox 的開放性促進了社區驅動的發展,增強了靈活性並推動了透明度。透過減輕部署此模式所需的運算負擔,Ultravox 讓先進的對話AI 變得更加可及,尤其對小型企業和獨立開發者而言,打破了以往因資源限製而產生的障礙。

專案頁:https://www.ultravox.ai/blog/ultravox-an-open-weight-alternative-to-gpt-4o-realtime

模型:https://huggingface.co/fixie-ai

總而言之,Ultravox v0.4.1為開發者提供了一個強大的、易於訪問的即時多模態對話AI模型,其開源性質和高效的性能有望推動人工智慧領域的發展。 請造訪專案頁面和Hugging Face以了解更多資訊。