智源研究院Emu3團隊發布了革命性的多模態模型Emu3,它顛覆了傳統的多模態模型架構,僅基於下一個token預測進行訓練,並在生成和感知任務上取得了SOTA的性能。 Emu3團隊巧妙地將圖像、文字和視訊標記化到離散空間中,並在混合的多模態序列上訓練單一Transformer模型,實現了多模態任務的統一,無需依賴擴散或組合架構,這為多模態領域帶來了新的突破。

來自智源研究院的Emu3團隊發布了一套全新的多模態模型Emu3,該模型僅基於下一個token預測進行訓練,顛覆了傳統的擴散模型和組合模型架構,在生成和感知任務上均取得了最先進的性能。

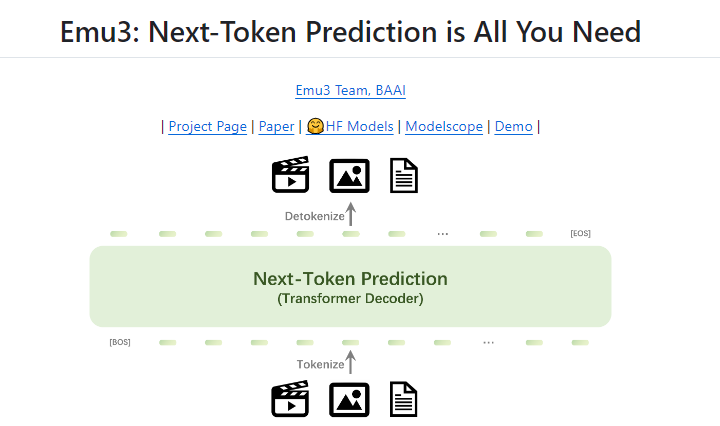

一直以來,下一個token預測被認為是通往人工智慧通用智慧(AGI)的希望之路,但在多模態任務上卻表現不佳。目前,多模態領域仍由擴散模型(如Stable Diffusion)和組合模型(如CLIP與LLM的結合)所主導。 Emu3團隊將圖像、文字和視訊都標記化到離散空間中,並在混合的多模態序列上從頭開始訓練單一Transformer模型,從而實現了多模態任務的統一,無需依賴擴散或組合架構。

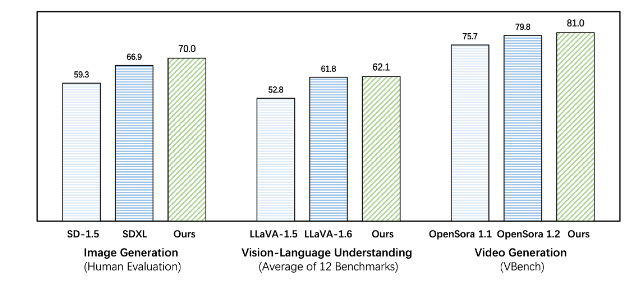

Emu3在生成和感知任務上的表現都超越了現有的特定任務模型,甚至超越了SDXL和LLaVA-1.6等旗艦模型。 Emu3也能夠透過預測視訊序列中的下一個token來產生高保真視訊。 有別於Sora使用視頻擴散模型從噪音中產生視頻,Emu3透過預測視頻序列中的下一個token,以因果的方式產生視頻。該模型可以模擬現實世界中環境、人物和動物的某些方面,並在給定視訊上下文的情況下,預測接下來會發生什麼。

Emu3簡化了複雜的多模態模型設計,將重點集中在token上,從而釋放了訓練和推理過程中的巨大擴展潛力。 研究結果表明,下一個token預測是建構超越語言的通用多模態智能的有效途徑。為了支持該領域進一步的研究,Emu3團隊開源了關鍵技術和模型,包括一個強大的視覺標記器,可以將視訊和圖像轉換為離散token,這在以前是公開不可用的。

Emu3的成功為多模態模型的未來發展指明了方向,也為實現AGI帶來了新的希望。

專案地址:https://github.com/baaivision/Emu3

Downcodes小編總結:Emu3模型的出現,標誌著多模態領域一個新的里程碑。其簡潔的架構和強大的性能,為未來AGI的研究提供了新的思路和方向。開源的策略也促進了學術界和工業界的共同發展,值得期待後續的更多突破!